Logistics迴歸與線性迴歸

1. Logistics迴歸與線性迴歸

線性迴歸就是給定n個變數x,經過一些線性組合後得到一個預測值y,而Logistics迴歸實際則是一個二分類問題,將線性迴歸預測的值通過一個sigmod函式,程式設計了(0,1)之間的概率,然後規定大於0.5的分為1類,小於0.5的歸為0類。

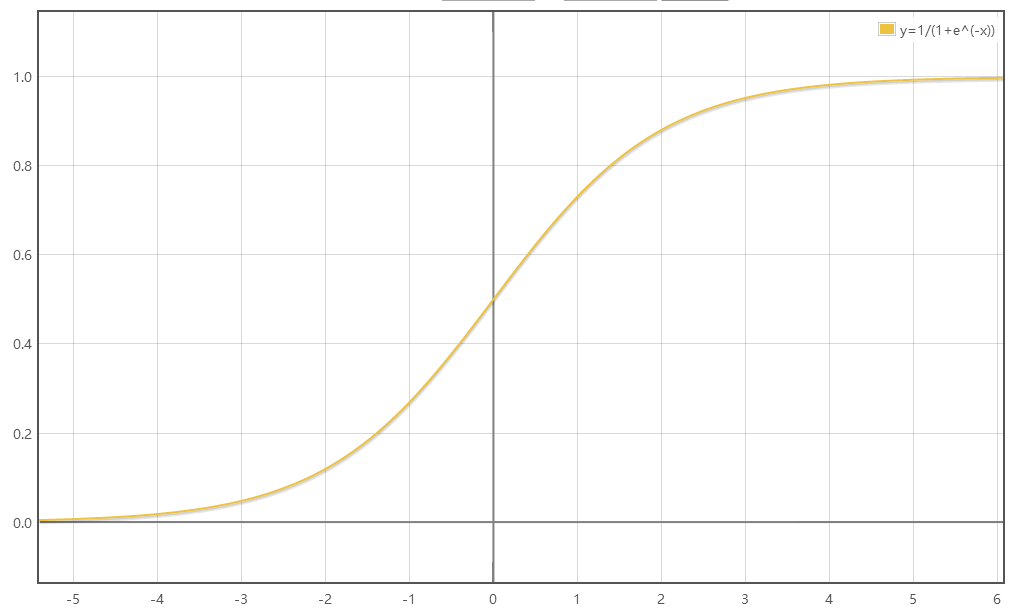

sigmod函式表示式:,下圖是sigmod影象。

相關推薦

Logistics迴歸與線性迴歸

1. Logistics迴歸與線性迴歸 線性迴歸就是給定n個變數x,經過一些線性組合後得到一個預測值y,而Logistics迴歸實際則是一個二分類問題,將線性迴歸預測的值通過一個sigmod函式,程式設計了(0,1)之間的概率,然後規定大於0.5的分為1類,小於0.5的歸為0類。 sig

機器學習4:邏輯迴歸與線性迴歸

邏輯迴歸與線性迴歸求解過程: 總體來說,迴歸過程都分三步: 1、Model 2、Loss Fuction 3、Gradient Decent 分析: 1、Model:線性迴歸中,模型為線性方程,取值範圍無窮大;邏輯迴歸中,通過sigmod函式函式將線性方程z轉化成概率(

機器學習演算法的Python實現 (1):logistics迴歸 與 線性判別分析(LDA)

本文為筆者在學習周志華老師的機器學習教材後,寫的課後習題的的程式設計題。之前放在答案的博文中,現在重新進行整理,將需要實現程式碼的部分單獨拿出來,慢慢積累。希望能寫一個機器學習演算法實現的系列。 本文主要包括: 1、logistics迴歸 2、線性判別分析(LDA) 使

機器學習 --- 線性迴歸與邏輯迴歸

線性迴歸和邏輯迴歸在機器學習上是一種監督式學習。在預測類問題上,我們希望能通過一個對映關係 ,當給定變數 ,能得到一個較為滿意的預測結果 ,迴歸方法旨在找到能表示樣本空間分佈的對映關係。 一、線性迴歸的基本形式

線性迴歸與邏輯迴歸的區別

線性迴歸 以經典的預測房價為例, 假設樣本為(X,yiX, y_iX,yi),其中X是多維變數(X=(x1,x2...xn)X = (x_1, x_2...x_n)X=(x1,x2...xn))

【機器學習】正則化的線性迴歸 —— 嶺迴歸與Lasso迴歸

注:正則化是用來防止過擬合的方法。在最開始學習機器學習的課程時,只是覺得這個方法就像某種魔法一樣非常神奇的改變了模型的引數。但是一直也無法對其基本原理有一個透徹、直觀的理解。直到最近再次接觸到這個概念,經過一番苦思冥想後終於有了我自己的理解。 0. 正則化(

Machine Learning--week3 邏輯迴歸函式(分類)、決策邊界、邏輯迴歸代價函式、多分類與(邏輯迴歸和線性迴歸的)正則化

Classification It's not a good idea to use linear regression for classification problem. We can use logistic regression algorism, which is a classificati

線性迴歸與嶺迴歸python程式碼實現

一、標準線性迴歸 線上性迴歸中我們要求的引數為: 所以程式碼實現主要就是實現上式,python程式碼如下: import numpy as np import pandas as pd import matplotlib.pyplot as plt # implem

Pytorch學習筆記(三)線性迴歸與邏輯迴歸

在瞭解了Pytorch的一些機制後,當然要進行一些例項的學習,畢竟實踐出真知嘛。 對於所有的機器學習愛好者來說,第一個要學的模型無疑是線性迴歸 所謂線性迴歸,指的就是用對輸入資料的每個維度進行線性組合擬合Label-y。最簡單的線性迴歸即是二維平面內的直線擬

機器學習_最小二乘法,線性迴歸與邏輯迴歸

1. 線性迴歸 線性迴歸是利用數理統計中迴歸分析,來確定兩種或兩種以上變數間相互依賴的定量關係的一種統計分析方法。 直觀地說,在二維情況下,已知一些點的X,Y座標,統計條件X與結果Y的關係,畫一條直線,讓直線離所有點都儘量地近(距離之和最小),用直線抽象地表達這些點,然後對新的X預測新的Y。具體實現一般

線性迴歸與邏輯迴歸、softmax迴歸

1.線性迴歸 預測函式: hθ(x)=θ0+θ1xh_\theta(x)=\theta_0+\theta_1xhθ(x)=θ0+θ1x 1.1 梯度下降法 損失函式(均方差損失函式): minJ(θ)=12m∑i=1m(hθ(xi)−yi)2\min J

線性迴歸與邏輯迴歸的區別與聯絡

logistics本質是線性迴歸,只不過特徵到結果加了一層對映。即先把特徵線性求和,在用Sigmoid函式將結果對映到 [0,1] 如果隨機變數X只取0和1兩個值,並且相應的概率為: 則稱隨機變數X服從引數為p的伯努利分佈,若令q=1一p,則X的概率函式可寫 為:

線性迴歸與邏輯迴歸

也可以配合這篇文章(CS229學習筆記)進行學習。 目錄 1 迴歸問題 2 虛擬變數 3 迴歸診斷 1 迴歸問題 分類:一元線性迴歸;多元線性(用曲面擬合);廣義線性迴歸(用線性迴歸方法處理非線性迴歸問題);非線性迴歸

tensorflow example 入門例子(線型迴歸與邏輯迴歸)

1. 前言–線性迴歸與邏輯迴歸介紹 tensorflow一般入門都至少會講兩種例子,一個是線型迴歸,一個是邏輯迴歸。(或者也可以說,迴歸演算法 & 分類演算法) 線性迴歸用來做迴歸預測,邏輯迴歸用於做二分類,一個是解決迴歸問題,一個用於解決分類問題。兩者區別: 擬合函式

機器學習實踐(十四)—sklearn之嶺迴歸(線性迴歸的改進)

帶有 L2 正則化的線性迴歸就是嶺迴歸。 嶺迴歸,其實也是一種線性迴歸。 只不過在演算法建立迴歸方程時候,加上正則化的限制,從而達到解決過擬合的效果。 加上正則化,也就是使權重滿足劃分正確結果的同時儘量的小 一、嶺迴歸 - API 嶺迴歸 - API

嶺迴歸與lasso迴歸

a. 什麼是嶺迴歸和lasso迴歸?為什麼要用嶺迴歸和lasso迴歸?嶺迴歸選參的一般原則是什麼。 對OLS進行範數1正則化叫Lasso迴歸。 對OLS進行範數2正則化叫嶺迴歸。 進行嶺迴歸和Lasso迴歸的主要目的: 1.解決病態矩陣的過擬合和欠擬合問題。 2

機器學習(一)邏輯迴歸與softmax迴歸及程式碼示例

本文適合已經對機器學習、人工智慧有過一定了解,但是還沒有自己寫過程式碼,或者一直在使用現有框架的同學。不用框架自己寫一次程式碼的過程還是很有必要的,能讓你真正地理解原理與機器學習中各個步驟的實現過程,而不是停留在“好像懂了”、只會調庫的階段。 目錄

SparkML之迴歸(一)線性迴歸

----------------------------目錄----------------------------------------------------------------------- 線性迴歸理論 spark原始碼 Spark實驗 -----------

邏輯迴歸和線性迴歸區別

1)線性迴歸要求變數服從正態分佈,logistic迴歸對變數分佈沒有要求。 2)線性迴歸要求因變數是連續性數值變數,而logistic迴歸要求因變數是分型別變數。 3)線性迴歸要求自變數和因變數呈線

邏輯迴歸、線性迴歸、最小二乘、極大似然、梯度下降

轉自 http://www.zhihu.com/question/24900876 機器學習的基本框架大都是模型、目標和演算法! 重要的事情說三遍! 對於一個數據集,首先你要根據資料的特點和目的來選擇合適模型。 就你問的而言,選定的模型是Logistic Regressi