深度學習基礎 十二 ReLU vs PReLU

阿新 • • 發佈:2018-11-08

分享一下我老師大神的人工智慧教程!零基礎,通俗易懂!http://blog.csdn.net/jiangjunshow

也歡迎大家轉載本篇文章。分享知識,造福人民,實現我們中華民族偉大復興!

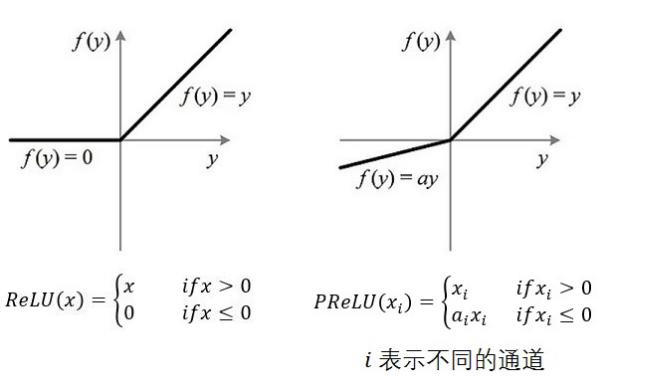

從演算法的命名上來說,PReLU 是對 ReLU 的進一步限制,事實上 PReLU(Parametric Rectified Linear Unit),也即 PReLU 是增加了引數修正的 ReLU。

在功能範疇上,ReLU 、 PReLU 和 sigmoid 、 tanh 函式一樣都是作為神經元的激勵函式(activation function)。

1. ReLU 與 PReLU

注意圖中通道的概念,不通的通道對應不同的 $$

如果 ai=0 被初始化為 0.25。

3. references

《Delving Deep into Rectifiers:Surpassing Human-Level Performance on ImageNet Classification》

給我老師的人工智慧教程打call!http://blog.csdn.net/jiangjunshow