支援向量機--support vector machine

支援向量機

支援向量機(Support Vector Machine,SVM)是Corinna Cortes等於1995年首先提出,是一種監督學習方法,核心思想是找到一個超平面對資料進行分割。用到區域性對偶理論、庫恩—塔克爾定理和核方法。

(1)區域性對偶理論(Local Duality Theorem)

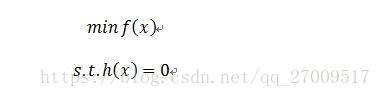

在條件為等式的情況下,最小化目標函式,問題轉化為最小化一個目標公式。公式如下:

利用拉格朗日乘子法把問題轉化為如下公式:

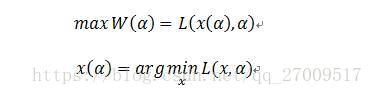

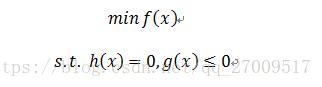

(2)庫恩—塔克爾定理(Karush-Kuhn-Tuchker Theorem,KKT)

庫恩—塔克爾定理解決的是約束條件是不等式的情況。

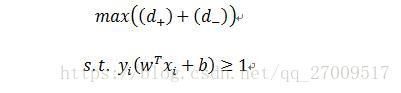

問題如下:

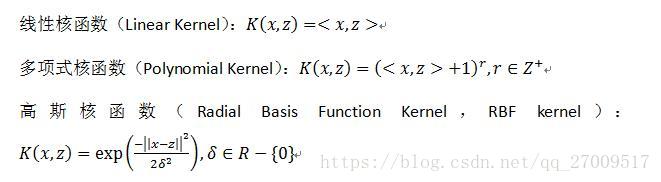

(3)核方法(kernel method)

在原始資料的空間中,原始資料不好找到超平面進行劃分,利用核函式對原始資料進行對映,到新的空間裡,新的資料是可以劃分的,這種方法稱核方法(kernel method)。

常見的和函式有如下:

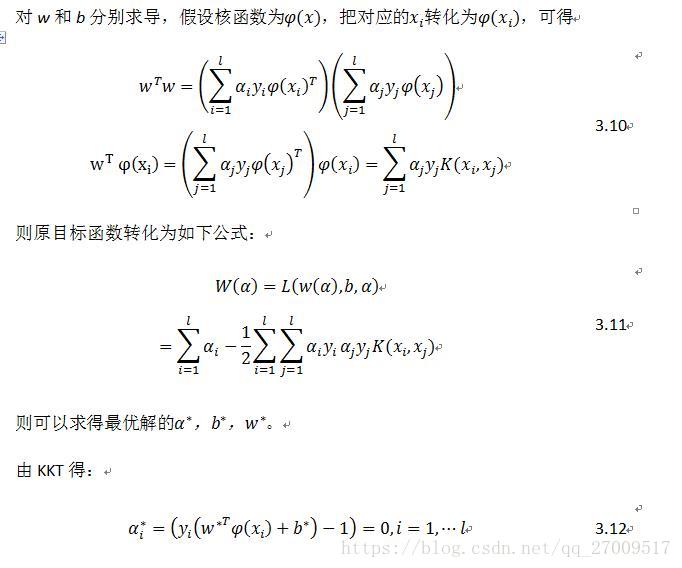

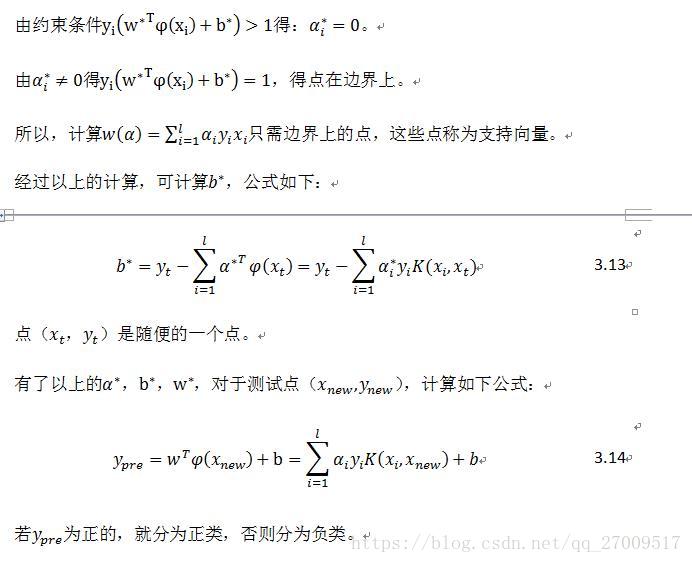

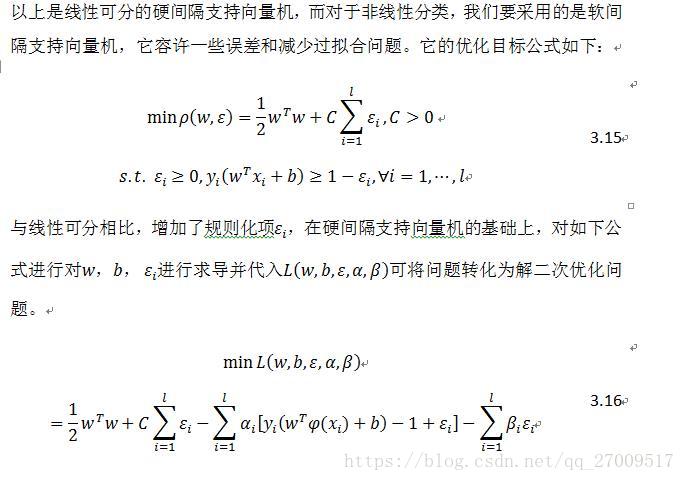

(4)支援向量機的理論

支援向量機的目的是要找到離不同資料之間的距離最大的超平面,假設是二維的情況。

目標公式如下:

相關推薦

支援向量機--support vector machine

支援向量機 支援向量機(Support Vector Machine,SVM)是Corinna Cortes等於1995年首先提出,是一種監督學習方法,核心思想是找到一個超平面對資料進行分割。用到區域性對偶理論、庫恩—塔克爾定理和核方法。 (1)區域性對偶理論(Local Duality T

Andrew Ng 機器學習筆記 11 :支援向量機(Support Vector Machine)

構建支援向量機 1.替換邏輯迴歸函式 2.去除多餘的常數項 1/m 3.正則化項係數的處理 大間距分類器 SVM決

支援向量機(Support Vector Machine, SVM)

感知演算法 線性分類器:f(x;w,b)=⟨w,x⟩+bf({\rm{x}};{\rm{w}},b)=\left \langle {\rm{w}},{\rm{x}} \right \rangle+bf(

支援向量機(support vector machine)--模型的由來

1995年,Corinna Cortes(CC老師)靚照 CC老師首先給出資料集是二分類且線性可分的情況,設是上的資料集,即,其中,是的標籤,例:二維空間中資料集視覺化的表示(青色表示

機器學習2-支援向量機(Support Vector Machine)

在機器學習中,支援向量機(SVM,還支援向量網路)是與相關的學習演算法有關的監督學習模型,可以分析資料,識別模式,用於分類和迴歸分析。 介紹 在機器學習中,支援向量機(SVM,還支援向量網路)是與相關的學習演算法有關的監督學習模型,可以分析資料,

支援向量機(Support Vector Machine)

關於支援向量機,這裡只解釋一些概念以及關於超平面引數是如何計算的,本篇不對引數優化推導過程進行詳解,這塊比較複雜,個人也需要時間捋一捋,日後再做整理。 首先,SVM的分類器為:,其中令為0時,即為該分類器的超平面,在二維中即是一條直線,如下圖所示: 1.函式間隔 函式間隔

吳恩達機器學習13--支援向量機(Support Vector Machines)

第13章 支援向量機(Support Vector Machines) 一,優化目標(Optimization objective) SVM也是廣泛的應用於工業界和學術界的監督學習演算法。 類似於logistic的代價函式,SVM的代價函式如圖是斜直線加上平直線

機器學習之支援向量機(Support Vector Machines)

支援向量機(Support Vector Machines, SVM)是一種二分類模型,其基本模型是定義在特徵空間上的間隔最大的線性分類器。支援向量機的學習策略就是間隔最大化。 間隔最大化的直觀解釋是:對訓練資料集找到幾何間隔最大的超平面意味著以充分大的卻確信度對訓練資料進

Ng第十二課:支持向量機(Support Vector Machines)(二)

.com htm 條件 hid cti 無法 技術 add 效果 7 核函數(Kernels) 考慮我們最初在“線性回歸”中提出的問題,特征是房子的面積x,這裏的x是實數,結果y是房子的價格。假設我們從樣本點的分布中看到x和y符合3次曲線,那麽我們希望使用x的三次多項式來逼

學習SVM(四) 理解SVM中的支援向量(Support Vector)

我們在開始接觸SVM時肯定聽到過類似這樣的話,決定決策邊界的資料叫做支援向量,它決定了margin到底是多少,而max margin更遠的點,其實有沒有無所謂。 然後一般會配一張圖說明一下哪些是支援向量(Support Vector),這個圖在之前的學習S

機器學習實戰(五)支援向量機SVM(Support Vector Machine)

目錄 0. 前言 1. 尋找最大間隔 2. 拉格朗日乘子法和KKT條件 3. 鬆弛變數 4. 帶鬆弛變數的拉格朗日乘子法和KKT條件 5. 序列最小優化SMO(Sequential Minimal Optimiz

支援向量機(support vector machine)(一):線性可分SVM

總結一下,不然過段時間就全忘了,加油~ 1、問題描述 假設,存在兩類資料A,B,如圖1所示,A中資料對應於圖中的實心點,B中資料對應圖中的空心點,現在我們需要得到一條直線,能夠將二者進行區分,這樣的線存在無數條,如圖1中的黑色直線所示,這些線都能夠

支援向量機(support vector machine)(二):線性SVM

通常情況下,存在以下兩種情況: 1、分類完全正確的超平面不一定是最好的; 2、樣本資料不是線性可分的; 如圖1所示,如果按照完全分對這個準則來劃分時,L1為最優分割超平面,但是實際情況如果按照L2來進行劃分,效果可能會更好,分類結果會更加魯棒。

機器學習與深度學習系列連載: 第一部分 機器學習(九)支援向量機2(Support Vector Machine)

另一種視角定義SVM:hinge Loss +kennel trick SVM 可以理解為就是hingle Loss和kernel 的組合 1. hinge Loss 還是讓我們回到二分類的問題,為了方便起見,我們y=1 看做是一類,y=-1 看做是另一類

Support Vector Machine 支援向量機散點分類

示例網址: https://scikit-learn.org/stable/auto_examples/svm/plot_separating_hyperplane.html#sphx-glr-auto-examples-svm-plot-separating-hyperplane-py 支

支援向量機的公式推導(Support Vector Machine,SVM)

轉:https://www.cnblogs.com/pursued-deer/p/7857306.html 1 認識向量機 支援向量機是處理資料分類問題,目的是學會一個二分類的函式模型,屬於監督式學習的方法,被廣泛應用於統計分類和迴歸分析。通過建立一個超平面對樣本資料進行分類,超平面涉及到凸

支援向量機(Support Vector Machine,SVM)—— 線性SVM

支援向量機(Support Vector Machine,簡稱 SVM)於 1995 年正式發表,由於其在文字分類任務中的卓越效能,很快就成為機器學習的主流技術。儘管現在 Deep Learning 很流行,SVM 仍然是一種很有的機器學習演算法,在資料集小的情況下能比 Deep Learning 取得更

機器學習之支援向量機SVM Support Vector Machine (五) scikit-learn演算法庫

一、scikit-learn SVM演算法庫概述 scikit-learn中SVM的演算法庫分為兩類,一類是分類演算法庫,包括SVC、 NuSVC和LinearSVC三個類。另一類是迴歸演算法庫,包括SVR、NuSVR和LinearSVR三個類。相關的

【機器學習實戰】第6章 支援向量機(Support Vector Machine / SVM)

第6章 支援向量機 <script type="text/javascript" src="http://cdn.mathjax.org/mathjax/latest/MathJax.js?config=default"></script>

機器學習實戰-55:支援向量機分類演算法(Support Vector Machine)

支援向量機分類演算法 支援向量機(Support Vector Machine)分類演算法屬於監督學習演算法。常用分類演算法包括:邏輯迴歸(Logistic Regression, LR)、K最近鄰(k-Nearest Neighbor, KNN)、樸素貝葉斯