25.Two-Stream Convolutional Networks for Dynamic Saliency Prediction

Two-Stream Convolutional Networks for Dynamic Saliency Prediction

用於動態顯著性預測的雙流卷積網路

摘要

近年來,影象中的視覺顯著性估計在計算機視覺領域引起了很多關注。但是,預測視訊中的顯著性卻受到的關注相對較少。受最近基於靜態顯著性模型的深度卷積神經網路成功的啟發,在這項工作中,我們研究了兩種不同的雙流卷積網路,用於動態顯著性預測。為了提高模型的泛化能力,我們還為此任務引入了一種新穎的,基於經驗的資料增強技術。我們在DIEM資料集上測試我們的模型,並針對現有模型報告優異的結果。此外,我們通過在靜態影象估計的光流上微調我們的模型,對最近提出的靜態顯著性資料集SALICON進行遷移學習實驗。我們的實驗表明,以這種方式考慮運動可以有助於靜態顯著性估計。

引言

視覺顯著性模型近年來獲得了極大的關注。這種興趣日益增長的原因在於這些模型在各種計算機視覺問題中的有效使用,例如分割,目標檢測,視訊摘要和壓縮,其中提取的顯著性圖譜被用作視覺特徵或特徵選擇機制。從廣義上講,顯著性模型可以根據它們是否試圖預測人眼固定[2]或檢測顯著物件[1]而分為兩類。根據它們處理的輸入型別,模型可以進一步分為靜態和動態顯著性模型。靜態模型將靜止影象作為輸入,而動態模型則處理視訊序列。

與在靜止影象中執行相同任務相比,預測視訊中的顯著性給研究人員帶來了巨大挑戰。首先,動態模型在計算顯著性圖譜時需要考慮場景的空間和時間特徵。 靜態顯著模型採用強度,顏色和方向等視覺特徵,對於動態顯著性,需要更多地關注運動特徵,因為人類傾向於將眼睛固定在運動中的物體上。在這方面,動態顯著性模型的早期例子擴充套件了靜態顯著性模型,因此它們考慮了額外的運動特徵[8,7,5,30]。此外,從新穎的角度來看,有限數量的動態顯著性模型接近視訊中的顯著性預測[10,23,29]。

最近有興趣將深度學習應用於靜止影象中的顯著性預測[19,25,18,32,37]。這些模型都採用深度神經網路,並在大多數基準資料集中提供最先進的結果。在本文中,我們的貢獻是三倍的。首先,受這些模型成功的啟發,我們研究了用於動態顯著性預測的卷積神經網路。我們研究了使用雙流卷積神經網路架構,該架構將空間流與時間流進行整合。這些網路模型通過以端到端方式學習的過濾器同時利用外觀和運動資訊來預測給定視訊幀的顯著性圖。特別是,我們提出了兩種考慮晚期或早期融合策略的不同模型。據我們所知,我們是第一個應用動態顯著性的雙流深度模型。其次,我們為此任務提出了一種資料增強技術,以改進卷積網路的泛化。DIEM資料集[24]的實驗驗證了我們模型的有效性和我們的資料增強策略。第三,我們證明遷移學習可以用於通過從靜止影象中提取的利用光流資訊來預測靜態顯著性[33]。SALICON資料集[13]的實驗表明,考慮運動可以提高預測精度。

相關工作

文獻中的顯著性評估模型通常被分為兩組:自下而上方法[22,26,35]和自上而下方法[16,36]。自下而上的方法通常嘗試通過使用諸如顏色,強度,方向之類的低階視覺提示來識別人類將他們的眼睛固定在影象中的顯著區域,並且他們不使用關於影象內容和上下文的任何先驗資訊。相反,自上而下的方法直接使用與上下文相關的語義提示和關於場景的內容資訊,並且通常考慮諸如在場景中尋找人的特定任務。

在這項研究中,我們感興趣的是對動態場景的視覺注意力的免任務自下而上建模。動態顯著性的早期模型擴充套件了靜態顯著性模型以包括運動特徵。例如,Cui等人[5]通過調頻模型識別視訊幀的顯著部分。特別地,它們對沿著空間和時間平面的視訊幀的傅立葉譜進行譜殘差分析,以從背景中提取運動中的前景物體。 郭等人[7]對視訊幀的相位譜進行類似的頻譜分析。Harel等人[8]提出了一種顯著性模型,其中提取的特徵圖通過全連通圖表示,最終的顯著圖通過圖論方法估計。Seo和Milanfar[30]利用時空體積的自相似性來預測顯著性。

一些研究人員設計了專為動態顯著性設計的新型模型。例如,Hou [10]提出了一種模型,該模型考慮了視覺特徵的稀有性,並通過對提取的視覺特徵執行熵最大化來提取顯著性圖。馬特等人[23]將動態顯著性預測表示為分類任務,並提出基於學習的顯著性模型來整合幾個視覺線索。在另一項研究中,Rudoy等人[29]還提出了一種基於學習的顯著性預測框架。他們的表述不同於Mathe等人的模型[23],因為他們考慮了一組稀疏的凝視位置,他們試圖在連續的視訊幀上預測條件凝視過渡。

近年來,深度神經網路已應用於許多計算機視覺問題,如影象分類[9],目標檢測[6],活動識別[38],語義分割[21]和視訊分類[15],取得了優異的結果。這些方法針對特定任務執行分層特徵學習,其通常提供比手工特徵更好的結果。在這些成功的推動下,最近還引入了許多基於深度學習的顯著性模型[19,25,18,32,37]。Vig等[32]採用深度網路集合,在預測顯著性圖時基於生物學啟發的分層特徵。Kruthiventi等[18]採用全卷積神經網路架構進行顯著性估計任務。Kmeumrer等人[19]使用通過AlexNet[17]模型的不同層次學習的深層特徵,並學習如何將它們組合用於顯著性估計。趙等人[37]通過考慮區域性和全域性影象上下文的深度學習框架進行顯著物件檢測。潘等人[25]最近提出了兩種基於卷積網路的模型,它們具有不同的層大小,通過將顯著性預測作為迴歸任務。值得注意的是,所有這些模型都被提議用於預測靜止影象而非視訊的顯著性。

在這些基於深度學習的顯著性模型的推動下,在我們的論文中,我們研究了卷積神經網路在動態顯著性估計中的應用。更具體地,我們通過連續視訊幀之間的光流提取時間資訊,並研究在顯著性預測中使用該附加資訊的不同方式。我們模擬了兩種不同的雙流卷積網路,它們通過採用早期和晚期融合策略來組合空間和時間資訊。據我們所知,我們的模型是文獻中第一個基於雙流卷積神經網路的動態顯著性模型。

模型

本研究的目的是研究動態顯著性預測的不同深層架構。最近,深度卷積網路在計算機視覺中的許多分類和迴歸任務中提供了極其優越的效能。雖然這些網路的較低層響應原始影象特徵,例如邊緣,角落和共享的共同圖案,但較高層提取諸如物件部分或面部之類的語義資訊。如前所述,這些低階和高階特徵在估計視覺顯著性方面顯示出重要和互補性。為此,我們研究了圖1(a)和1(b)(空間和時間)中的兩個基線單幀網路和兩個通過實現兩個不同粒度級別的空間和時間線索組合的雙流網路[31]。不同的融合策略:晚期融合和早期融合,如圖2(a)和2(b)所示。我們在下面詳細描述這些模型。

空間流網。對於基本的單幀基線模型,我們使用[25]中最近提出的靜態顯著性模型。如圖1(a)所示,這個卷積網路類似於VGG-M模型[4]-主要區別在於最後一層是反捲積(分步跨度卷積)層,以上取樣到原始影象大小。請注意,它不使用任何時態資訊,僅利用外觀資訊來預測靜止視訊幀中的顯著性。

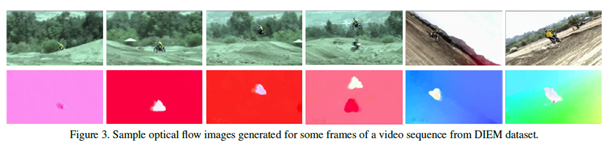

時間流網。使視訊中的顯著性預測與影象本質上不同的原因是我們的注意力受到前景物體的區域性運動對比度的極大影響。為了理解時間資訊對顯著性預測的貢獻,我們自己開發了第二個單幀基線。如圖1(b)所示,該模型只是空間流網路的複製品,但輸入是以光流影象的形式提供的,如[31]所示,由兩個後續幀計算得出。一些樣本光流影象如圖3所示。

後期融合網路。後期融合模型如圖2(a)所示。它將視訊幀和相應的光流影象作為輸入,並通過最新卷積層的元素融合將空間和時間單幀網絡合並在一起。從這個意義上說,它直接結合了最高層的空間和時間資訊。在該融合步驟之後,它還使用反捲積層來產生上取樣顯著圖作為最終結果。

早期融合網。早期融合模型在早期階段整合空間和時間流,具體通過在單幀模型卷積融合的第四卷積層之後應用卷積融合。也就是說,來自單幀模型的相應特徵圖被堆疊在一起,並且它們與一組11個卷積相結合。如圖2(b)所示,接下來是許多卷積和最終的反捲積層,以產生顯著圖。

3.1實施細節

網路架構。對於單幀模型,我們採用[25]中提出的深度卷積網路,其輸入大小為640×480×3畫素,可以概括為C(96,7,3)→ LRN → P → C(256,5, 2) → P,C(512,3,1)→ C(512,5,2)→ C(512,5,2)→ C(256,7,3)→ C(128, 11,5)→ C(32,11,5)→ C(1,13,6)→ D,其中C(d,f,p)表示卷積層,其中d濾波器的大小為f*f,用填充p和步長為1施加到輸入端。 LRN表示執行一種橫向抑制的區域性響應歸一化層,P表示具有步長為2的3*3個區域上的最大池化層。最後,D是具有尺寸8*8*1的濾波器的反捲積層,其具有步長為4和填充2它將最終的卷積結果升級到原始大小。除最後一個之外的所有卷積層之後是ReLU層。空間和時間流模型的輸入不同,即,當接受靜止影象時,另一個接受光流影象。

所提出的雙流模型採用不同的融合策略將不同階段的空間和時間卷積網路融合在一起,如圖2所示。在後期融合模型中,顧名思義,單流流網路在最後一個之後組合卷積層C(1,13,6)通過應用逐元素最大化操作,其後是單幀模型中的相同反捲積層D.另一方面,早期融合模型在第四卷積層C(512,5,2)之後執行卷積融合。也就是說,所得到的特徵圖被堆疊在一起並由卷積層C(512,1,0)進行積分,卷積層C的權重用單位矩陣初始化。其餘層與單幀模型的層相同。

預處理。在我們的實驗中,我們使用DIEM(動態影象和眼動)資料集[24],這將在實驗部分中詳細描述。由於我們的網路接受大小為640*480*3畫素的輸入並輸出相同大小的顯著圖,因此所有視訊和標籤固定密度圖在訓練之前都會重新調整為此大小。我們使用DeepFlow [34]的公開實現,並且我們另外從後續視訊幀的重新縮放版本中提取光流資訊。然後通過將水平和垂直流動分量以及流的大小堆疊在一起來生成光流影象。一些示例光流影象如圖3所示。

資料擴充。資料增強是一種廣泛使用的方法,用於減少過擬合的影響並改善神經網路的泛化。然而,對於顯著性預測,諸如裁剪,水平翻轉或RGB抖動之類的經典技術不是非常合適,因為它們改變了用於收集資料的眼睛跟蹤實驗中使用的設定。[14]中的實驗表明,人們對相同影象的高解析度和低解析度版本的外觀非常一致。因此,我們處理所有視訊序列並通過將它們下采樣2倍和4倍來產生它們的低解析度版本。我們注意到,在降低光流影象的解析度時,還應重新調整幅度以匹配下采樣率。

訓練。我們使用[25]中預訓練模型的權重來設定空間和時間流網路的初始權重。在優化模型時,我們使用Caffe框架[12]並使用隨機梯度下降與預測顯著性圖和標籤之間的歐幾里德距離。網路訓練超過200K次迭代,我們使用批量大小為2的影象,動量為0.9,重量衰減為0.0005,每10K次迭代減少0.1倍。

實驗結果

接下來,我們首先在DIEM資料集[24]的動態顯著性模型的基礎上,對提出的網路架構進行了實驗評估。然後,我們在SALICON[13]資料集上描述了我們的遷移學習實驗,在實驗中我們證明了靜態顯著性估計也可以從使用運動資訊中獲益。

DIEM實驗

我們通過實驗驗證了所提出的深層動態顯著網路對DIEM資料集的有效性[24]。該資料集由84個高清自然視訊組成,包括電影預告片,廣告等。每個視訊序列具有從大約50個不同的人類主體收集的眼睛固定資料。在我們的評估中,我們通過考慮Borji[3]等人報告的相同實驗設定來評估我們提出的所有深度動態顯著性網路(空間流網路,時間流網路,晚期融合網路,早期融合網路)。具體來說,我們用64個視訊序列訓練這些網路中的每一個,並在剩餘的20個代表性視訊上測試它們。

在圖4中,我們提供了一個樣本視訊幀上提出的網路的樣本定性結果以及標籤人類固定圖。結果清楚地證明了運動在動態顯著性估計中的重要性。空間流網路確實使用外觀資訊而不是運動,提供了不準確的顯著性圖並且錯過了運動中的前景物件。時間流網路提供了更好的結果,但確實將所有移動區域識別為顯著。後期融合網路可以獲得更準確的結果,因為它將外觀特徵與最終預測層中的運動特徵相結合。早期融合網路在早期層中結合了空間和時間資訊,因此可以獲得最佳結果,從而可以學習在更高層中處理組合外觀和運動資訊的過濾器。補充材料中也提供了樣品結果。

我們通過使用shuffled AUC度量[27]和χ2距離來定量評估所提出的網路模型。曲線下面積(AUC)度量將顯著圖視為分類圖,並使用接收器操作員特徵曲線來估計預測顯著性圖在捕獲標籤眼睛注視中的有效性。特別是,我們採用了shuffled版本的AUC(sAUC),它考慮了顯著性資料集中觀察到的中心偏差。另一方面,χ2距離將顯著圖視為概率分佈圖,並相應地將預測圖與標籤人類注視圖進行比較。完美的預測模型需要為sAUC度量給出1分,並且需要為χ2距離提供接近0的距離。對於每個測試序列,我們計算sAUC分數和每幀的χ2距離並將它們平均。表1列出了提出的動態顯著性網路的定量結果。從表中可以看出,空間流網路在兩個指標方面都提供了最差的結果。早期的融合網路通常比其他所有網路架構都能提供更好的結果。可以認為,這種成功背後的原因在於早期整合了早期層中的外觀和運動特徵,這允許層次結構的更高層次中的過濾器為顯著性預測任務學習更有效的特徵。當我們採用我們在上一節中討論過的資料增強策略時,它進一步提升了分數。我們還將早期融合網模型與文獻中的四種不同方法進行了比較。這些是GVBS [8],PQFT [7],Hou和Zhang的[10]以及Rudoy等人的[29]動態顯著性模型,它們是DIEM資料集中表現最佳的模型。雖然圖5顯示了一些樣本視訊幀的定性結果,但表2提供了定量評估結果。從這些結果可以看出,所提出的具有早期融合策略的雙流卷積網路模型在sAUC分數和χ2度量方面優於所有現有模型。

4.2在SALICON上遷移學習實驗

在瞬間捕獲靜止影象,但該單個影象幀具有足夠的資訊,其允許預測成像的場景的固有運動。受到這種觀察的啟發,沃爾克等人[33]提出了一種適用於靜態影象的深度光流預測模型。對於最後一組實驗,我們使用此預測模型來估計輸入影象的相關運動圖,並將其與原始影象一起用作我們的雙流Early Fusion網路模型的輸入。在圖6中,我們提供了一個樣本影象,其中包含一個男人在房子前面。這是一張靜止影象,但我們可以清楚地瞭解這個男人正在扔飛盤的情景。如圖所示,光流模型正確地提取飛盤作為場景中的移動物體。這使得我們的動態顯著性網路能夠更好地理解影象並提供更準確的顯著性圖,而深度卷積模型僅使用外觀資訊。

我們對最近提出的SALICON資料集進行了實驗[13]。這個大型資料集包含20000個自然影象,所有這些影象都來自MSCOCO資料集[20],並通過滑鼠游標跟蹤收集固定資料。為了評估,將資料集分成10000個訓練,5000個驗證和5000個測試影象。固定資料僅適用於訓練和驗證分割,測試由評估伺服器在外部執行。對於實驗,我們使用[33]對訓練影象和從這些靜態影象中提取的光流影象微調我們的早期融合模型。在圖7中,我們提供了由早期融合網路生成的一些示例顯著圖。我們還在表3中提供了一些定量結果,我們將結果與一些最先進的靜態顯著性模型進行比較。對於此評估,我們使用AUC,sAUC和交叉關聯(CC)指標。如表中所示,我們提出的早期融合網路模型在現有模型中提供了最佳sAUC評分,並且與深度卷積網路相比,其餘指標的結果具有極高的競爭力[25]。雖然運動可能不是SALICON資料集中所有影象的主要因素,但我們的結果表明從靜止影象預測的運動資訊可能是有用的。

結論

我們為視訊中的顯著性預測提出了兩種新穎的架構。我們的模型基於雙流卷積網路,在大型和多樣化的資料集上以端到端的方式進行訓練,它們提供了結合空間和時間資訊的有效方法。我們還提出了一種有根據的,有效的資料增強方法,該方法採用低解析度版本的視訊幀和標籤顯著圖。我們證明我們的模型在數量上優於DIEM資料集的最新技術。此外,通過利用靜態影象中的自動預測光流,我們可以通過運動資訊從運動資訊中獲取資訊,我們可以在SALICON資料集上模擬我們的模型。