經典深度學習CNN- LeNet、AlexNet、GoogLeNet、VGG、ResNet

參考了:

https://www.cnblogs.com/52machinelearning/p/5821591.html

https://blog.csdn.net/qq_24695385/article/details/80368618

LeNet

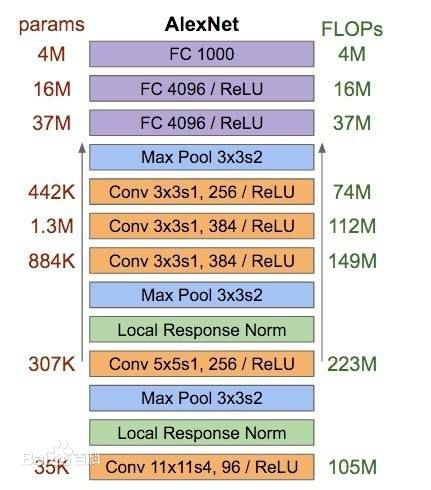

AlexNet

參考:https://baike.baidu.com/item/AlexNet/22689612?fr=aladdin

GoogLeNet

VGG

ResNet

相關推薦

經典深度學習CNN- LeNet、AlexNet、GoogLeNet、VGG、ResNet

參考了: https://www.cnblogs.com/52machinelearning/p/5821591.html https://blog.csdn.net/qq_24695385/article/details/80368618 LeNet

深度學習方法(五):卷積神經網路CNN經典模型整理Lenet,Alexnet,Googlenet,VGG,Deep Residual Learning

歡迎轉載,轉載請註明:本文出自Bin的專欄blog.csdn.net/xbinworld。 技術交流QQ群:433250724,歡迎對演算法、技術感興趣的同學加入。 關於卷積神經網路CNN,網路和文獻中有非常多的資料,我在工作/研究中也用了好一段時間各種常見的model了,就想著

詳解CNN五大經典模型:Lenet,Alexnet,Googlenet,VGG,DRL

關於卷積神經網路CNN,網路和文獻中有非常多的資料,我在工作/研究中也用了好一段時間各種常見的model了,就想著簡單整理一下,以備查閱之需。Lenet,1986年Alexnet,2012年GoogleNet,2014年VGG,2014年Deep Residual Learn

keras實現常用深度學習模型LeNet,AlexNet,ZFNet,VGGNet,GoogleNet,Resnet

LeNet #coding=utf-8 from keras.models import Sequential from keras.layers import Dense,Flatten from keras.layers.con

深度學習 --- CNN的變體在影象分類、影象檢測、目標跟蹤、語義分割和例項分割的簡介(附論文連結)

以上就是卷積神經網路的最基礎的知識了,下面我們一起來看看CNN都是用在何處並且如何使用,以及使用原理,本人還沒深入研究他們,等把基礎知識總結完以後開始深入研究這幾個方面,然後整理在寫成部落格,最近的安排是後面把自然語言處理總結一下,強化學習的總結就先往後推一下。再往後是系統的學習一下演算法和資料

吳恩達-深度學習-課程筆記-8: 超參數調試、Batch正則化和softmax( Week 3 )

erp 搜索 給定 via 深度 mode any .com sim 1 調試處理( tuning process ) 如下圖所示,ng認為學習速率α是需要調試的最重要的超參數。 其次重要的是momentum算法的β參數(一般設為0.9),隱藏單元數和mini-batch的

深度學習——優化器演算法Optimizer詳解(BGD、SGD、MBGD、Momentum、NAG、Adagrad、Adadelta、RMSprop、Adam)

在機器學習、深度學習中使用的優化演算法除了常見的梯度下降,還有 Adadelta,Adagrad,RMSProp 等幾種優化器,都是什麼呢,又該怎麼選擇呢? 在 Sebastian Ruder 的這篇論文中給出了常用優化器的比較,今天來學習一下:https://arxiv.org/pdf/160

Git 深度學習填坑之旅三(分支branch、遠程操作)

操作 完成後 啟用 remove branch word mil soft 文件的 0x01 分支branch依舊借用大表哥(@表元素)的圖很多時候,我們需要建立另一條分支來進行項目的獨立開發,當完成後再跟主流回合進行合並這個時候就要啟用分支branch功能 git b

深度學習入門專案完整流程——圖片製作資料集、訓練網路、測試準確率(TensorFlow+keras)

首先將訓練的圖片和標籤製作成資料集,我用的是numpy庫裡的savez函式,可以將numpy陣列儲存為.npz檔案(無壓縮,所以檔案較大)。 import cv2 as cv import numpy as np import os import glob #調整影象的大小、製作資

深度學習基礎--loss與啟用函式--合頁損失函式、摺頁損失函式;Hinge Loss;Multiclass SVM Loss

合頁損失函式、摺頁損失函式;Hinge Loss;Multiclass SVM Loss Hinge Loss是一種目標函式(或者說損失函式)的名稱,有的時候又叫做max-margin objective。用於分類模型以尋找距離每個樣本的距離最大的決策邊界,即最大化樣本和邊界之間的邊

深度學習RNN實現股票預測實戰(附資料、程式碼)

背景知識最近再看一些量化交易相關的材料,偶然在網上看到了一個關於用RNN實現股票預測的文章,出於好奇心把文章中介紹的程式碼在本地跑了一遍,發現可以work。於是就花了兩個晚上的時間學習了下程式碼,順便把

深度學習——CNN經典網路總結

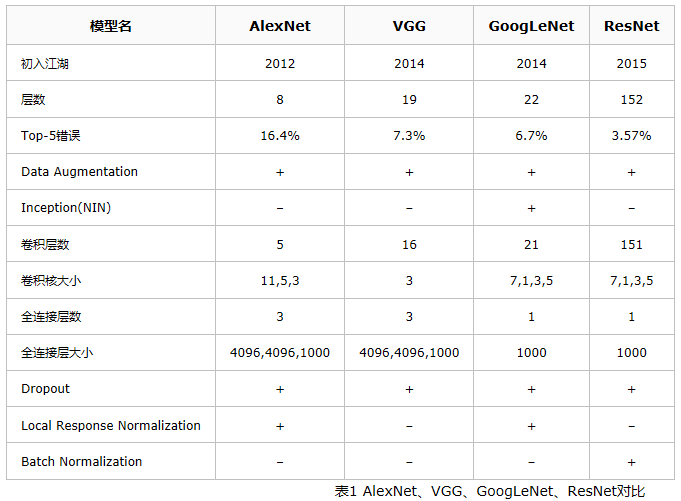

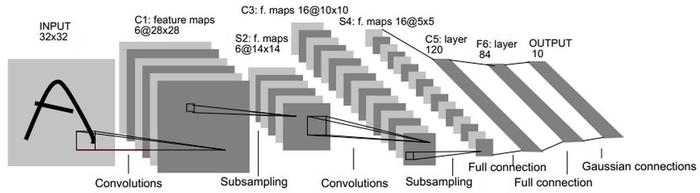

在CNN網路結構的進化過程中,出現過許多優秀的CNN網路,如:LeNet,AlexNet,VGG-Net,GoogLeNet,ResNet,他們對CNN的發展進化起著至關重要的作用。 LeNet:

深度學習框架keras平臺搭建(關鍵字:windows、非GPU、離線安裝)

當下,人工智慧越來越受到人們的關注,而這很大程度上都歸功於深度學習的迅猛發展。人工智慧和不同產業之間的成功跨界對傳統產業產生著深刻的影響。 最近,我也開始不斷接觸深度學習,之前也看了很多文章介紹,對深度學習的歷史發展以及相關理論知識也有大致瞭解。 但常言道:紙上得來終覺淺,

深度學習 CNN卷積神經網路 LeNet-5詳解

卷積神經網路( Convolutional Neural Network, CNN): 是一種常見的深度學習架構,受生物自然視覺認知機制(動物視覺皮層細胞負責檢測光學訊號)啟發而來,是一種特殊的多層前饋神經網路。它的人工神經元可以響應一部分覆蓋範圍

一文看懂深度學習新王者「AutoML」:是什麼、怎麼用、未來如何發展?

原作:George Seif夏乙 安妮 編譯整理量子位 出品 | 公眾號 QbitAIAutoM

【深度學習理論】正則化方法:L1、L2、資料擴增、Dropout

正則化 在訓練資料不夠多時,或者過度訓練時,常常會導致overfitting(過擬合)。隨著訓練過程的進行,模型複雜度增加,在train data上的error漸漸減小,但是在驗證集上的err

深度學習 --- CNN

一、卷積神經網路概述 卷積神經網路專門用於處理具有類似網格結構的神經網路,比如說時間序列資料(可認為是在時間軸上有規律地取樣形成的一維網格,舉個例子就是醫學上的心電圖,就是1D影象),然後就是影象資料(二維網格,就是2D影象) 但是,同樣也可以使用一般的神經網路做這方面,可以將每個畫素點當成

深度學習CNN演算法原理

深度學習CNN演算法原理 一 卷積神經網路 卷積神經網路(CNN)是一種前饋神經網路,通常包含資料輸入層、卷積計算層、ReLU啟用層、池化層、全連線層(INPUT-CONV-RELU-POOL-FC),是由卷積運算來代替傳統矩陣乘法運算的神經網路。CNN常用於影象的資料處理,常用的LenNe

深度學習 CNN FCN segnet簡單比較

CNN:影象級 將特徵圖對映成一個固定長度的特徵向量。 多層結構自動學習,淺層感知域小,只能學習區域性,較深卷積層有較大感知,能學習抽象 抽象特徵對大小,方向,位置等敏感度低 FCN:畫素級 可接受任意尺度的輸入,用反捲積對最後一個卷

基於FPGA的深度學習CNN加速器設計

英文原文:http://cadlab.cs.ucla.edu/~cong/slides/fpga2015_chen.pdf?spm=a2c4e.11153940.blogcont5752.3.654031b6l0wvY2&file=fpga2015_chen.pdfh