BP單隱藏層神經網路中隱藏層節點個數的取值

BP神經網路中隱藏層節點個數的取值有下面幾種方法:

第一種方法:

一個經驗公式:

其中 為隱藏層節點數目,

為隱藏層節點數目, 為輸入層節點數目,

為輸入層節點數目, 為輸出層節點數目,

為輸出層節點數目, 為

為 之間的調節常數。

之間的調節常數。

第二種方法:

Kolmogorov定理確定隱藏層節點數:

柯爾莫哥洛夫(Kolmogorov)定理:

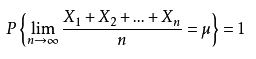

設![]() 為一相互獨立的隨機變數序列,若

為一相互獨立的隨機變數序列,若![]() 滿足不等式

滿足不等式

則服從強大數定律。

強大數定律可以表達為下式:

Kolmogorov定理說明給定任意連續對映F:[0,1] (n) →Rm可以精確地由一個三層前饋神經網路實現,第一層有n個神經元,第二層有2m+1個神經元,第三層有m個神經元。

Kolmogorov定理表明,隱層結點數為:

s=2n+1

其中n為輸入層結點數。

第三種方法:

論文:高大啟:有教師的線性基本函式前向三層神經網路結構研究

中指出的經驗公式:

![]()

其中m為輸入層節點數,n為輸出層節點數。

相關推薦

BP單隱藏層神經網路中隱藏層節點個數的取值

BP神經網路中隱藏層節點個數的取值有下面幾種方法: 第一種方法: 一個經驗公式: 其中為隱藏層節點數目,為輸入層節點數目,為輸出層節點數目,為之間的調節常數。 第二種方法: Kolmogorov定理確定隱藏層節點數: 柯爾莫哥洛夫(Kolmogorov)定理:

關於神經網路中隱藏層和神經元的深入理解

最近複習了一下基礎知識,看到MLP的結構,關於隱藏層和神經元有了新的一些理解。 隱藏層的意義 要說明隱藏層的意義,需要從兩個方面理解,一個是單個隱藏層的意義,一個是多層隱藏層的意義。 單個隱藏層的意義 隱藏層的意義就是把輸入資料的特徵,抽象到另一個維度空間,來

神經網路中隱層數和隱層節點數問題的討論

神經網路中隱層數和隱層節點數問題的討論 一 隱層數 一般認為,增加隱層數可以降低網路誤差(也有文獻認為不一定能有效降低),提高精度,但也使網路複雜化,從而增加了網路的訓練時間和出現“過擬合”的傾向。一般來講應設

神經網路中embedding層作用——本質就是word2vec,資料降維,同時可以很方便計算同義詞(各個word之間的距離),底層實現是2-gram(詞頻)+神經網路

Embedding tflearn.layers.embedding_ops.embedding (incoming, input_dim, output_dim, validate_indices=False, weights_init='truncated_norm

在tensorflow下構建二層神經網路和三層神經網路解決10分類任務對比

繼剛才的邏輯迴歸解決的十分類任務意猶未盡,分別設計了二層和三層的神經網路對比解決這個10分類問題下面畫一個草圖代表三層神經網路的計算圖:import numpy as np import tensorflow as tf import matplotlib.pyplot as

獨家 | 初學者的問題:在神經網路中應使用多少隱藏層/神經元?(附例項)

作者:Ahmed Gad翻譯:蔣雨暢校對:李海明本文約2400字,建議閱讀8分鐘。本文將通過兩個

單隱藏層神經網路 實現邏輯閘

開發十年,就只剩下這套架構體系了! >>>

神經網路中反向傳播演算法(BP)

神經網路中反向傳播演算法(BP) 本文只是對BP演算法中的一些內容進行一些解釋,所以並不是嚴格的推導,因為我在推導的過程中遇見很多東西,當時不知道為什麼要這樣,所以本文只是對BP演算法中一些東西做點自己的合理性解釋,也便於自己理解。 要想看懂本文,要懂什麼是神經網路,對前向傳播以

系列之5-多入單出的一層神經網路能做什麼

全套教程請點選:微軟 AI 開發教程 知識點 多元線性迴歸 輸入層的矩陣運算設計 樣本資料歸一化 提出問題 假設有如下這樣一個問題:有1000個樣本,每個樣本有三個特徵值,一個標籤值。想讓你預測一下給定任意三個特徵值組合,其y值是多少? 樣本序號 1

8、外觀模式—MVC三層結構開發中隱藏的模式

外觀模式(Facade):為子系統中的一組介面提供y一個一致的介面,此模式定義了一個高層介面,這個介面使得這一子系統更加容易sh使用UML圖:package com.thpin.repository.designpattern; public class FacadeDem

對於卷積神經網路中全連線層的理解

全連線層的推導全連線層的每一個結點都與上一層的所有結點相連,用來把前邊提取到的特徵綜合起來。由於其全相連的特性,一般全連線層的引數也是最多的。全連線層的前向計算下圖中連線最密集的2個地方就是全連線層,這很明顯的可以看出全連線層的引數的確很多。在前向計算過程,也就是一個線性的加

Caffe下卷積神經網路中的一些特殊層

Caffe下卷積神經網路(CNN)中的一些特殊層 作者:xg123321123 宣告:版權所有,轉載請聯絡作者並註明出處 Batch Normalization 意義: 網路訓練時,用來加

神經網路中BP演算法的原理與用Python實現原始碼

(1)什麼是梯度下降和鏈式求導法則 1.梯度下降 假設我們有一個函式J(w),如下圖所示。 現在,我們要求當w等於什麼的時候,J(w)能夠取到最小值。從圖中我們知道最小值在初始位置的左邊,也就意味著如果想要使J(w)最小,w的值需要減小。而初始位置的切線斜率a>0

79、tensorflow計算一個五層神經網路的正則化損失係數、防止網路過擬合、正則化的思想就是在損失函式中加入刻畫模型複雜程度的指標

''' Created on Apr 20, 2017 @author: P0079482 ''' import tensorflow as tf #獲取一層神經網路邊上的權重,並將這個權重的L2正

BP神經網路的隱含層,輸入層,輸出層的節點數確定

1.輸入向量維數=輸入層節點數 2.隱含層節點數計算 一般情況下隱含層轉移函式用logsig或tansig 確定隱含層節點數應該滿足以下條件: 隱含層節點數必須小於N-1(N是訓練樣本數),否則網路模型的系統誤差與訓練樣本的特性無關而趨於0,即建立的網路模型沒有泛

神經網路中卷積層的堆疊

在神經網路的設計中,經常會出現多個卷積層堆疊的情況,(例如VGGNet)通過VGG16/19的結構圖可以看出,每一段使用了很多卷積層堆疊,然後再經過池化層,這其實是非常有用的設計。如下圖所示:兩個3x3

兩層單入單出的神經網路能做什麼

定義神經網路結構 我們定義一個兩層的神經網路,輸入層不算,一個隱藏層,含128個神經元,一個輸出層。 數學理論證明:具有足夠數量神經元的兩層神經網路能夠擬合任意精度的連續函式。所以,今天咱們就用實際資料來驗證一下這個理論。我們假設一個連續函式的形式為: \[y=0.4x^2 + 0.3xsin(15x) +

神經網路中的BP演算法(原理和推導)

BP演算法介紹 BP演算法(Background Propagation Alogorithm), 即誤差逆傳播演算法,是訓練多層前饋神經網路的一種最經典的演算法,通過BP演算法可以學得網路的權重和閾值,且具有可靠的收斂性。 網路結構 首先對所用的符號和變

搭建簡單的三層神經網路

# -*- coding: utf-8 -*- import numpy as np #損失函式 def sigmoid(x,deriv = False): if (deriv == True): return x * (1-x) return 1/(1 + np

傳統神經網路中常用的regularization方法

1、basic choice (1)通過一定的方式來縮小權重 (2)通過一定的方式將部分權重置為0 (3)weight-elimination regulizer 2、Early Stoppping Early stopping方法可以控制VC dimension