Hadoop的安裝總結

阿新 • • 發佈:2018-12-26

1硬體需求

記憶體容量:4G以上

硬碟容量:500G以上

CPU :4核以上

2 軟體需求

作業系統

方案一:作業系統:Linux,建議ubuntu 16.04

方案二: 作業系統:Windows64位,建議windows7 64位

虛擬機器:建議VMware Workstation Pro

其他軟體: JAVA:jdk1.7以上,建議1.8版本

Eclipse

Hadoop:建議2.7.4

Hbase:建議1.3版本

3 軟體安裝

將JAVA、Eclipse、Hadoop、(Hbase可以後期安裝)的解壓版copy到目錄

/home/hadoop/apps

並分別建目錄:

/home/hadoop/apps/jdk

/home/hadoop/apps/ Eclipse

/home/hadoop/apps/ Hadoop

/home/hadoop/apps/Hbase

4 作業系統ubuntu 16.04環境變數設定

開啟命令列視窗terminal:

快捷鍵:

Ctrl+Alt+T

編輯使用者啟動所需檔案bashrc

命令

$ gedit ~/.bashrc

內容如下:

export JAVA_HOME=/home/hadoop/apps/jdk export JRE_HOME=${JAVA_HOME}/jre export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib export PATH=$JAVA_HOME/bin:$PATH export HADOOP_HOME=/home/hadoop/apps/hadoop export PATH=$HADOOP_HOME/bin:$PATH

執行使用者啟動所需檔案bashrc

命令

$source ~/.bashrc

檢視

$java –version $hadoop version

5 編輯Hadoop啟動所需檔案core-site.xml

core-site.xml位置:

home/apps/hadoop/etc/hadoopcore-site.xml增加內容:

<configuration> <property> <name>hadoop.tmp.dir</name> <value>file:/home/hadoop/apps/hadoop/tmp </value> <description> Abase for other temporary directories. </description> </property> <property> <name>fs.defaultFS</name> <value>hdfs://localhost:9000</value> </property> </configuration>

6 編輯Hadoop啟動所需檔案hdfs-site.xml

hdfs-site.xml位置:home/apps/hadoop/etc/hadoophdfs-site.xml

增加內容:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/home/hadoop/apps/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/home/hadoop/apps/hadoop/tmp/dfs/data</value>

</property>

</configuration>

7 SSH的安裝與配置

關閉防火牆

處理可能出現的異常ssh:connect to host localhost port 22:Connection refused

$sudo ufw disable

安裝 openssh-server

$sudo apt-get update

$sudo apt-get install openssh-server

$SSH IP

配置SSH無密碼登入

$ssh-keygen -t rsa -P ''

$cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

$ssh localhost

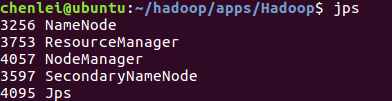

8 啟動Hadoop

格式化namenode

$bin/hadoop namenode -format

啟動Hadoop節點

啟動 $sbin/start-all.sh

顯示 $jps

出現如圖所示內容,則說明安裝成功!!!