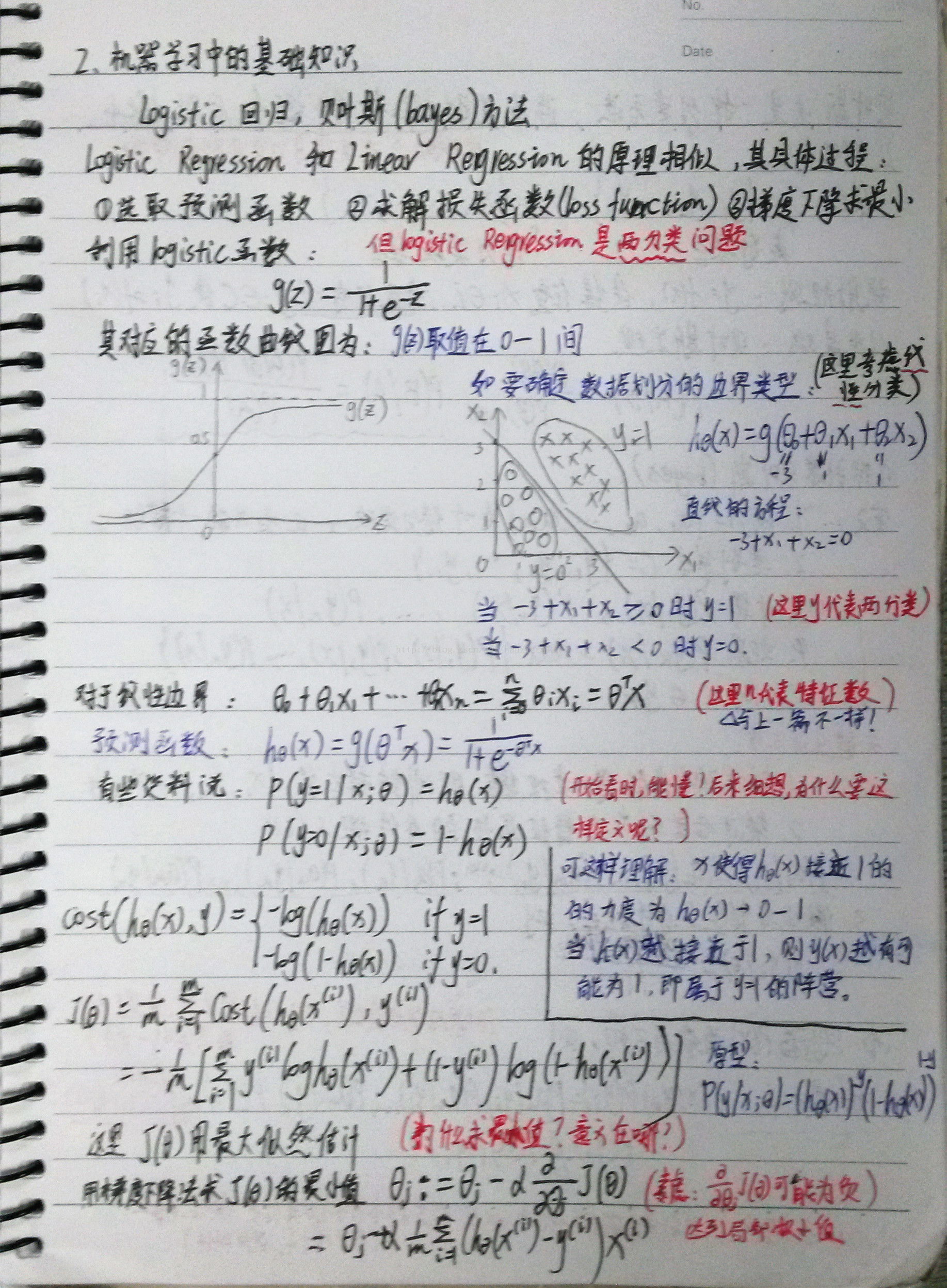

機器學習系列(2):logistic迴歸,貝葉斯(bayes)方法

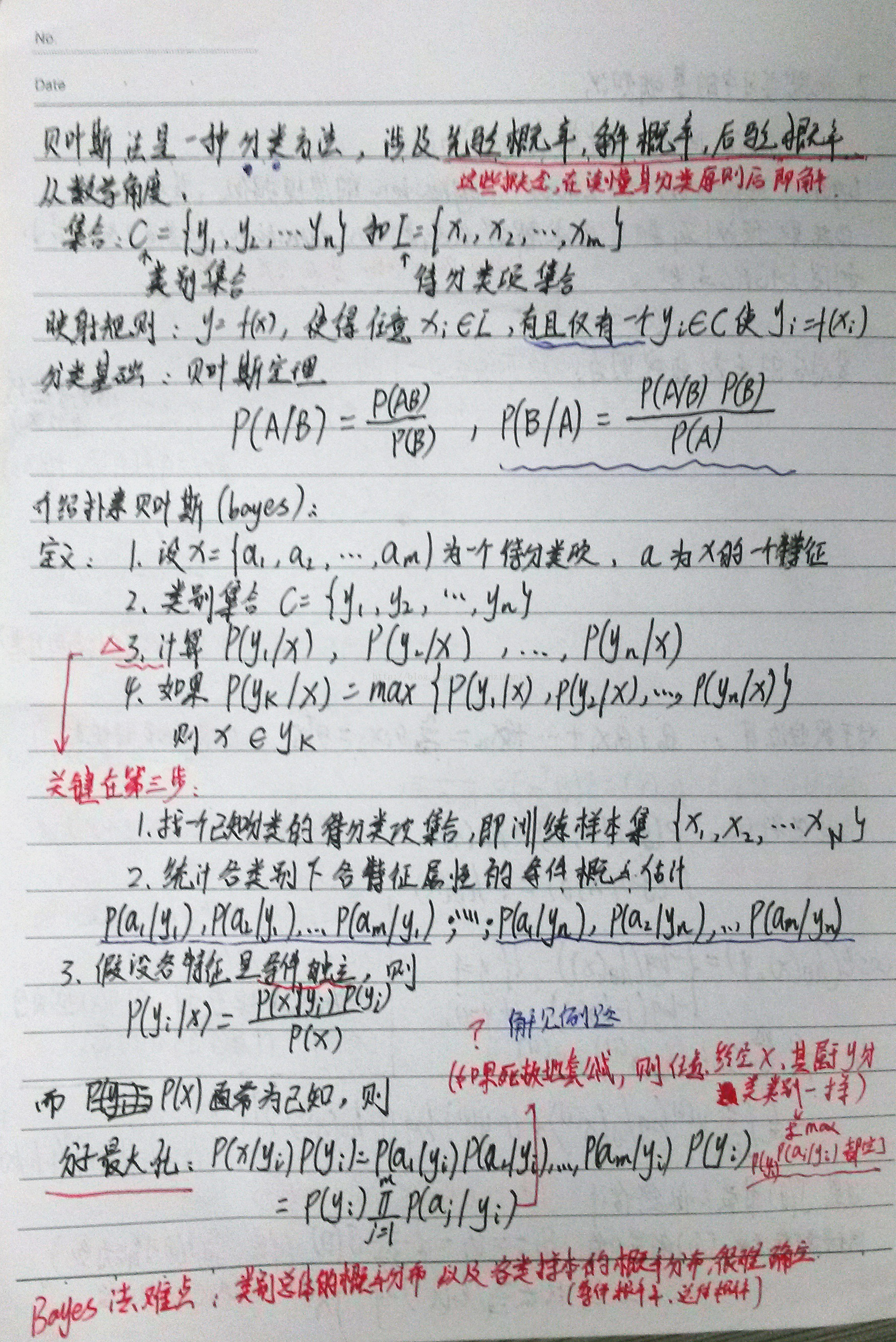

前言:這章主要介紹logistic迴歸和bayes法。兩者都屬分類,前者引入了logistic函式,後者引入了貝葉斯定理,都是比較基礎的數學知識。

但是logistic無需先驗的訓練樣本,後者需要。

貝葉斯法很強大,很多郵件、網頁篩選都有用到,這裡只介紹樸素bayes法。理解其關鍵在於應用中條件概率的提取。

引用《機器學習》上的一句話:

“在特定前提下,任一學習演算法如果使輸出的假設預測和訓練資料之間的誤差平方最小化,它將輸出一極大似然假設。”

正文:

後續:對於logistic迴歸,最後梯度下降法計算最小J(x)詳細解法可見參考資料1

Logistic迴歸就是要學習得到![]() ,使得正例的特徵遠大於0,負例的特徵遠小於0,強調在全部訓練例項上達到這個目標

,使得正例的特徵遠大於0,負例的特徵遠小於0,強調在全部訓練例項上達到這個目標

對於bayes法,例題見參考資料2.

相關推薦

機器學習系列(2):logistic迴歸,貝葉斯(bayes)方法

前言:這章主要介紹logistic迴歸和bayes法。兩者都屬分類,前者引入了logistic函式,後者引入了貝葉斯定理,都是比較基礎的數學知識。 但是logistic無需先驗的訓練樣本,後者需要。 貝葉斯法很強大,很多郵件

【黎明傳數==>機器學習速成寶典】模型篇05——樸素貝葉斯【Naive Bayes】(附python代碼)

pytho res tex 機器學習 樸素貝葉斯 spa 什麽 之一 類別 目錄 先驗概率與後驗概率 什麽是樸素貝葉斯 模型的三個基本要素 構造kd樹 kd樹的最近鄰搜索 kd樹的k近鄰搜索 Python代碼(sklearn庫) 先

機器學習實戰—第5章:Logistic迴歸中程式清單5-1中的數學推導

如圖中梯度上升法給出的函式程式碼。 假設函式為: 1、梯度上升演算法(引數極大似然估計值): 通過檢視《統計學習方法》中的模型引數估計,分類結果為類別0和類別1的概率分別為: 則似然函式為: 對數似然函式為: 最大似然估計求使得對數似然函式取最大值時的引數

機器學習筆記《四》:線性迴歸,邏輯迴歸案例與重點細節問題分析

import numpy as np import pandas as pd import matplotlib.pyplot as plt import os path = "data"+os.sep+"creditcard.csv"; pdData =

kaggle 影評情感分析(1)—— TF-IDF+Logistic迴歸/樸素貝葉斯/SGD

前言 kaggle的這個starting competition (Bag of words meet bags of popcorns) 其實是一個word2vec-tutorial, 但是本篇文章沒有用到 word2vec, 只用了 TF-IDF 的方式將句

機器學習:貝葉斯總結_3:線性迴歸和貝葉斯迴歸

線性迴歸的基函式模型 y(x,w)=w0+w1x1+......+wDxD y(x,w)=w0+∑M−1j=1wjϕj(x) ϕj(x):是基函數 基函式:多項式;高斯;sigmoid函式 基函

【機器學習】先驗概率、後驗概率、貝葉斯公式、 似然函式

Original url: http://m.blog.csdn.net/article/details?id=49130173 一、先驗概率、後驗概率、貝葉斯公式、 似然函式 在機器學習中,這些概念總會涉及到,但從來沒有真正理解透徹他們之間的聯絡。下面打算好好從

【機器學習算法-python實現】掃黃神器-樸素貝葉斯分類器的實現

github border release Language 出現 span bus pytho rds 版權聲明:本文為博主原創文章,未經博主同意不得轉載。 https://blog.c

Spark2.0機器學習系列之2:Logistic迴歸及Binary分類(二分問題)結果評估

引數設定 α: 梯度上升演算法迭代時候權重更新公式中包含 α : # 梯度上升演算法-計算迴歸係數 # 每個迴歸係數初始化為1 # 重複R次: # 計算整個資料集的梯度 # 使用α*梯度更新迴歸係數的向量 # 返回迴歸係數

機器學習(二):logistic迴歸

基礎知識: logistic迴歸其實是一個分類問題,可以定義如下:c為2時是一個兩類分類問題. 當分佈為伯努利分佈時: logistic迴歸和線性迴歸類似,不同的條件概率是不同的,方程如下: 其中:sigmoid函式定義如下: 使用logist

Python3《機器學習實戰》學習筆記(六):Logistic迴歸基礎篇之梯度上升演算法

一 前言 本文從Logistic迴歸的原理開始講起,補充了書上省略的數學推導。本文可能會略顯枯燥,理論居多,Sklearn實戰內容會放在下一篇文章。自己慢慢推導完公式,還是蠻開心的一件事。 二 Logistic迴歸與梯度上升演算法 Logistic迴歸是眾

機器學習實戰——基於概率論的分類方法:樸素貝葉斯(二)

使用貝葉斯過濾垃圾郵件 1.準備資料:切分文字 將字串切分為詞列表時,倘若沒有split引數,則標點符號也會被當成詞的一部分,可以使用正則表示式來切分句子,其中分隔符是除了單詞,數字之外的任意字串

用Python開始機器學習(6:樸素貝葉斯分類器)

樸素貝葉斯分類器是一個以貝葉斯定理為基礎,廣泛應用於情感分類領域的優美分類器。本文我們嘗試使用該分類器來解決上一篇文章中影評態度分類。1、貝葉斯定理假設對於某個資料集,隨機變數C表示樣本為C類的概率,F1表示測試樣本某特徵出現的概率,套用基本貝葉斯公式,則如下所示:上式表示對

深度學習系列文章之二中:win7+Ubantu雙系統裝機步驟(硬碟安裝)

64位Win7系統下安裝ubantu14.04雙系統 4.安裝Ext2Fsd軟體,安裝過程中記得勾選以下選項!!!否則會出錯(光碟安裝可以跳過這步)。 安裝完成後在分配的10GB磁碟空間上右鍵->Service Management,在彈出的頁面選點S

線性分類模型(二):logistic迴歸模型分析

前言 上一篇文章介紹了線性判別模型,本文介紹線性生成模型——logistic迴歸模型。本文介紹logstic迴歸模型相關的知識,為了更好理解模型的決策邊界函式,本文同時分析了多元變數的協方差對概率分佈的影響。 目錄 1、logistic迴歸模型的含義 2、l

機器學習筆記 第2課:適用於所有演算法的原則

機器學習中的監督學習演算法,常常用於預測建模。這些演算法有一個共通的原則。 人們一般這樣來描述機器學習演算法:學習一個目標函式(f),能夠最好地將輸入變數(X)對映到輸出變數(Y)。 Y = f(X) 這是一個常見的學習任務。我們期望在給定新的輸入變數(X)時,對(Y)做出預測。 我們並不知

機器學習——樸素貝葉斯(Naive Bayes)詳細解讀

在機器學習中,樸素貝葉斯是一個分類模型,輸出的預測值是離散值。在講該模型之前首先有必要先了解貝葉斯定理,以該定理為基礎的統計學派在統計學領域佔據重要的地位,它是從觀察者的角度出發,觀察者所掌握的資訊量左右了觀察者對事件的認知。 貝葉斯公式

機器學習 (九) 深入淺出貝葉斯-Thomas Bayes

注意:貝葉斯是一個偉大的發明,給人工智慧以及社會發展帶來了巨大貢獻**。 引言 隨著對貝葉斯的不斷應用,對貝葉斯有了從新的認識,以前認為貝葉斯知識用來解決二分類問題,是大錯特錯發現貝葉斯是一種

機器學習之樸素貝葉斯(附垃圾郵件分類)

樸素貝葉斯分類器介紹概述 樸素貝葉斯分類器技術基於貝葉斯定理,特別適用於輸入維數較高的情況。儘管樸素貝葉斯方法簡單,但它通常比更復雜的分類方法更勝一籌。

機器學習演算法之樸素貝葉斯(Naive Bayes)--第二篇

引言 這篇文章主要介紹將樸素貝葉斯模型應用到文字分類任務的技巧和方法。 詞袋模型(The Bag of Words Model) 對於機器學習演算法來說,特徵的選擇是一個很重要的過程。那麼如何從文字訓練集中選出好的特徵呢?在自然語言處理中,一個常見