從基礎出發:統計學習方法三要素

統計學習方法,初聽起來感覺很陌生,到底什麼是統計學習方法,怎麼去理解?李航老師版的《統計學習方法》給了詳細的解釋,以下是我的理解,如理解有偏差,還望指教。

統計學習方法由三個要素構成,即 模型 、策略和演算法。

模型是來確定一個假設;策略用來驗證或糾正模型的好壞;而演算法,是在選定模型和策略後,使用某種計算方法來使模型最優。

對於模型來說:

我們得確定一個假設,假設資料集是線性模型、概率模型還是其它的模型,這個可以假設的模型是無窮的,每個模型當然有對應的引數。

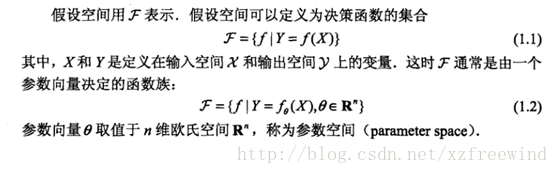

如對於決策函式的模型,即非概率模型,它的表現形式是:

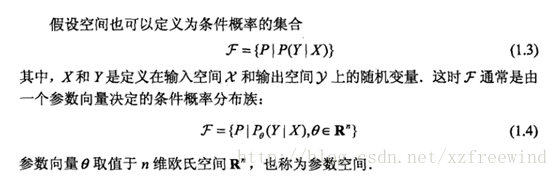

對於條件概率的集合,即概率模型,它的表現形式是:

對於策略來說:

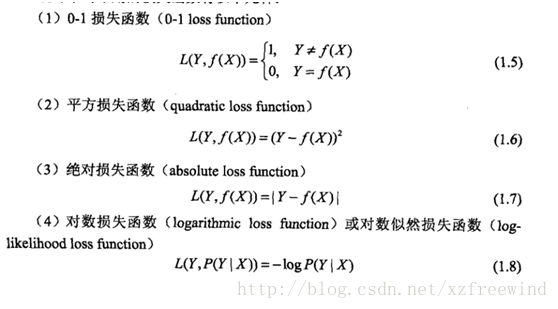

確定好模型後,我們得確定一個規則,來判斷我們這個模型的好壞,模型的引數怎麼設定可以達到該模型最好的效果,這就是策略。即我們常常聽到的損失函式、風險函式。損失函式用來度量模型一次的好壞,而對於風險函式,度量的是平均意義下模型預測的好壞。常用的損失函式有:

損失函式數值越小,模型就越好。然而,對於一個樣本,我們不能評論這個模型好不好,我們得針對整個樣本集來對模型進行判斷,因此呢,損失函式的疊加再取均值,即風險函式,才能評價模型的好壞。

再說說期望風險和經驗風險(風險函式)的關係。我們真正想得到的最小的風險,即期望風險,這個怎麼求呢,是需要遍歷所有的關於這個模型下的樣本集,然而,受到樣本集的制約,我們不可能所有的樣本集都能遍歷到(一是本身就不現實,二是所有的樣本集都有了,我們還折騰統計學習幹什麼…)。既然不能真正得到期望風險,那怎麼得到一個和期望風險相近的值呢。上有政策,下有對策,根據大數定理,當樣本集N足夠大時,經驗風險≈期望風險

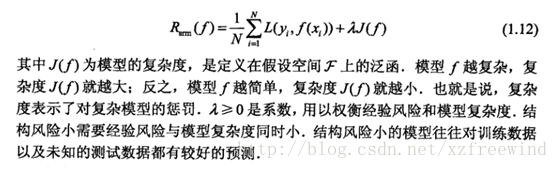

但是,如果樣本N不多,怎麼搞?經驗風險就不是很管用了誒。這時候,嘿嘿,結構風險最小化出來了。結構風險最小化是防止過擬合而提出來的策略,等價於在經驗風險上加上表示模型複雜度的正則化項或懲罰項,定義為:

對於演算法來說:

演算法就是指在選定模型和策略後,通過相應模型和策略的計算方法來對資料集求解最優模型。演算法要做的事呢,就是通過引數的調整來使模型達到最優,這就涉及到了求最優解的問題,也會遇到區域性最優解的問題,這個問題是學習演算法中經常遇到的,怎麼來解決,這裡就先不探討了。