【神經網路】神經元ReLU、Leaky ReLU、PReLU和RReLU的比較

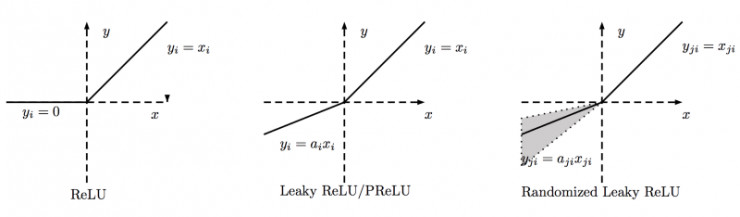

下圖是ReLU、Leaky ReLU、PReLU和RReLU的比較:

ReLU,對小於0部分,直接置為0;

Leaky ReLU,對小於0部分,進行這樣的轉換:y_i=a_i * x_i ,它的a_i是固定的;

PReLU中的a_i 根據資料變化而變化;

RReLU中的a_i是一個在一個給定的範圍內隨機抽取的值,這個值在測試環節就會固定下來。

相關推薦

【神經網路】神經元ReLU、Leaky ReLU、PReLU和RReLU的比較

下圖是ReLU、Leaky ReLU、PReLU和RReLU的比較: ReLU,對小於0部分,直接置為0; Leaky ReLU,對小於0部分,進行這樣的轉換:y_i=a_i

【神經網路】VGG、ResNet、GoogleLeNet、AlexNet等常用網路程式碼及預訓練模型

常用資料集: 模型們在ImageNet競賽上的top-5錯誤率概況: 常用預訓練模型池: AlexNet資訊如上圖 - 在當時第一次使用了ReLU - 使用了Norm層(在當時還不廣泛) - 訓練資料量增大 - dropout 0.5 - 每批資料

【神經網路】卷積層輸出大小計算(長、寬、深度)

先定義幾個引數 輸入圖片大小 W×W Filter大小 F×F 步長 S padding的畫素數 P 於是我們可以得出 N = (W − F + 2P )/S+1 輸出圖片大小為 N×N 轉載: 卷積中的特徵圖大小計算方式有兩種,分別是‘VALID’和‘SAM

【神經網路】RELU 啟用函式及其他相關的函式

轉載自:http://blog.csdn.net/u013146742/article/details/51986575 日常 coding 中,我們會很自然的使用一些啟用函式,比如:sigmoid、ReLU等等。不過好像忘了問自己一(n)件事: 為什

【神經網路】自編碼聚類演算法--DEC (Deep Embedded Clustering)

1.演算法描述 最近在做AutoEncoder的一些探索,看到2016年的一篇論文,雖然不是最新的,但是思路和方法值得學習。論文原文連結 http://proceedings.mlr.press/v48/xieb16.pdf,論文有感於t-SNE演算法的t-

【神經網路】神經網路視覺化工具

t-SNE 方法:在fc7(倒數第一層fc)提取輸出,並用歐氏距離遠近展示(或聚類)。好的網路可以直觀看到同分類的圖片聚在一起,幾何上易被切割出來。 一個例子: Visualizing Activations 方法: 1. 逆向使用已訓練好的神經網路生成圖

【神經網路】神經網路架構大全剖析(附原始論文地址)

隨著新的神經網路架構不時出現,很難跟蹤這些架構。知道所有縮寫(DCIGN,BiLSTM,DCGAN,anyone?)起初可能有點壓倒性。 所以我決定編寫一個包含許多這些體系結構的備忘單。這些大多數是神經網路,有些是完全不同的野獸。雖然所有這些體系結構都是新穎而獨特的,但是當

【神經網路】神經網路加速之量化模型

1.簡介 量化模型(Quantized Model)是一種模型加速(Model Acceleration)的方法的總稱,主要包括二值化網路(Binary Network)、三值化網路(Ternary Network)、深度壓縮(Deep Compre

【神經網路】GAN原理總結,CatGAN

定義及原理: 生成器 (G)generator:接收一個隨機的噪聲z(隨機數),通過這個噪聲生成影象。G的目標就是儘量生成真實的圖片去欺騙判別網路D。 判別器(D) discriminator:對接收的圖片進行真假判別。它的輸入引數是x

【神經網路與深度學習】neural-style、chainer-fast-neuralstyle影象風格轉換使用

1. 安裝 我的作業系統是win10,裝了Anaconda,TensorFlow包是通過pip安裝的,中間沒什麼可說的.具體看TensorFlow官網就可以了. 2. 使用 python neural_style.py --content <content fi

【python實現卷積神經網路】卷積層Conv2D實現(帶stride、padding)

關於卷積操作是如何進行的就不必多說了,結合程式碼一步一步來看卷積層是怎麼實現的。 程式碼來源:https://github.com/eriklindernoren/ML-From-Scratch 先看一下其基本的元件函式,首先是determine_padding(filter_shape, ou

【神經網路入門】用JAVA實現感知器演算法

簡述 隨著網際網路的高速發展,A(AI)B(BigData)C(Cloud)已經成為當下的核心發展方向,假如三者深度結合的話,AI是其中最核心的部分。所以如果說在未來社會,每個人都必須要學會程式設計的話,那麼對於程式設計師來說,人工智慧則是他們所必須掌握的技術(科技發展真tm快)。 這篇文章介紹

【計算機網路】(一)OSI, TCP/IP模型 & 網路HTTP、TCP、UDP、Socket 基本知識總結

OSI 七層模型 我們一般使用的網路資料傳輸由下而上共有七層,分別為物理層、資料鏈路層、網路層、傳輸層、會話層、表示層、應用層,也被依次稱為 OSI 第一層、第二層、⋯⋯、 第七層。 如下圖: 各層功能簡介 1.物理層(Physical Layer)

【神經網路和深度學習】筆記

文章導讀: 1.交叉熵損失函式 1.1 交叉熵損失函式介紹 1.2 在MNIST數字分類上使用交叉熵損失函式 1.3 交叉熵的意義以及來歷 1.4 Softmax 2. 過擬合和正則化 2.1 過擬合 2.2 正則化 2.3 為什麼正則化可以減輕

【計算機視覺】【神經網路與深度學習】YOLO v2 detection訓練自己的資料

轉自:http://blog.csdn.net/hysteric314/article/details/54097845 說明 這篇文章是訓練YOLO v2過程中的經驗總結,我使用YOLO v2訓練一組自己的資料,訓練後的model,在閾值為.25的情況下,Reca

【卷積神經網路】Lesson 3--目標檢測

課程來源:吳恩達 深度學習課程 《卷積神經網路》 筆記整理:王小草 時間:2018年6月8日 1.目標定位Object localization 1.1 什麼是目標定位 明確下目標定位與檢測的定義。 識別一張圖片的型別(比如貓狗分類)叫做影象分類image c

【神經網路入坑記】深度學習和神經網路的區別

入坑神經網路有一段時間,決定寫寫部落格記錄下學到的知識點,哪怕是一點點的內容,以後想看了也有個著落吧。。。 這次梳理的內容是神經網路、深度學習的一個關係 之前雖然看了一些演算法,自己也嘗試著畫了一些葫蘆,不過後來發現對於深度學習和神經網路有些混亂 寫個部落格做下筆記: 在人

【神經網路與深度學習】【計算機視覺】SSD

背景介紹: 基於“Proposal + Classification” 的 Object Detection 的方法,R-CNN 系列(R-CNN、SPPnet、Fast R-CNN 以及 Faster R-CNN),取得了非常好的結果,但是在速度方面離實時效果還比較遠在提高 mAP 的同時兼顧速度,逐

【神經網路學習筆記】LIBSVM引數講解

支援向量機SVM(Support Vector Machine)作為一種可訓練的機器學習方法可以實現模式分類和非線性迴歸,本文就matlab中的LIBSVM工具箱展開說明。 在matlab中呼叫LIBSVM工具箱可以方便的使用LIBSVM網路,臺灣大學的林智仁教授已經封裝好

【神經網路與深度學習】Google Protocol Buffer介紹

簡介 什麼是 Google Protocol Buffer? 假如您在網上搜索,應該會得到類似這樣的文字介紹: Google Protocol Buffer( 簡稱 Protobuf) 是 Google 公司內部的混合語言資料標準,目前已經正在使用的有超過 48,162 種報文格式定義和超過 12,1