邏輯迴歸和梯度下降

1. 概率

1.1 定義

![]()

1.2 範圍

![]()

1.3 計算方法

1.3.1 根據個人置信

1.3.2 根據歷史資料

1.3.3 根據模擬資料

1.4 條件概率

2.

2.1 基本模型

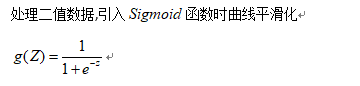

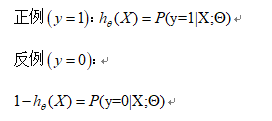

預測函式:

用概率表示:

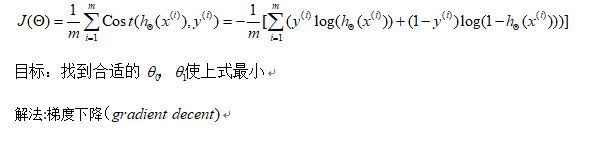

2.2 Cost函式

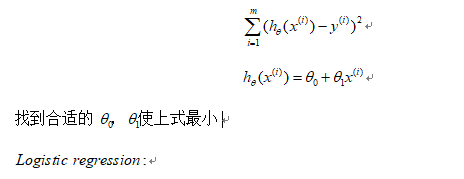

線性迴歸:

Cost函式:

相關推薦

邏輯迴歸和梯度下降

1. 概率 1.1 定義 1.2 範圍 1.3 計算方法 1.3.1 根據個人置信 1.3.2 根據歷史資料 1.3.3 根據模擬資料 1.4 條件概率 2. 2.1 &

線性迴歸和梯度下降講解與程式碼

本文也是根據吳恩達機器學習課程作業的答案。 迴歸:預測值是連續的; 分類:預測值是離散的; 建模誤差:預測值與實際值之間的差距; 目標:選擇模型引數,使得建模誤差的平方和能夠最小,即代價函式最小; 代價函式:選擇平方誤差函式,是解決迴歸問題最常用的手段;代價函式是幫助我們選擇最優

邏輯迴歸與梯度下降

Logistic迴歸為概率型非線性迴歸模型,是研究二分類觀察結果與一些影響因素之間關係的一種 多變數分析方法。通常的問題是,研究某些因素條件下某個結果是否發生,比如醫學中根據病人的一些症狀來判斷它是 否患有某種病。 在講解Logistic迴歸理論之前,我們先從LR分類器說

Logistic迴歸和梯度下降總結

原文:http://blog.csdn.net/dongtingzhizi/article/details/15962797 Logistic迴歸總結 1.引言 看了Stanford的Andrew Ng老師的機器學習公開課中關於Logistic Reg

1.2.2 Logistic迴歸和梯度下降計算的數學流程

計算圖 可以說,一個神經網路的計算都是按照前向或者反向傳播過程來實現的,首先計算出神經網路的輸出,緊接著一個反向傳播的操作。後者,我們用來計算出對應的梯度或者導數。這個流程圖解釋了為什麼用這樣的方式來實現。 我們舉一個更為簡單的函式為例,如何計算該函式。具體

邏輯迴歸與梯度下降法

轉載自:http://www.cnblogs.com/yysblog/p/3268508.html 一、邏輯迴歸 1) Classification(分類) 分類問題舉例: 郵件:垃圾郵件/非垃圾郵件?線上交易:是否欺詐(是/否)?腫瘤:惡性/良性? 以上問題可以

邏輯回歸和梯度下降簡單應用案例

error () body xlabel 所有 def app 4.6 9.4 實例: 我們將建立一個邏輯回歸模型來預測一個學生是否被大學錄取。 假設你是一個大學系的管理員,你想根據兩次考試的結果來決定每個申請人的錄取機會。 你有以前的申請人的歷史數據,你可以用它作為邏輯回

機器學習----線性迴歸原理---最下二乘法和梯度下降怎麼來的-----專案預測大學生是否被錄取程式碼案例

這節課說明了 最下二乘法 是怎麼來的。 接下來是面試需要問的 誤差,(機器學習是建立在獨立同分布的基礎上,事實上,根本無法證明獨立同分布而且是正態分佈,我們假設的,只要模型可用,就可以) 獨立: 每個人的

機器學習3 邏輯斯提回歸和梯度下降演算法

引言 上節我們介紹了很多線性迴歸模型,如何用線性模型做分類任務呢?是不是可以將線性迴歸模型的預測值和到分類任務的標記聯絡起來呢? 邏輯斯提回歸 對於一個二分類任務,輸出標記y為{0,1},而線性迴歸模型產生的預測值z為全體實數,我們想把z轉換成0/1值。我們首先想到是“單位階躍函式”。

斯坦福大學機器學習筆記——單變數的線性迴歸以及損失函式和梯度下降法(包含程式碼)

迴歸問題: 所謂的迴歸問題就是給定的資料集,且每個資料集中的每個樣例都有其正確的答案,通過給定的資料集進行擬合,找到一條能夠最好代表該資料集的曲線,然後對於給定的一個樣本,能夠預測出該樣本的答案(對於迴歸問題來說,最終的輸出結果是一個連續的數值)。比如

【機器學習詳解】線性迴歸、梯度下降、最小二乘的幾何和概率解釋

線性迴歸 即線性擬合,給定N個樣本資料(x1,y1),(x2,y2)....(xN,yN)其中xi為輸入向量,yi表示目標值,即想要預測的值。採用曲線擬合方式,找到最佳的函式曲線來逼近原始資料。通過使得代價函式最小來決定函式引數值。 採用斯坦福大學公開課的

機器學習筆記 1 LMS和梯度下降(批梯度下降) 20170617

temp eas 理解 import 樣本 alt mes show 超過 # 概念 LMS(least mean square):(最小均方法)通過最小化均方誤差來求最佳參數的方法。 GD(gradient descent) : (梯度下降法)一種參數更新法則。可以作為L

機器學習 LR中的參數叠代公式推導——極大似然和梯度下降

jpg blog 我們 應該 圖片 最大似然 gpo 機器學習實戰 pos 機器學習 LR中的參數叠代公式推導——極大似然和梯度下降 Logistic本質上是一個基於條件概率的判別模型(DiscriminativeModel)。

深度學習——線性單元和梯度下降

每次 總結 只知道 指向 預測 模型 pre 叠代 $$ 機器學習的一些基本概念,模型、目標函數、優化算法等等,這些概念對於機器學習算法來說都是通用的套路。 線性單元 當我們面對的數據不是線性可分的時候,感知器規則就無法收斂,為了解決這個問題,我們使用一個可導的線性

斯坦福CS229機器學習課程筆記一:線性迴歸與梯度下降演算法

機器學習三要素 機器學習的三要素為:模型、策略、演算法。 模型:就是所要學習的條件概率分佈或決策函式。線性迴歸模型 策略:按照什麼樣的準則學習或選擇最優的模型。最小化均方誤差,即所謂的 least-squares(在spss裡線性迴歸對應的模組就叫OLS即Ordinary Least Squares):

深度學習筆記——線性單元和梯度下降

程式碼參考了零基礎入門深度學習(2) - 線性單元和梯度下降這篇文章,我只對程式碼裡可能存在的一些小錯誤進行了更改。至於線性單元的原理以及程式碼裡不清楚的地方可以結合該文章理解,十分淺顯易懂。 from DL.perceptron import Perceptron # 定義啟用函式f f =

機器學習筆記(一):最小二乘法和梯度下降

一、最小二乘法 1.一元線性擬合的最小二乘法 先選取最為簡單的一元線性函式擬合助於我們理解最小二乘法的原理。 要讓一條直接最好的擬合紅色的資料點,那麼我們希望每個點到直線的殘差都最小。 設擬合直線為

機器學習入門 線性迴歸及梯度下降

分享一下我老師大神的人工智慧教程!零基礎,通俗易懂!http://blog.csdn.net/jiangjunshow 也歡迎大家轉載本篇文章。分享知識,造福人民,實現我們中華民族偉大復興!

最小二乘法和梯度下降法有哪些區別?

https://www.zhihu.com/question/20822481 最小二乘法的目標:求誤差的最小平方和,對應有兩種:線性和非線性。線性最小二乘的解是closed-form即,而非線性最小二乘沒有closed-form,通常用迭代法求解。 迭代法,即在每一步update未知量逐漸

吳恩達深度學習deeplearning.ai-Week2課後作業-Logistic迴歸與梯度下降向量化

一、deeplearning-assignment 這篇文章會幫助構建一個用來識別貓的邏輯迴歸分類器。通過這個作業能夠知道如何進行神經網路學習方面的工作,指導你如何用神經網路的思維方式做到這些,同樣也會加深你對深度學習的認識。 儘量不要在程式碼中出現for迴圈,可以用nu