IDEA+scala外掛開發spark程式

spark由scala語言編寫,開發spark程式,自然也少不了scala環境,這裡介紹如何利用Intellij IDEA開發spark。

1、環境準備。jdk,scala,idea這些對於本文來說都已經預設安裝。

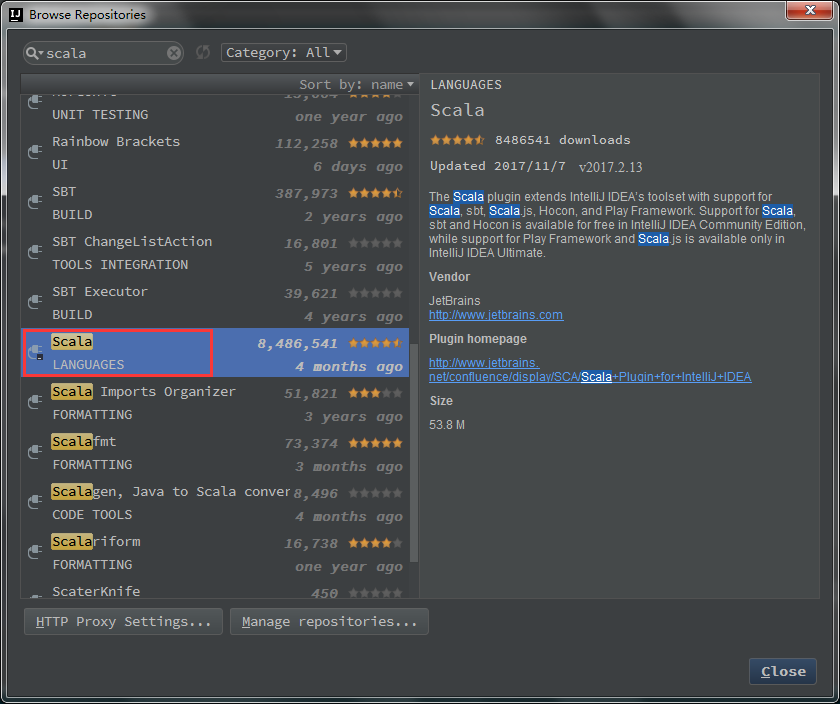

2、idea中安裝scala language外掛。File->Settings->Plugins->Browse Repositories,搜尋scala。選中Scala,點選Install。

3、新建java工程。

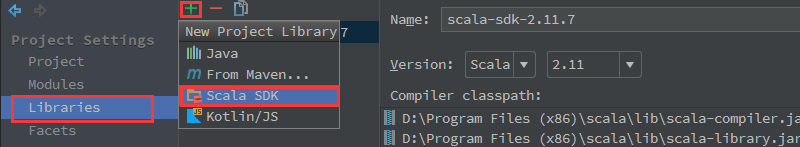

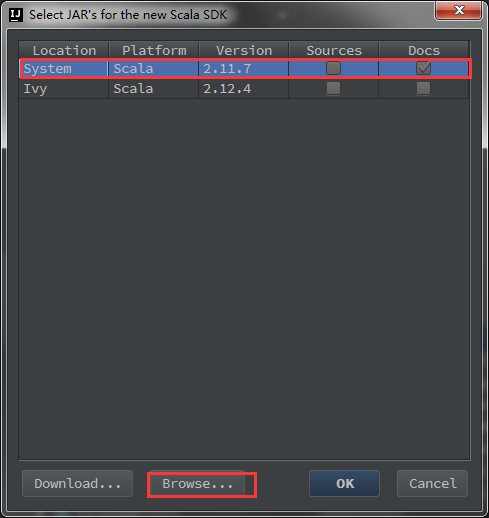

4、設定scala sdk。File->Project Structure->Libraries->+,新建Scala SDK。

如果之前沒有配置過系統的scala sdk,選擇Browse,指定系統中安裝的scala位置。

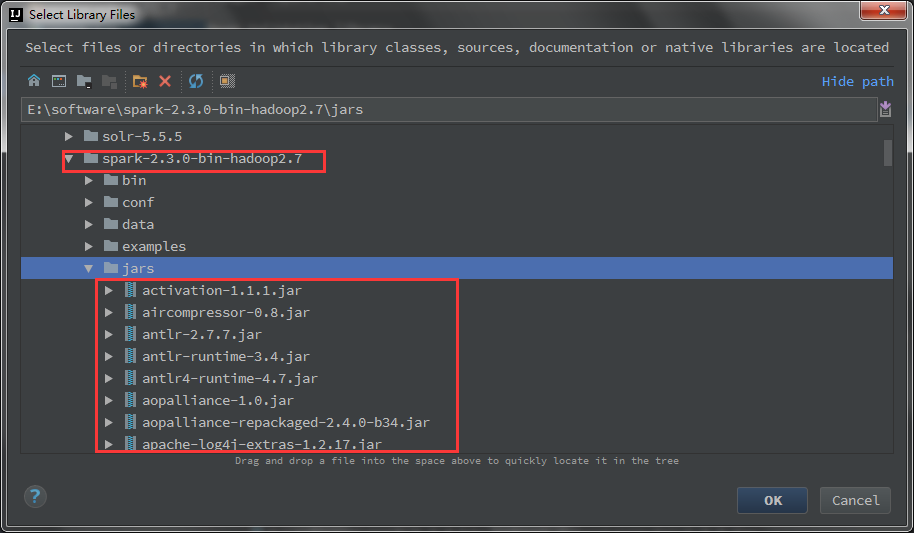

5、匯入spark-library。繼續上一步中的File->Project Structure->Libraries->+Java。新建一個java的庫,然後匯入spark的jar包。最後可以對jar資料夾命名。這裡我叫spark-lib。

最終形成的libary長這樣子。

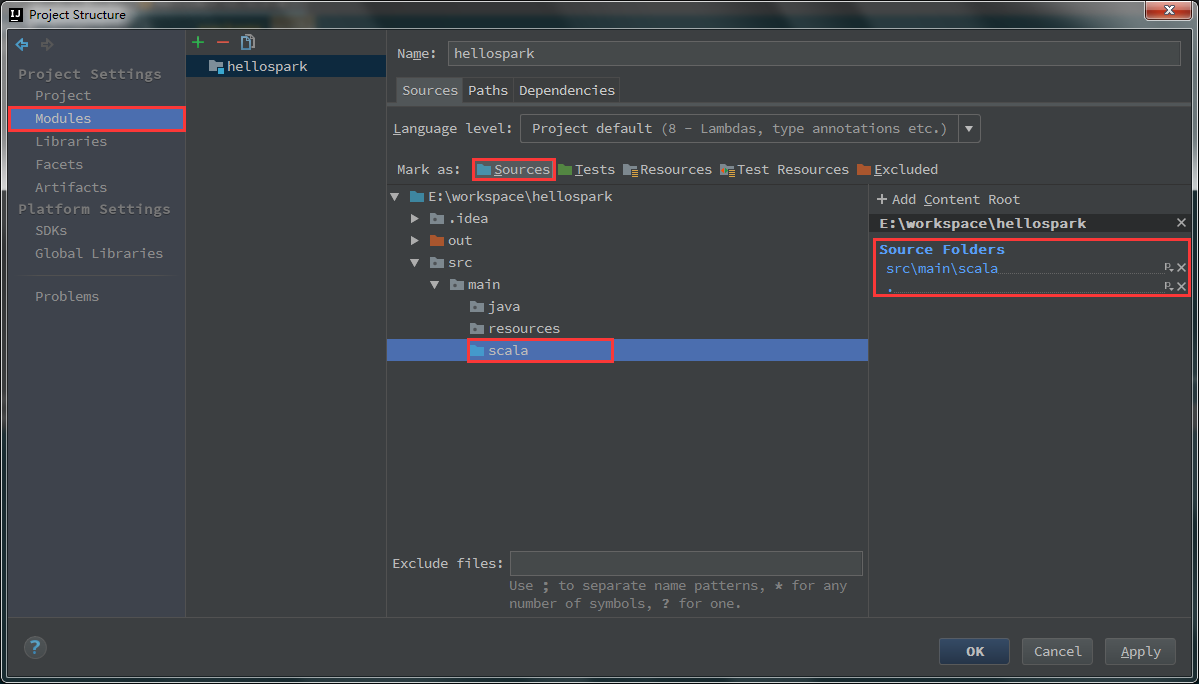

6、設定sources。File->Project Structure->Modules->Sources->src。這裡選中src,右鍵New Folder取名main,然後在main下面new folder:java,resources,scala。最後右鍵scala資料夾,選擇Sources。然後右側的+Add Content Root下面就會增加src\main\scala作為原始檔夾。

如果不設定原始檔夾或者設定錯誤,後面執行spark程式會出錯。

不設定時,報錯

錯誤: 找不到或無法載入主類 scala.HelloWorld

main,main\scala資料夾均設定為Sources就會報如下錯誤,因此只需要設定scala資料夾為Sources。

Error:(5, 8) HelloWorld is already defined as object HelloWorld

object HelloWorld {7、編寫程式。右鍵scala資料夾->New->Scala Class->選擇object。

編碼如下:

package scala import org.apache.spark.{SparkConf, SparkContext} object HelloWorld { def main(args: Array[String]): Unit = { val logFile = "E:\\software\\spark-2.3.0-bin-hadoop2.7\\helloSpark.txt" val conf = new SparkConf().setAppName("wordcount").setMaster("local") val sc = new SparkContext(conf) val rdd = sc.textFile(logFile) val counts = rdd.flatMap(line=>line.split(",")).map(x=>(x,1)).reduceByKey((x,y)=>(x+y)) counts.foreach(println) sc.stop() } }

執行,Ctrl+Shift+F10。

以下是部分日誌,單詞統計結果出現在日誌中:

2018-04-04 23:32:57 INFO Executor:54 - Running task 0.0 in stage 1.0 (TID 1) 2018-04-04 23:32:57 INFO ShuffleBlockFetcherIterator:54 - Getting 1 non-empty blocks out of 1 blocks 2018-04-04 23:32:57 INFO ShuffleBlockFetcherIterator:54 - Started 0 remote fetches in 6 ms (scala,1) (spark,2) (hello,3) (sparkui,1) (java,1) 2018-04-04 23:32:57 INFO Executor:54 - Finished task 0.0 in stage 1.0 (TID 1). 1138 bytes result sent to driver 2018-04-04 23:32:57 INFO TaskSetManager:54 - Finished task 0.0 in stage 1.0 (TID 1) in 56 ms on localhost (executor driver) (1/1) 2018-04-04 23:32:57 INFO TaskSchedulerImpl:54 - Removed TaskSet 1.0, whose tasks have all completed, from pool 2018-04-04 23:32:57 INFO DAGScheduler:54 - ResultStage 1 (main at <unknown>:0) finished in 0.072 s 2018-04-04 23:32:57 INFO DAGScheduler:54 - Job 0 finished: main at <unknown>:0, took 0.859162 s 2018-04-04 23:32:57 INFO AbstractConnector:318 - Stopped [email protected]{HTTP/1.1,[http/1.1]}{0.0.0.0:4040} 2018-04-04 23:32:57 INFO SparkUI:54 - Stopped Spark web UI at http://10.119.9.164:4040

相關推薦

IDEA+scala外掛開發spark程式

spark由scala語言編寫,開發spark程式,自然也少不了scala環境,這裡介紹如何利用Intellij IDEA開發spark。1、環境準備。jdk,scala,idea這些對於本文來說都已經預設安裝。2、idea中安裝scala language外掛。File-&

MAC下搭建Intellij IDEA+Scala SDK+Scala外掛開發環境

MAC下搭建Intellij IDEA+Scala SDK+Scala外掛環境 網上很多配置Scala開發環境的都不完整, 只安裝了Scala外掛,沒有Scala SDK。親試後如下: 前提環境: Mac電腦+Intellij IDEA+JAVA 8 步驟如下:

IntelliJ Idea開發spark程式及執行

版本:spark-1.6.0,IntelliJ Idea15 1.建立一個SBT專案 2.編寫簡單程式碼 package com.james.scala /* SimpleApp.scala */ import org.apache.spa

idea,maven打包spark程式(scala)的jar檔案

1.new-->project--->maven 填入GroupId和ArtifactId(相當於給你的專案起名字) 2.在pom.xml中<project>標籤中建立</dependencies>標籤 3.在http://mvnr

maven環境下使用java、scala混合開發spark應用

熟悉java的開發者在開發spark應用時,常常會遇到spark對java的介面文件不完善或者不提供對應的java介面的問題。這個時候,如果在java專案中能直接使用scala來開發spark應用,同時使用java來處理專案中的其它需求,將在一定程度上降低開發spark專案的

Lua——配置IDEA+EmmyLua外掛開發環境

下載安裝IntelliJ IDEA https://www.jetbrains.com/idea/?fromMenu 安裝EmmyLua外掛 1.開啟Idea,進入File-Settings-Plugins,搜尋EmmyLua並安裝。 安裝完之後,重啟IDEA。 建立專案

scala編寫的Spark程式遠端提交到伺服器叢集上執行

一.需要的軟體: eclipse 相應版本的scalaIDE 與叢集一樣的spark安裝包,主要是要用到spark中的jar包 與叢集一樣的hadoop安裝包 與hadoop版本對應的winutil.exe,hadoop.dll(只要版本差距不大不一樣也沒關

Intellij Idea golang外掛開發

1、安裝Intellij idea 的golang外掛 2、建立目錄:D:\SystemFile\GoWorkspace 在系統裡面配置GOPATH=D:\SystemFile\GoWorkspace,然後在GOPATH目錄下面建立 src, bin, pkg三個目錄,然後

SCALA_IDE開發Spark程式

IDEA Eclipse 下載scala 下載地址 scala.msi scala環境變數配置 (1)設定SCALA-HOME變數:如圖,單擊新建,在變數名一欄輸入: SCALA-HOME 變數值一欄輸入: D:\Prog

idea + go外掛開發

問題 idea出現找不到庫的問題,一般都是project structure裡面設定的庫有問題,或者是GOPATH設定有問題 -持續補充 歡迎使用Markdown編輯器寫部落格 本Markdown編輯器使用StackEdit修改而來,用它寫部落格,將

intellij idea的外掛開發小結

最近在做一個intellij idea的外掛,作用是讀取資料庫的表及欄位的資訊和預先定義的模板來生成程式碼檔案(實體,service,springmvc中的controller,freemark檔案等等)。 1.配置資訊的持久化 《IntelliJ IDEA Plug

sbt的安裝以及用sbt編譯打包scala編寫的spark程式

眾所周知,spark可以使用三種語言進行編寫,分別是scala,phython,java三種語言,而且執行方式不同,Scala是用sbt編譯打包,Java是用Maven進行編譯打包,而phython則是用spark-submit提交執行。而sbt本身就是用sca

IDEA搭建scala開發環境開發spark應用程式

一、idea社群版安裝scala外掛 因為idea預設不支援scala開發環境,所以當需要使用idea搭建scala開發環境時,首先需要安裝scala外掛,具體安裝辦法如下。 1、開啟idea,點選configure下拉選單中的plugins選項: 2、在彈出對話方塊中點選紅框按鈕: 3、在彈出最新對話

通過IDEA搭建scala開發環境開發spark應用程式

一、idea社群版安裝scala外掛因為idea預設不支援scala開發環境,所以當需要使用idea搭建scala開發環境時,首先需要安裝scala外掛,具體安裝辦法如下。1、開啟idea,點選configure下拉選單中的plugins選項:2、在彈出對話方塊中點選紅框按鈕:3、在彈出最新對話方塊的搜尋欄輸

使用idea和maven開發和打包scala和spark程式

使用idea構建maven管理的scala和spark程式,預設已經裝好了idea、scala並在idea中安裝了scala外掛。一、新建Maven專案開啟idea,點選File—New—Project,彈出如下介面,選擇Maven專案,檢視是否是正確的JDK配置項正常來說這

IDEA搭建scala開發環境開發spark應用程序

編寫 運行程序 通過 https apach import input inf 搭建 一、idea社區版安裝scala插件 因為idea默認不支持scala開發環境,所以當需要使用idea搭建scala開發環境時,首先需要安裝scala插件,具體安裝辦法如下。 1、

idea開發第一個spark程式---統計文字單詞數

在建立專案之前確保自己本地安裝好了scala環境和java環境,因為spark是scala編寫的,scala和java一樣都是需要編譯成位元組碼,然後在JVM裡面執行。我本地的scala版本是2.11.0版本,hadoop是2.7.6版本 第一步:開啟idea,然後建立一個

安裝 IDEA、安裝 Scala 外掛以及匯入 Spark 原始碼

IDEA 全稱 IntelliJ IDEA,是 java 語言開發的整合環境(IDE),IntelliJ 在業界被公認為最好的 java 開發工具之一,尤其在智慧程式碼助手、程式碼自動提示、重構、J2EE 支援、Ant、JUnit、CVS整合、程式碼審查、 創新

IDEA 中開發第一個Spark 程式

1. 建立一個Maven 專案 2. 新增SCALA依賴庫 ****注意scala 的版本 相對於spark2.4 ,scala 的版本必須是2.11.x 修改POM.xml 檔案 加入 hadoop-client 和spark-core_2.11 的庫依賴

Spark 2.0視頻|快學Spark 2.0(新特性、含真實項目、純Scala語言開發、CDH5.7)

spark快學Spark 2.0(新特性、含真實項目、純Scala語言開發、CDH5.7)分享網盤下載——https://pan.baidu.com/s/1c2F9zO0 密碼: pzx9Spark進入2.0時代,引入了很多優秀特性,性能上有較大提升,API更易用。在“編程統一”方面非常驚艷,實現了離線計算和