邏輯迴歸多分類實現方法

邏輯迴歸主要用來解決二分類問題,但是在工作學習中,我們肯定會碰到多分類的問題,下面就簡單介紹下用邏輯迴歸解決多分類問題的方法。

one-VS-rest

從上面的名字就可以看出來,這個做法是通過對一個n分類問題訓練n個分類器,其中每個分類器是區分某一個類別和剩下所有類別的(1,0)。預測的時候,根據每個分類器預測為某一類(1)的概率,最大值即為預測結果。

優點:普適性較廣,效率相對較好,多少個類別訓練多少個分類器即可。

缺點:如果種類較多,各個分類器資料不平衡的現象就會非常明顯。

one-VS-one

顧名思義,就是對所有類別每兩個訓練一個分類器,那麼要訓練的分類器就有n*(n-1)/2 個,預測的時候就是投票法,每個分類器預測得到某個類別,看哪個類別最終得票最多就是結果。

這樣做的優點就是可以規避上一種方法訓練資料不平衡的問題,效能相對穩定;還有就是訓練模型雖然多,但是相對簡單,訓練效率會有提升。

缺點就是要訓練的分類器太多了,隨著分類的增多,要訓練的分類器個數呈平方級別的增長

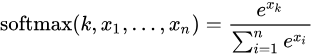

Softmax

softmax在數學定義上就是對LR二分類在多分類情況下的拓展。

在處理一些樣本可能叢屬多個類別的分類問題是,使用前兩種方法有可能達到更好的效果。

Softmax 迴歸適合處理一個樣本儘可能屬於一種類別的多分類問題。

Reference

相關推薦

邏輯迴歸多分類實現方法

邏輯迴歸主要用來解決二分類問題,但是在工作學習中,我們肯定會碰到多分類的問題,下面就簡單介紹下用邏輯迴歸解決多分類問題的方法。 one-VS-rest 從上面的名字就可以看出來,這個做法是通過對一個n分類問題訓練n個分類器,其中每個分類器是區分某一個類別和剩下所

【原】Andrew Ng斯坦福機器學習 Coursera—Programming Exercise 3 邏輯迴歸多分類和神經網路

作業說明 Exercise 3,Week 4,使用Octave實現手寫數字0-9的識別,採用兩種方式(1)邏輯迴歸多分類(2)三層神經網路多分類。對比結果。 每張圖片20px * 20px,也就是一共400個特徵(因為Octave裡從1開始。所以將0對映為10) (1)邏輯迴歸多分類:實現 lrCost

Machine Learning--week3 邏輯迴歸函式(分類)、決策邊界、邏輯迴歸代價函式、多分類與(邏輯迴歸和線性迴歸的)正則化

Classification It's not a good idea to use linear regression for classification problem. We can use logistic regression algorism, which is a classificati

吳恩達機器學習 - 邏輯迴歸——多元分類 吳恩達機器學習 - 邏輯迴歸——多元分類

原 吳恩達機器學習 - 邏輯迴歸——多元分類 2018年06月19日 20:47:49 離殤灬孤狼 閱讀數:98 更多

邏輯迴歸原理與實現

前提 程式碼 import numpy as np import os def loadData(dir): trainfileList = os.listdir(dir) m = len(trainfileList) dataArray = np

吳恩達機器學習——邏輯迴歸和分類演算法

高效使用軟體 如下所示,是一個函式,這是一個求theta和x的積的和的公式,這個問題我們可以輕鬆地通過矩陣的方式解決。 將theta和x以如下形式表示,theta和x的矩陣的積就是這個函式的結果。 求解theta的值 進行邏輯分解: Th

邏輯迴歸的python實現

#coding=utf-8 import math import numpy as np import pandas as pd from sklearn import preprocessing from sklearn import metrics

NG機器學習總結-(四)邏輯迴歸以及python實現

在第一篇部落格NG機器學習總結一中,我們提到了監督學習通常一般可以分為兩類:迴歸和分類。線性迴歸屬於迴歸問題,例如房價的預測問題。而判斷一封郵件是否是垃圾郵件、腫瘤的判斷(良性還是惡性)、線上交易是否欺詐都是分類問題,當然這些都是二分類的問題。 Email:Spam /

機器學習演算法 之邏輯迴歸以及python實現

下面分為兩個部分: 1. 邏輯迴歸的相關原理說明 2. 通過python程式碼來實現一個梯度下降求解邏輯迴歸過程 邏輯迴歸(Logistic Regression) 首先需要說明,邏輯迴歸屬於分類演算法。分類問題和迴歸問題的區別在於,分類問題的輸出是離散

邏輯迴歸及其python實現

邏輯迴歸原理 sigmod函式 下圖給出了sigmod 函式在不同座標尺度下的兩條曲線圖。當 x 為 0 日牝 Sigmoid 函式值為 0.5 。 隨著 1 的增大,對應的sigmod值將逼近於 1; 而隨著 x 的減小, Sigmoid 值將逼近於

二,機器學習演算法之邏輯迴歸(python實現)

邏輯迴歸(Logistic Regression)是目前流行最廣泛的演算法之一。 1. 何為邏輯迴歸: 邏輯迴歸主要思想是根據現有的訓練集(資料)進行分類,判斷這些資料屬於哪一個類別,通

機器學習筆記 -吳恩達(第七章:邏輯迴歸,python實現 附原始碼)

(1)邏輯迴歸概念 1. 迴歸(Regression) 迴歸,我的理解來說,其直觀的理解就是擬合的意思。我們以線性迴歸為例子,在二維平面上有一系列紅色的點,我們想用一條直線來儘量擬合這些紅色的點,這就是線性迴歸。迴歸的本質就是我們的預測結果儘量貼近實際觀測的結果,或者說我們

邏輯迴歸模型的評估方法

從Weka工具跑回歸模型可以看到評估的輸出,怎麼解讀自行腦補過,大概明白了些。 翠花,上截圖! 我們普通人最直接的理解是正確率吧。應該對應到Correctly Classified Instances比例(正確分類了的例項)。 在上圖中,總例項數100

linear regression for classification +隨機梯度下降+多分類之logistic迴歸+多分類之線性分類投票法

將 線性迴歸 ,logistic 迴歸 用在 分類 上面 我們回顧一下上節所學習的內容。總共學習了三種線性模型(線性分類,線性迴歸,logistic 迴歸),他們的核心都是 他們三種情況分別為 那麼問題是,能否將線性迴歸,logistic

Python下的Softmax迴歸函式的實現方法

Softmax迴歸函式是用於將分類結果歸一化。但它不同於一般的按照比例歸一化的方法,它通過對數變換來進行歸一化,這樣實現了較大的值在歸一化過程中收益更多的情況。 Softmax公式 Soft

【吳恩達 機器學習】 邏輯迴歸演算法Matlab實現

一,假設函式: 1) 邏輯迴歸(Logistic Regression),Logistic function, Sigmoid function是同一個意思,函式形式(假設函式形式)如下: 邏輯迴歸是二分類演算法,hθ(x)>=0.5hθ(x)&g

Keras之DNN:基於Keras(sigmoid+linear+mse+predict)利用DNN實現迴歸預測——DIY多分類資料集&預測新資料點

Keras之DNN:基於Keras(sigmoid+linear+mse+predict)利用DNN實現迴歸預測——DIY多分類資料集&預測新資料點 輸出結果 實現程式碼 # coding:utf-8 Xa=[] Xb=[] for i in ra

梯度下降方法實現邏輯迴歸效能

Logistic Regression #三大件,%將那些用matplotlib繪製的圖顯示在頁面裡而不是彈出一個視窗 import numpy as np import pandas as pd import matplotlib.pyplot as plt %matpl

[PyTorch小試牛刀]實戰二·實現邏輯迴歸對鳶尾花進行分類

[PyTorch小試牛刀]實戰二·實現邏輯迴歸對鳶尾花進行分類 程式碼 使用均方根誤差 import numpy as np import pandas as pd import matplotlib.pyplot as plt import torch as t fr