1X1卷積的作用

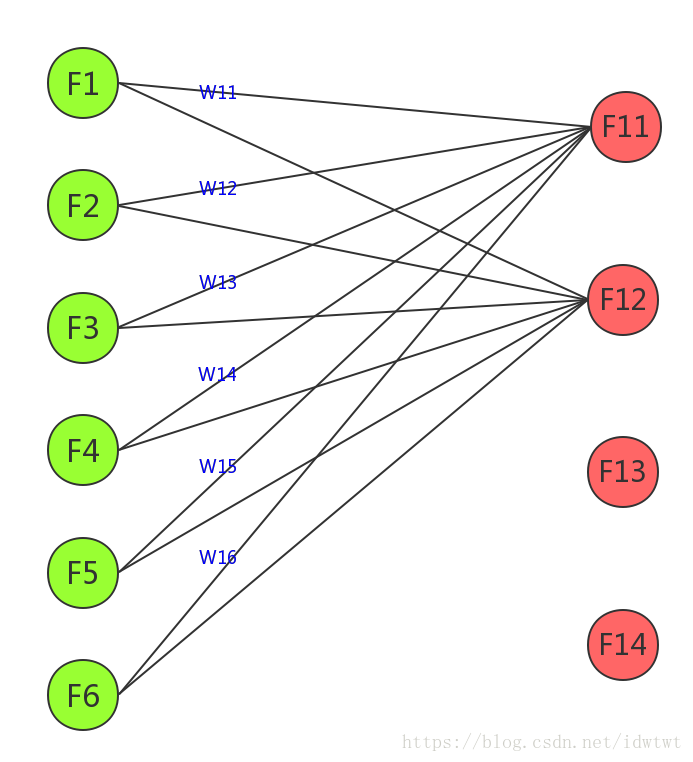

上圖原來輸入是6個feature,然後經過1x1的卷積核(實質是經過學習到的6個權重調節的線性疊加)得到一個特徵圖F11有四個1X1的卷積核,則得到4個特徵圖,分別為F11,F12,F13,F14。這樣原來的6個特徵圖,變為了4個特徵圖,實現了降維。同樣

如果卷積核大於原來的特徵圖,則實現升維。

參考:

相關推薦

CNN 中, 1X1卷積核到底有什麽作用

復雜 論文 減少 tail 單個 並行 work inception con 轉自https://blog.csdn.net/u014114990/article/details/50767786 從NIN 到Googlenet mrsa net 都是用了這個,為什麽呢 發

【深度學習】1x1卷積的作用

1x1卷積最初引起研究者的重視應該是在Network in Network這篇文章裡,後面在GoogLeNet和ResNet中都使用了1x1卷積,那麼1x1卷積到底有什麼用呢? 我認為主要作用有三點:

卷積神經網路中1x1卷積的作用

1. 來源 [1312.4400] Network In Network (如果1×1卷積核接在普通的卷積層後面,配合啟用函式,即可實現network in network的結構) 2. 應用 GoogleNet中的Inception、ResNet中的殘差模組

CNN中1X1卷積的作用

idea1 1.進行卷積核通道數的升維降維,相當於在channel方向上進行壓縮,減少引數;(計算具體見連線) 2.旨在對每個空間位置的D維向量做一個相同的線性變換,增加非線性; idea2 1.增加模型深度,一定程度上提升模型的表徵能力; 2.1*1chann

1X1卷積的作用

上圖原來輸入是6個feature,然後經過1x1的卷積核(實質是經過學習到的6個權重調節的線性疊加)得到一個特徵圖F11有四個1X1的卷積核,則得到4個特徵圖,分別為F11,F12,F13,F14。這樣原來的6個特徵圖,變為了4個特徵圖,實現了降維。同樣 如果卷積核

CNN 中, 1X1卷積核到底有什麼作用呢?

我來說說我的理解,我認為1×1的卷積大概有兩個方面的作用吧:1. 實現跨通道的互動和資訊整合2. 進行卷積核通道數的降維和升維下面詳細解釋一下:1. 這一點孫琳鈞童鞋講的很清楚。1×1的卷積層(可能)引起人們的重視是在NIN的結構中,論文中林敏師兄的想法是利用MLP代替傳統的線性卷積核,從而提高網路的表達能力

以V1中Inception Module為例說明1x1卷積核的作用

http://blog.csdn.net/u014114990/article/details/50767786 http://blog.csdn.net/u014114990/article/details/50767786

1X1卷積核到底有什麼作用

1*1的卷積核在NIN、Googlenet中被廣泛使用,但其到底有什麼作用也是一直困擾的問題,這裡總結和歸納下在網上查到的自認為很合理的一些答案,包括1)跨通道的特徵整合2)特徵通道的升維和降維 3)減少卷積核引數(簡化模型) 部分轉載自caffe.cn 作用:1. 實

1x1卷積

技術 運行 jpg 們的 inf .com 一個 關註 結構 你可能會想為什麽有人會用1x1卷積,因為它關註的不是一塊像素,而是一個像素,圖1 圖1 我們看看傳統的卷積,它基本上是運行在一個小塊圖像上的小分類器,但僅僅是個線性分類器。圖2 圖2 如果你在中間加一個1x1

1x1卷積核的理解

1x1卷積核的作用主要有兩點: 1、實現跨通道的資訊融合 2、實現通道數的升維與降維 3、增加網路的非線性 實現跨通道資訊的融合:加入當前層的特徵矩陣為224x224x100,而下一層想要得到224x224x50,這時就可以通過1x1的卷積核進行跨通道資訊融合,當然這時也

CNN: 1x1卷積層的精妙之處

現在各種神經網路都會用到1x1 conv,它到底起到什麼作用呢?要回答這個問題,先從最經典的Inception模型說起,Figure 1是Inception-ResNet-v2的block架構圖。 作用一:改變矩陣維度 block中每個sublayer的第一

卷積到底是如何操作的?1x1卷積?引數如何計算?

目錄 卷積的特性 卷積到底是如何操作的 1. 對於一個特徵圖(如灰度圖) 卷積就是對應元素乘積的求和,然後在加上一個非線性函式。 但是上面的例子只有一個輸入channel和一個卷積核,當有很多channel和多個卷積核

一文讀懂卷積神經網路中的1x1卷積核

前言 在介紹卷積神經網路中的1x1卷積之前,首先回顧卷積網路的基本概念[1]。 卷積核(convolutional kernel):可以看作對某個區域性的加權求和;它是對應區域性感知,它的原理是在觀察某個物體時我們既不能觀察每個畫素也不能一次觀察整體,而是

卷積在深度學習中的作用(轉自http://timdettmers.com/2015/03/26/convolution-deep-learning/)

範圍 SM 全連接 判斷 contact con 發展 .dsp length 卷積可能是現在深入學習中最重要的概念。卷積網絡和卷積網絡將深度學習推向了幾乎所有機器學習任務的最前沿。但是,卷積如此強大呢?它是如何工作的?在這篇博客文章中,我將解釋卷積並將其與其他概念聯系起來

1*1卷積的作用

尺度 ati 出現 卷積 表達 Dimension 通道數 不變 做的 1*1卷積的主要作用有以下幾點: 1、降維( dimension reductionality )。比如,一張500 * 500且厚度depth為100 的圖片在20個filter上做1*1的卷積,那麽

卷積神經網路之卷積計算、作用與思想

部落格:blog.shinelee.me | 部落格園 | CSDN 卷積運算與相關運算 在計算機視覺領域,卷積核、濾波器通常為較小尺寸的矩陣,比如\(3\times3\)、\(5\times5\)等,數字影象是相對較大尺寸的2維(多維)矩陣(張量),影象卷積運算與相關運算的關係如下圖所示(圖片來自連結)

[ 1 x 1 ] Convolution-1*1卷積的作用

一、卷積神經網路中的卷積(Convolution in a convoluted neural network) 具體內容親參考《深度學習》。 二、1*1卷積(one by one convolution)的作用 1*1卷積過濾器 ,它

1*1卷積核的作用

1*1卷積核的作用延伸開來說的話挺多,但是其實質是:通過N個1*1的卷積核,能夠將M張影象轉化為N張影象。 比如,某個卷積層的輸入有256個特徵圖,通過64個1*1的卷積核,輸出的特徵圖即為64個。 依次為出

第一問:1×1卷積層的作用?

1×1卷積層在實現全卷積神經網路中經常用到,即使用1*1的卷積層替換到全連線層,這樣可以不限制輸入圖片大小的尺寸,使網路更靈活。 實現跨通道的互動和資訊整合。 1×1 的卷積層(可能)引起人們的重視是在 NIN 的結構中,論文中林敏師兄的想法是利用 MLP 代替傳統的線性卷積核

使用更小卷積核的作用

使用更小的卷積核是當前在保證網路精度的情況下,減少引數的趨勢之一,在VGG16中,使用了3個3*3卷積核來代替7*7卷積核,使用了2個3*3卷積核來代替5*5卷積核,這樣做的主要目的是在保證具有相同感知野的條件下,提升了網路的深度,在一定程度上提升了神經網路的效