對GBDT的一點理解

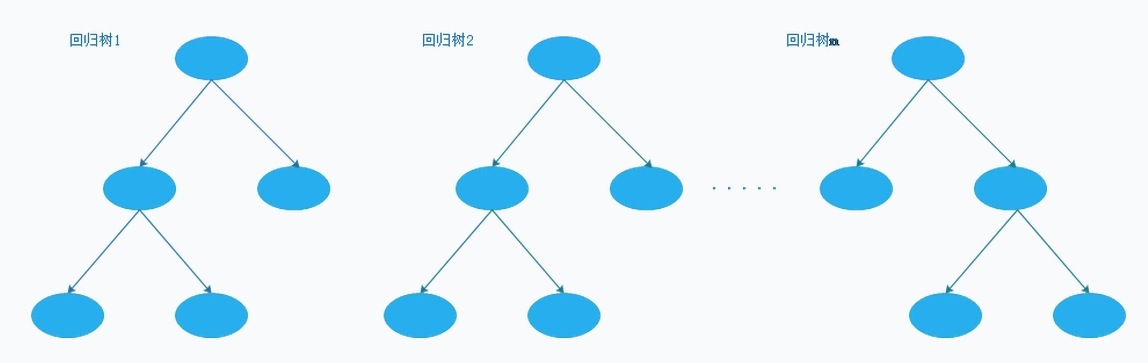

GBDT由一系列的迴歸樹組成,如下圖所示(樹的深度未必都要一樣,下圖僅為示意圖)。

GBDT原理

針對每一個類別訓練一系列的迴歸樹,再累加每個類別迴歸樹的預測值得到針對每個類別的最終的預測值。單獨拿一個類別來說,訓練的過程中假設需要預測的值為

那麼,只要引數

其中

假設第一棵迴歸樹

此時這一系列的迴歸樹

選取不同的Loss Function可以達到不同的目的,比如對於信用模型需要分類的情形,Loss Function為Deviance,對應的梯度為

GBDT的正則化

訓練的過程可以指定需要

1. early stopping策略,保留一個驗證集,每增添一棵樹通過驗