Python --深入淺出Apriori關聯分析演算法(二) Apriori關聯規則實戰

上一篇我們講了關聯分析的幾個概念,支援度,置信度,提升度。以及如何利用Apriori演算法高效地根據物品的支援度找出所有物品的頻繁項集。

- Python --深入淺出Apriori關聯分析演算法(一)

這次呢,我們會在上次的基礎上,講講如何分析物品的關聯規則得出關聯結果,以及給出用apyori這個庫執行得出關聯結果的程式碼。

一. 基礎知識

上次我們介紹了幾個關聯分析的概念,支援度,置信度,提升度。這次我們重點回顧一下置信度和提升度:

置信度(Confidence):置信度是指如果購買物品A,有較大可能購買物品B。計算方式是這樣:

置信度( A -> B) = (包含物品A和B的記錄數量) / (包含 A 的記錄數量)

舉例:我們已經知道,(牛奶,雞蛋)一起購買的次數是兩次,雞蛋的購買次數是4次。那麼置信度Confidence(牛奶->雞蛋)的計算方式是Confidence(牛奶->雞蛋)=2 / 4。

提升度(Lift):提升度指當銷售一個物品時,另一個物品銷售率會增加多少。計算方式是:

提升度( A -> B) = 置信度( A -> B) / (支援度 A)

舉例:上面我們計算了牛奶和雞蛋的置信度Confidence(牛奶->雞蛋)=2/4。牛奶的支援度Support(牛奶)=3 / 5,那麼我們就能計算牛奶和雞蛋的支援度Lift(牛奶->雞蛋)=0.83

當提升度(A->B)的值大於1的時候,說明物品A賣得越多,B也會賣得越多。而提升度等於1則意味著產品A和B之間沒有關聯。最後,提升度小於1那麼意味著購買A反而會減少B的銷量。

舉個例子,有了這個指標,你就能看出賣越多的漢堡就會賣越多的番茄醬。但賣越多的沐浴露,則可能香皂的銷量會下降。

二. 關聯規則

我們前面已經用Apriori得到頻繁項集了。那麼我們就可以在頻繁項集的基礎上,找到這裡面的關聯規則。而計算關聯規則所用到的,就是我們上面所說的置信度和提升度。

這裡有一點要注意,當我們發現置信度(A->B)很高的時候,反過來的值置信度(B->A)不一定很高。

一個物品的關聯結果是非常多的。但好在,我們上一節學習了Apriori思想。運用在置信度上也是合適的:

如果一個關聯結果的置信度低,那麼它的所有超集的置信度也低。

這樣一來,我們就能節省很多的計算量。

三. Apriori關聯規則實戰

我們還是用mlxtend庫,根據上一篇找到的頻繁項集,計算出它們的關聯規則。在此之前,還是先介紹一下相應API的引數。

association_rules(df, metric="confidence",

min_threshold=0.8,

support_only=False):

引數介紹:

- df:這個不用說,就是 Apriori 計算後的頻繁項集。

- metric:可選值['support','confidence','lift','leverage','conviction']。

裡面比較常用的就是置信度和支援度。這個引數和下面的min_threshold引數配合使用。

- min_threshold:引數型別是浮點型,根據 metric 不同可選值有不同的範圍,

metric = 'support' => 取值範圍 [0,1]

metric = 'confidence' => 取值範圍 [0,1]

metric = 'lift' => 取值範圍 [0, inf]

support_only:預設是 False。僅計算有支援度的項集,若缺失支援度則用 NaNs 填充。完整程式碼如下:

import pandas as pd

from mlxtend.preprocessing import TransactionEncoder

from mlxtend.frequent_patterns import apriori

#設定資料集

dataset = [['牛奶','洋蔥','肉豆蔻','芸豆','雞蛋','酸奶'],

['蒔蘿','洋蔥','肉豆蔻','芸豆','雞蛋','酸奶'],

['牛奶','蘋果','芸豆','雞蛋'],

['牛奶','獨角獸','玉米','芸豆','酸奶'],

['玉米','洋蔥','洋蔥','芸豆','冰淇淋','雞蛋']]

te = TransactionEncoder()

#進行 one-hot 編碼

te_ary = te.fit(records).transform(records)

df = pd.DataFrame(te_ary, columns=te.columns_)

#利用 Apriori 找出頻繁項集

freq = apriori(df, min_support=0.05, use_colnames=True)

#匯入關聯規則包

from mlxtend.frequent_patterns import association_rules

#計算關聯規則

result = association_rules(freq, metric="confidence", min_threshold=0.6)

這裡我們根據置信度來計算,找出置信度大於0.6的關聯規則。

計算結果如下:

antecedents consequents antecedent support consequent support support confidence lift leverage conviction

0 (洋蔥) (芸豆) 0.6 1.0 0.6 1.00 1.00 0.00 inf

1 (芸豆) (洋蔥) 1.0 0.6 0.6 0.60 1.00 0.00 1.000000

2 (洋蔥) (雞蛋) 0.6 0.8 0.6 1.00 1.25 0.12 inf

3 (雞蛋) (洋蔥) 0.8 0.6 0.6 0.75 1.25 0.12 1.600000

4 (芸豆) (牛奶) 1.0 0.6 0.6 0.60 1.00 0.00 1.000000

5 (牛奶) (芸豆) 0.6 1.0 0.6 1.00 1.00 0.00 inf

6 (酸奶) (芸豆) 0.6 1.0 0.6 1.00 1.00 0.00 inf

7 (芸豆) (酸奶) 1.0 0.6 0.6 0.60 1.00 0.00 1.000000

8 (芸豆) (雞蛋) 1.0 0.8 0.8 0.80 1.00 0.00 1.000000

9 (雞蛋) (芸豆) 0.8 1.0 0.8 1.00 1.00 0.00 inf

10 (洋蔥, 芸豆) (雞蛋) 0.6 0.8 0.6 1.00 1.25 0.12 inf

11 (洋蔥, 雞蛋) (芸豆) 0.6 1.0 0.6 1.00 1.00 0.00 inf

12 (雞蛋, 芸豆) (洋蔥) 0.8 0.6 0.6 0.75 1.25 0.12 1.600000

13 (洋蔥) (雞蛋, 芸豆) 0.6 0.8 0.6 1.00 1.25 0.12 inf

14 (芸豆) (洋蔥, 雞蛋) 1.0 0.6 0.6 0.60 1.00 0.00 1.000000

15 (雞蛋) (洋蔥, 芸豆) 0.8 0.6 0.6 0.75 1.25 0.12 1.600000 我們可以發現,除了置信度(confidence),提升度(lift)外,還有兩個指標,leverage和conviction。這兩個用得比較少,和置信度,提升度也有些類似,就不展開說了。

既然返回的結果是Dataframe,那麼就可以很方便得用pandas的排序方法找出置信度或提升度高的物品組合,方法如下:

DataFrame.sort_values

比如上面例子中要找出最大的置信度,用

result.sort_values(by = 'confidence',ascending=False,axis=1)

上面例子中我們可以發現,{洋蔥 -> 雞蛋,芸豆} 的置信度是 1.00 ,而它們的提升度是 1.25 。這說明買了洋蔥的人很可能會再購買 1.25 份的 {雞蛋,芸豆} 。所以可以讓它們放到一起出售。

OK,相信通過這個前面的介紹和這次的這個例子,已經能夠明白Apriori演算法的原理以及如何使用它。當然Apriori只能算是關聯挖掘演算法中比較基礎的一個,還有其他的關聯挖掘演算法,比如FP-growth,以後有機會再介紹吧。

對了,我從網上找了個關聯分析的資料和大概針對這個資料寫了個小的demo程式碼。

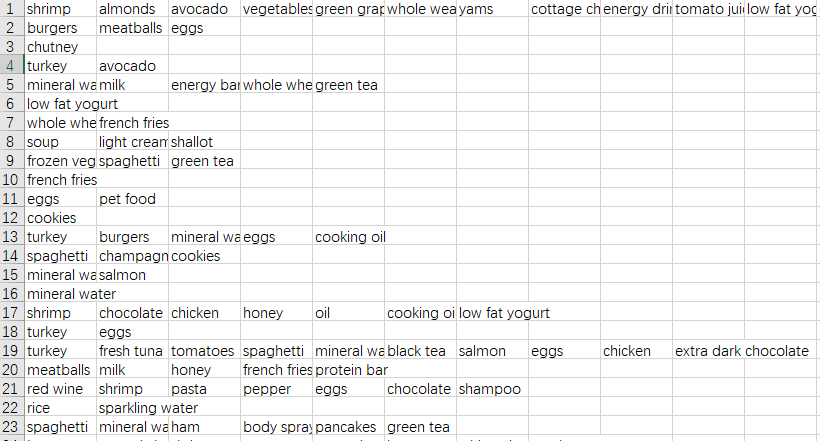

資料是超市的購物清單,大概有7500條,足夠我們來運算分析了。

我把資料和我寫的一點點demo程式碼放在我的公眾號中了,關聯公眾號:哈爾的資料城堡,回覆“apriori”(不需要雙引號),就能獲得下載連結了。

以