SVM公式推導筆記

參考資料:

對偶函數-http://blog.pluskid.org/?p=702

KTT和拉格朗日乘子-http://www.cnblogs.com/zhangchaoyang/articles/2726873.html

SVM推倒:http://blog.sina.com.cn/s/blog_4298002e010144k8.html

SVM公式推導筆記

相關推薦

SVM公式推導筆記

svm width org sin .org 參考資料 zhang www http 參考資料: 對偶函數-http://blog.pluskid.org/?p=702 KTT和拉格朗日乘子-http://www.cnblogs.com/zhangchaoyan

KCF(核化相關濾波)跟蹤公式推導筆記(1)——線性情況下濾波器的解

線上性條件下,利用迴圈矩陣,最終的解為 w^=x^∗⊙y^x^∗⊙x^+λ(1)(1)w^=x^∗⊙y^x^∗⊙x^+λ 即為論文原文的(12)式,其中: (1)x^x^即F(x)F(x),表示xx的離散傅立葉變換 (2)字母右上角的星號表示共軛

機器學習:SVM(一)——線性可分支援向量機原理與公式推導

原理 SVM基本模型是定義在特徵空間上的二分類線性分類器(可推廣為多分類),學習策略為間隔最大化,可形式化為一個求解凸二次規劃問題,也等價於正則化的合頁損失函式的最小化問題。求解演算法為序列最小最優化演算法(SMO) 當資料集線性可分時,通過硬間隔最大化,學習一個線性分類器;資料集近似線性可分時,即存在一小

【支援向量機SVM】 演算法原理 公式推導 python程式設計實現

1.前言 如圖,對於一個給定的資料集,通過直線A或直線B(多維座標系中為平面A或平面B)可以較好的將紅點與藍點分類。那麼線A與線B那個更優呢? 在SVM演算法中,我們認為線A是優於線B的。因為A的‘分類間隔’大於B。

I型支援向量機SVM距離公式推導

關於支援向量機(SVM)I型中,對任意x0x_0x0來說,為何x0x_0x0到超平面ωTX+b=0\omega^TX+b=0ωTX+b=0的距離公式中,必滿足以下式子:∣ωTx0+b∣=1|\omega^Tx_0+b|=1∣ωTx0+b∣=1,??? 其實

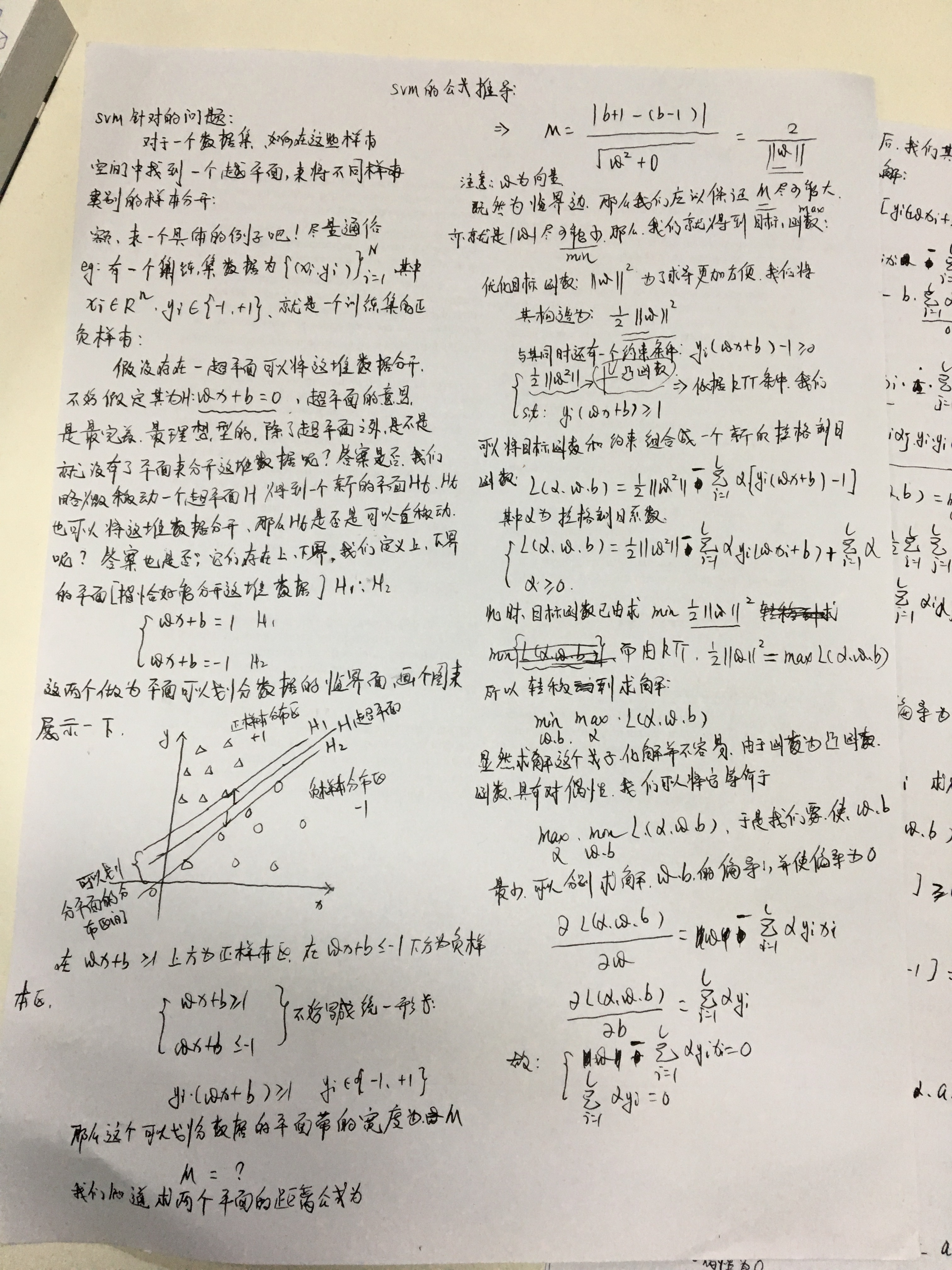

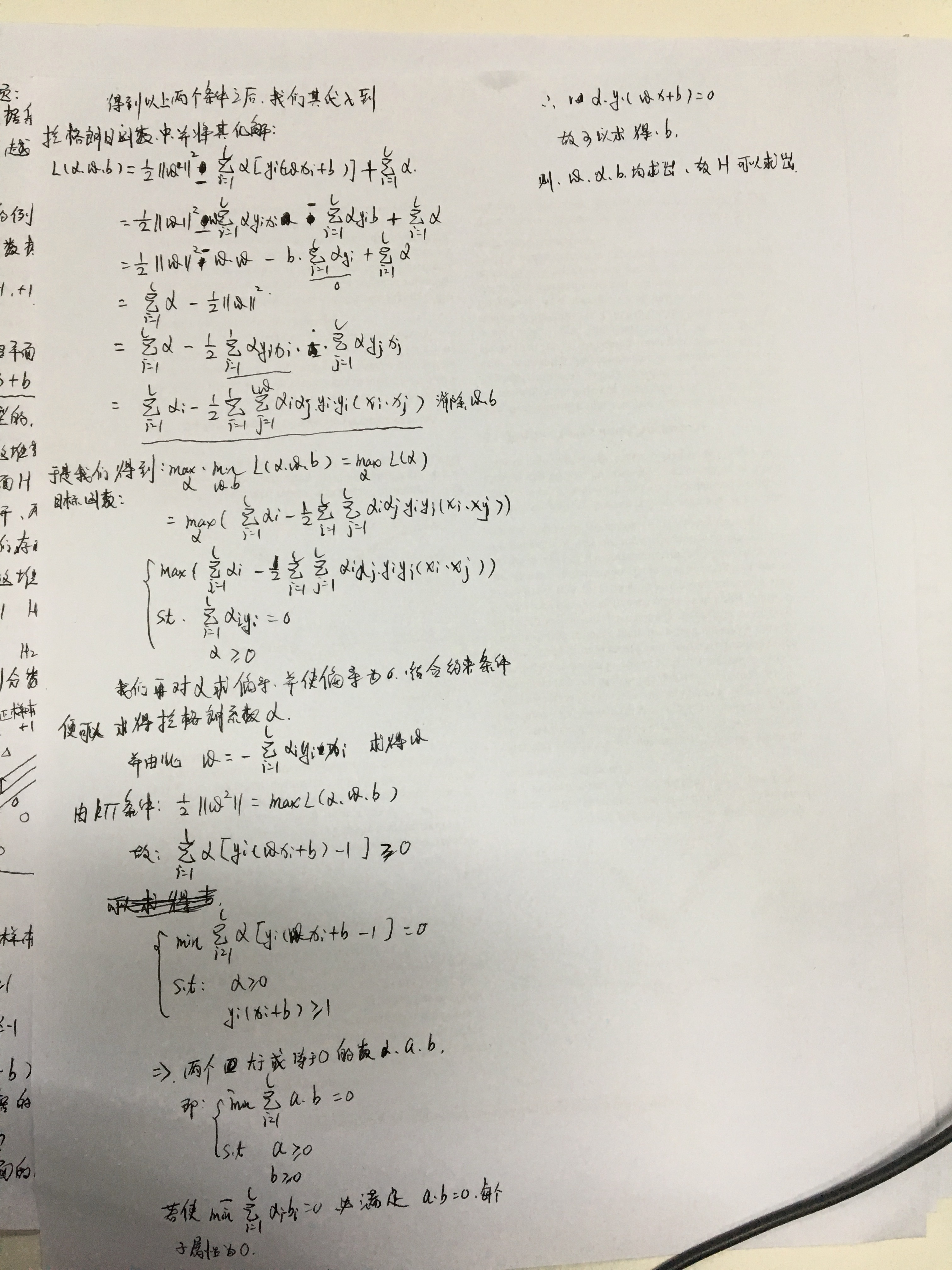

支援向量機的公式推導(Support Vector Machine,SVM)

轉:https://www.cnblogs.com/pursued-deer/p/7857306.html 1 認識向量機 支援向量機是處理資料分類問題,目的是學會一個二分類的函式模型,屬於監督式學習的方法,被廣泛應用於統計分類和迴歸分析。通過建立一個超平面對樣本資料進行分類,超平面涉及到凸

推薦演算法學習-SVM,RSVM,ASVM,SVDPP學習公式推導

下面開始介紹SVD演算法,假設存在以下user和item的資料矩陣: 這是一個極其稀疏的矩陣,這裡把這個評分矩陣記為R,其中的元素表示user對item的打分,“?”表示未知的,也就是要你去

【機器學習實戰系列】讀書筆記之AdaBoost演算法公式推導和例子講解(一)

最近在看整合演算法AdaBoost,推薦先看李航的統計學習方法第8章,然後再看機器學習實戰第7章,李航的書上的公式推導講的很詳細了,但是很多地方對於初學者來說,還是需要時間去理解和消化的。本文將從以下幾個方面來介紹AdaBoost演算法。一、AdaBoost演算法公式推導二、

CTC學習筆記(二) 訓練和公式推導

整體思路 訓練流程和傳統的神經網路類似,構建loss function,然後根據BP演算法進行訓練,不同之處在於傳統的神經網路的訓練準則是針對每幀資料,即每幀資料的訓練誤差最小,而CTC的訓練準則是基於序列(比如語音識別的一整句話)的,比如最大化p(z|x

論文筆記及公式推導 《Supervised Discrete Hashing》

轉載自http://jikaichen.com/2016/05/31/notes-on-sdh/,僅用作個人學習,如需刪除,請聯絡本人。 原論文提出了一種解離散雜湊問題的最優化方法,推出其閉式解。 筆者在閱讀該論文的過程中,理解公式推導的過程中遇到了一些問題,

二維空間點到直線垂足計算公式推導及Java實現——學習筆記

二維空間點到直線垂足計算公式推導及Java實現前言公式推導程式碼實現畫蛇添足 前言 簡單的公式推導,大概是高中程度的知識了。不管以前學的好不好,很久不用的東西,一上手還是有點懵的。推導一遍也是為了加深記憶。 公式推導 首先我們知道直線上兩點p1,p2: p1:(

SVM原理、公式推導、libsvm原始碼分析

恰好翻到了以前記的cs229的筆記, 其實也想了好久要不要跟風去推導公式, 寫寫就當是複習一下了 說到svm, 按套路就要先說說線性分類器, 如圖, 在特徵維數為2時, 可以用一條線將正負樣本分離開

POJ 2140 Herd Sums 公式推導

cpp true typedef 因數 固定 ostream highlight ring sum 題意:給出n<=1e7 求有多少個連續數之和等於k x+x+1+....x+k=n (k+1)k/2+(k+1)x=n (k+1)k+(k+1)2x=2*n (k

(CS229) 第二課 梯度下降及標準方程推導筆記

gre nag controls off and style distance splay mage 1 Locally weighted linear regression Here the w are non-nagative valued weights. 是一個c

vijos - P1543極值問題(斐波那契數列 + 公式推導 + python)

找到 span add gin python3 abi pri n) fill P1543極值問題 Accepted 標簽:[顯示標簽] 背景 小銘的數學之旅2。 描寫敘述 已知m、n為整數,且滿足下列兩個條件: ①

vijos - P1302連續自然數和 (公式推導 + python)

.net ble tags ucid stat down bsp z-index fontsize P1302連續自然數和 Accepted 標簽:[顯示標簽] 描寫敘述 對一個給定的自然數M,求出所有的連續的自然數段(連續個數大於1)

解釋一下核主成分分析(Kernel Principal Component Analysis, KPCA)的公式推導過程(轉載)

線性不可分 itl 專註 out center forest 測試 重要 原因 KPCA,中文名稱”核主成分分析“,是對PCA算法的非線性擴展,言外之意,PCA是線性的,其對於非線性數據往往顯得無能為力,例如,不同人之間的人臉圖像,肯定存在非線性關系,自己做的基於ORL數據

反向傳播算法(過程及公式推導)

不能 簡化 會有 geo 之前 代碼 求和 不同 eof 一、反向傳播的由來 在我們開始DL的研究之前,需要把ANN—人工神經元網絡以及bp算法做一個簡單解釋。關於ANN的結構,我不再多說,網上有大量的學習資料,主要就是搞清一些名詞:輸入層/輸入神經元,輸出層/輸出神經元,

機器學習之支持向量機(一):支持向量機的公式推導

根據 監督式 art 通用 利用 哪些 這就是 在線 方法 註:關於支持向量機系列文章是借鑒大神的神作,加以自己的理解寫成的;若對原作者有損請告知,我會及時處理。轉載請標明來源。 序: 我在支持向量機系列中主要講支持向量機的公式推導,第一部分講到推出拉格朗日對偶函數的對偶因

class-支持向量機SVM全析筆記

pin png 表示 倍增 arc 介紹 其他 2.3 vertica support vector machines,SVM是二類分類模型。定義在特征空間上間隔最大的線性分類器,由於包括核技巧實質上成為非線性分類器。學習策略是間隔最大化,可形式化為求解凸二次規劃問題(co