《Recursive Recurrent Nets with Attention Modeling for OCR in the Wild》 筆記

該文提出了一個基於注意力模型的遞迴迴圈神經網路模型(R2AM),解決在在無字典約束的條件下,對自然場景文字進行識別.提出的模型主要有以下幾個優點:(1)採用了迴圈的CNN網路,可以更加有效和準確地提取影象特徵;(2)在一個隱式的字元級別識別模型中嵌入一個RNN網路可以避免去使用N-元分析法;(3)採用軟注意力機制可以允許模型選擇性的利用特徵,並且執行採用標準的BP演算法進行端到端的訓練。

該文設計的基於注意力機制的迴圈神經網路模型系統可以直接的處理影象然後輸出單詞字串,極大地改善了【17】的工作。這裡主要三個貢獻:

(1)在同樣規模的引數下,RNN因為是引數共享,因此相比CNN可以更加有效地進行特徵提取。

(2 )RNNs)在上述遞迴CNN提取的影象特徵之上,以執行字元級語言模型的隱式學習。RNN可以從訓練資料中自動學習字串中自然存在的字元的連續動態特性,而無需從字典中手動定義N-gram。

(3)一個基於注意力的序列建模機制,這個機制可以在讀取字元序列時執行“軟”確定性影象特徵選擇,並且可以通過標準的BP演算法進行端對端的訓練。

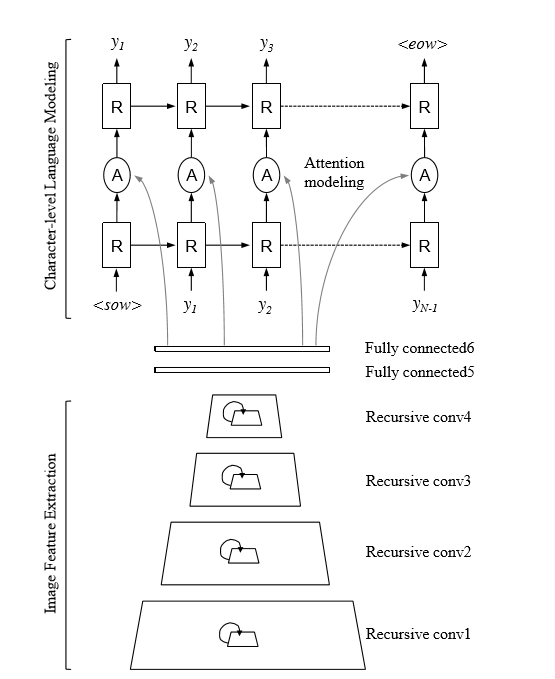

圖1:使用注意力建模(R2AM)方法的遞迴迴圈網路:模型首先通過遞迴卷積圖層傳遞輸入影象以提取編碼後的影象特徵,然後使用隱式學習的字元級語言統計資訊對迴圈神經網路進行解碼以輸出字元。 基於注意力的機制執行軟特徵選擇以獲得更好的影象特徵使用。

全文主要分析了三點:迴圈CNN進行特徵提取,採用RNN進行語言建模,採用了注意力機制

1 迴圈CNN進行特徵提前:為了獲得更好的上下文資訊,可以增加捲積核大小,或者增加網路深度,但是這種方法會導致引數增加,計算複雜度變大,因此考慮採用迴圈CNN進行特徵提取(類似RNN的權重共享),在控制引數規模的情況下,可以增加了傳統CNNs的深度,同時也比CNNs產生更加緊湊的特徵響應。

2 採用RNN進行語言建模,文中使用RNNs(recurrent neural networks)來對文字字元級統計進行建模,因為RNN在處理序列資料方面效果很好,例如機器翻譯,語音識別,手寫字識別等,這裡作者認為識別影象中的字元可以基本上被認為是解決從畫素強度到自然字元級向量的順序動態和學習對映的任務。

3 採用注意力機制模型:視覺注意力機制是人類視覺所特有的大腦訊號處理機制。人類視覺通過快速掃描全域性影象,獲得需要重點關注的目標區域,也就是一般所說的注意力焦點,而後對這一區域投入更多注意力資源,以獲取更多所需要關注目標的細節資訊,而抑制其他無用資訊。關於影象字元序列識別,

該文章提出了一個新的無詞典照片OCR框架,該框架結合了用於影象編碼的遞迴CNN,用於語言建模的RNN以及用於更好的影象特徵使用的基於注意的機制。大量分析顯示了每個提議元件的有效性,以相同的方法對約束和未受約束的場景進行了概括性,以及所提出的方法使用最新結果識別真實世界場景文字的實際能力。

【17】 M. Jaderberg, K. Simonyan, A. Vedaldi, and A. Zisserman. Deep structured output learning for unconstrained text recognition. In ICLR, 2015. 1, 2, 4, 6, 7, 8, 10