深度學習(十六)

1、學習率改變的新方法:剛開始陡升,後來慢慢下降;其中32是最大的學習率與最小的學習率之比,10代表第一個epoch升高,後面九個epoch緩緩下降

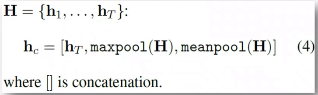

2、Concat pooling:即將啟用值,啟用值的平均池化,啟用值的最大池化連線在一起

3、注意力機制其實就是對不同的狀態進行加權,這在程式中的具體體現就是編寫了一個迷你網路,一般只有兩層線性層跟一層非線性層,通過將不同的狀態輸出得個權值的集合。這裡就體現出端到端學習的優點,我們只需要處理資料,選擇合適的結構,設定自己的損失函式就夠了,至於怎麼得到合適的權值,完全交給損失函式。

4、在高維空間中,距離的意義不是特別大,比較常用的度量標準是角度,比如餘弦相似度。

相關推薦

機器學習與深度學習系列連載: 第二部分 深度學習(十六)迴圈神經網路 4(BiDirectional RNN, Highway network, Grid-LSTM)

深度學習(十六)迴圈神經網路 4(BiDirectional RNN, Highway network, Grid-LSTM) RNN處理時間序列資料的時候,不僅可以正序,也可以正序+逆序(雙向)。下面顯示的RNN模型,不僅僅是simple RNN,可以是LSTM,或者GRU 1 B

深度學習(十六)

1、學習率改變的新方法:剛開始陡升,後來慢慢下降;其中32是最大的學習率與最小的學習率之比,10代表第一個epoch升高,後面九個epoch緩緩下降 2、Concat pooling:即將啟用值,啟用值的平均池化,啟用值的最大池化連線在一起 3、注意力機制其實就是對不同的狀態進行加權

【轉】 JMeter學習(十六)JMeter函數學習

blog 自動 當前 3.2 add 函數的調用 瀏覽器 con 保存 JMeter函數是一些能夠轉化在測試樹中取樣器或者其他配置元件的域的特殊值。一個函數的調用就像這樣:${_functionName(var1,var2,var3)},-functionName匹配函數名

Linux學習(十六)VIM

etc es2017 移動 進行 ges code inux nbsp 安裝 一、簡介 VIM是vi的增強版。VIM是Linux平臺上的主要編輯器。基本上所有的文檔的新增,修改,保存都需要用到它。所以,掌握VIM是很有必要的。 vim的安裝非常簡單,一條命令就可以了: y

Python學習(十六)內置函數,遞歸

font ID lam 效率 ascii碼 span 自帶 打印 十六 1、遞歸 def test1(): num=int(input(‘輸入數字‘)) if num%2==0: #判斷輸入數字是不是偶數 return True #是偶數

C++語言學習(十六)——多繼承

虛函數表 -o nag http layout 調用 img error names C++語言學習(十六)——多繼承 一、多繼承簡介 1、多繼承簡介 C++語言支持多繼承,一個子類可以有多個父類,子類擁有所有父類的成員變量,子類繼承所有父類的成員函數,子類對象可以當作任意

深度學習(十二)wide&deep model

結合 稀疏 正則化 深度學習 img div 網絡 傳遞 討論 推薦系統在電商等平臺使用廣泛,這裏討論wide&deep推薦模型,初始是由google推出的,主要用於app的推薦。 概念理解 Wide & Deep模型,旨在使得訓練得到的模型能夠同時獲得

GO語言學習(十六)Go 語言結構體

指針 描述 ble title 設定 import spa 輸出 sub Go 語言結構體 Go 語言中數組可以存儲同一類型的數據,但在結構體中我們可以為不同項定義不同的數據類型。 結構體是由一系列具有相同類型或不同類型的數據構成的數據集合。 結構體表示一項記錄,比如

深度學習(十一)RNN入門學習

RNN入門學習 原文地址:http://blog.csdn.net/hjimce/article/details/49095371 作者:hjimce 一、相關理論 RNN(Recurrent Neural Networks)中文名又稱之為:迴圈神經網路(原來還有一個遞迴神經網路

深度學習(十九)基於空間金字塔池化的卷積神經網路物體檢測

原文地址:http://blog.csdn.net/hjimce/article/details/50187655 作者:hjimce 一、相關理論 本篇博文主要講解大神何凱明2014年的paper:《Spatial Pyramid Pooling in Dee

吳恩達機器學習(十六)機器學習流水線、上限分析

目錄 0. 前言 1. 流水線 2. 上限分析(Ceiling analysis) 學習完吳恩達老師機器學習課程的照片OCR,簡單的做個筆記。文中部分描述屬於個人消化後的理解,僅供參考。 如果這篇文章對你有一點小小的幫助,請給個關注

JMeter學習(十六)JMeter函式學習

JMeter函式是一些能夠轉化在測試樹中取樣器或者其他配置元件的域的特殊值。一個函式的呼叫就像這樣:${_functionName(var1,var2,var3)},-functionName匹配函式名,圓括號內設定函式的引數,例如${_time(YMD)}實際引數因函式而不同。不需要引數的函式使圓

PE檔案格式學習(十六):延遲載入表

1.介紹 延遲載入表本質上跟繫結匯入表的目的是一樣的,都是為了加快程式載入檔案的速度,只不過方法不一樣。 延遲載入是指在呼叫某個DLL時才去載入,目的是為了避免在程式啟動之初就載入了不必要的DLL而浪費了時間。微軟建議在兩種情況下使用延遲載入: 程式並非在啟動時就會呼叫D

機器學習與深度學習系列連載: 第二部分 深度學習(十五)迴圈神經網路 3(Gated RNN - GRU)

迴圈神經網路 3(Gated RNN - GRU) LSTM 是1997年就提出來的模型,為了簡化LSTM的複雜度,在2014年 Cho et al. 提出了 Gated Recurrent Units (GRU)。接下來,我們在LSTM的基礎上,介紹一下GRU。 主要思路是: •

機器學習與深度學習系列連載: 第二部分 深度學習(十四)迴圈神經網路 2(Gated RNN - LSTM )

迴圈神經網路 2(Gated RNN - LSTM ) simple RNN 具有梯度消失或者梯度爆炸的特點,所以,在實際應用中,帶有門限的RNN模型變種(Gated RNN)起著至關重要的作用,下面我們來進行介紹: LSTM (Long Short-term Memory )

機器學習與深度學習系列連載: 第二部分 深度學習(十二)卷積神經網路 3 經典的模型(LeNet-5,AlexNet ,VGGNet,GoogLeNet,ResNet)

卷積神經網路 3 經典的模型 經典的卷積神經網路模型是我們學習CNN的利器,不光是學習原理、架構、而且經典模型的超引數、引數,都是我們做遷移學習最好的源材料之一。 1. LeNet-5 [LeCun et al., 1998] 我們還是從CNN之父,LeCun大神在98年提出的模

機器學習與深度學習系列連載: 第二部分 深度學習(十一)卷積神經網路 2 Why CNN for Image?

卷積神經網路 2 Why CNN 為什麼處理圖片要用CNN? 原因是: 一個神經元無法看到整張圖片 能夠聯絡到小的區域,並且引數更少 圖片壓縮畫素不改變圖片內容 1. CNN 的特點 卷積: 一些卷積核遠遠小於圖片大小; 同樣的pat

機器學習 (十六)電商O2O優惠券使用預測-2

介紹 這篇文章是想繼續總結一遍優惠券預測,寫寫感受並進行一個記錄總結,零零散散以作為記錄整理之用。 本篇是選了三點本人覺得專案中重要的寫了一下,其它內容暫時略過 第一部分:資料清洗資料分析程式碼

深度學習(十七)

1、在殘差網路中利用1*1進行降維,即設計一個瓶頸層來使得網路更深可能不是一個好主意,網路的通道更多即網路更寬一些在實驗中可能更能利用GPU的運算資源。 2、一個訓練的技巧,當使用較小的學習率時使用較大的動量,使用較大的學習率時使用較小的動量,兩者的關係如圖所示: 3、如果損失函式的表

深度學習(十一)

寫在前面的話:此部分是關於fastai的學習部分 1、學習率的調整是訓練模型的一個重要的方面,可以設定隨迭代次數增長的學習率,畫出影象,再畫出學習率與損失函式的關係,通過損失函式確定合適的學習率,如下圖: 需要注意的是,一般不將學習率設定到損失函式的最低點,而是要比那個學習率稍小