spark叢集使用hanlp進行分散式分詞操作

阿新 • • 發佈:2018-12-16

分兩步:

第一步:實現hankcs.hanlp/corpus.io.IIOAdapter

public class HadoopFileIoAdapter implements IIOAdapter { @Override public InputStream open(String path) throws IOException { Configuration conf = new Configuration(); FileSystem fs = FileSystem.get(URI.create(path), conf); return fs.open(new Path(path)); } @Override public OutputStream create(String path) throws IOException { Configuration conf = new Configuration(); FileSystem fs = FileSystem.get(URI.create(path), conf); OutputStream out = fs.create(new Path(path)); return out; } }

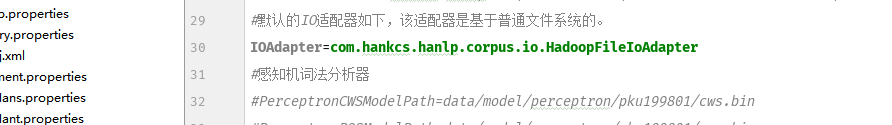

第二步:修改配置檔案。root為hdfs上的資料包,把IOAdapter改為咱們上面實現的類

b

ok,這樣你就能在分散式叢集上使用hanlp進行分詞了。

希望能幫到需要的朋友。。