4.TensorFlow代價函式

一、二次代價函式、交叉熵代價函式、對數似然代價函式

(一)二次代價函式

相當於把誤差求平方累加再除以樣本總數,求平均

(二)交叉熵代價函式

(三)對數似然代價函式

啟用函式:見博文

早期研究神經網路主要採用sigmoid函式或者tanh函式,輸出有界,很容易充當下一層的輸入。 近些年Relu函式及其改進型(如Leaky-ReLU、P-ReLU、R-ReLU等)在多層神經網路中應用比較

見本總結教程另一片博文

二、擬合 欠擬合、正擬合、過擬合

解決過擬合的方法 ①增加資料集

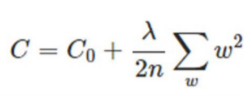

②正則化方法

③Dropout

訓練的時候只用部分神經元來進行訓練

③Dropout

訓練的時候只用部分神經元來進行訓練

三、優化器 SGD、Momentum、NAG、Adagrad、Adadelta、Rmsprop

相關推薦

4.TensorFlow代價函式

一、二次代價函式、交叉熵代價函式、對數似然代價函式 (一)二次代價函式 相當於把誤差求平方累加再除以樣本總數,求平均 (二)交叉熵代價函式 (三)對數似然代價函式 啟用函式:見博文 早期研究神經網路主要採用sigmoid函式或者tanh函式,輸

TensorFlow筆記(4)——優化手寫數字識別模型之代價函式和擬合

前言 上篇筆記我們利用MNIST資料集訓練了一個手寫數字識別的模型,但是準確率非常的低,維持在91%左右,我們可以嘗試著將準確率提高到96%以上,在實驗之前我們需要先了解一些基本的概念,本篇文章可能會有些枯燥,因為大多都是理論知識。 本文重點 啟用函式 代價函式 擬合 什麼是啟用函式

玩玩機器學習4——TensorFlow基礎之啟用函式

啟用函式(activation function)執行時啟用神經網路中某一部分神經元,將啟用資訊向後傳入下一層的神經網路。神經網路之所以能解決非線性問題(如語音、影象識別),本質上就是啟用函式加入了非線性因素,彌補了線性模型的表達力,把“啟用的神經元的特徵”通過

tensorflow實戰:MNIST手寫數字識別的優化2-代價函式優化,準確率98%

最簡單的tensorflow的手寫識別模型,這一節我們將會介紹其簡單的優化模型。我們會從代價函式,多層感知器,防止過擬合,以及優化器的等幾個方面來介紹優化過程。 1.代價函式的優化: 我們可以這樣將代價函式理解為真實值與預測值的差距,我們神經

深度學習框架tensorflow學習與應用5(softmax函式+交叉熵代價函式和二次代價函式的比較)

import tensorflow as tf from tensorflow.examples.tutorials.mnist import input_data # In[3]: #載入資料集 mnist = input_data.read_data_sets("MNIST_data",o

深度學習框架TensorFlow學習與應用(三)——使用交叉熵作為代價函式

二次代價函式(quadratic cost): 其中,C表示代價函式,x表示樣本,y表示實際值,a表示輸出值,n表示樣本的總數。 例如: 假如我們使用梯度下降法(Gradient descent)來調整權值引數的大小,權值w和偏置b的梯

VS2017 + CUDA 9.2 + CUDNN 7.1.4 + tensorflow 安裝

h5py with floating blank col 進行 ima inf height 參照步驟:https://blog.csdn.net/weixin_42359147/article/details/80622306 坑:安裝完成後 import tensor

機器學習基礎(六)—— 交叉熵代價函式(cross-entropy error)

分享一下我老師大神的人工智慧教程!零基礎,通俗易懂!http://blog.csdn.net/jiangjunshow 也歡迎大家轉載本篇文章。分享知識,造福人民,實現我們中華民族偉大復興!

Week One - 5. 代價函式

Square Error Function 線上性迴歸中,如何選擇引數以達到最好的效果呢?或者說我們如果定義最好呢?基本想法是讓擬合的直線儘量靠近已知的資料點。 具體一點就是: 這裡cost fu

tensorflow常用函式之tf.nn.softmax

關於softmax的詳細說明,請看Softmax。 通過Softmax迴歸,將logistic的預測二分類的概率的問題推廣到了n分類的概率的問題。通過公式 可以看出當月分類的個數變為2時,Softmax迴歸又退化為logistic迴歸問題。

線性迴歸——代價函式

Training Set 訓練集 Size in feet2(x) Price in 1000's(y) 2104 460 1416 232 1534 315

keras concatenate()函式和tensorflow concat()函式

最近看影象語義分割的相關論文,裡面需要用到層間的合併,例子大多是用keras給出的,以前沒接觸過層合併的函式,特意去查了下tf和keras分別用什麼函式實現的。keras.backend.concatenate 與 tf.concat等價。keras的concatenate直接用的網上的

Tensorflow 損失函式及學習率的四種改變形式

Reference: https://blog.csdn.net/marsjhao/article/details/72630147 分類問題損失函式-交叉熵(crossentropy) 交叉熵描述的是兩個概率分佈之間的距離,分類中廣泛使用的損失函式

4-4 R語言函式 tapply

#對向量的子集進行操作 #tapply(引數):tapply(向量,因子/因子列表,函式/函式名) > x <- c(rnorm(5),runif(5),rnorm(5,1)) > f <- gl(3,5) > f [1] 1 1 1 1 1 2 2 2 2 2 3 3 3

tensorflow常用函式筆記

1. tf.Session() 與 tf.InteractiveSession() 用tf.Seesino()構建會話,要定義好所有的operation之後,才能構建會話 用tf.InteractiveSession()構建會話,可以先構建一個會話再定義operation,適用於互動式環

交叉熵代價函式(cross-entropy cost function)

1.從方差代價函式說起 代價函式經常用方差代價函式(即採用均方誤差MSE),比如對於一個神經元(單輸入單輸出,sigmoid函式),定義其代價函式為: 其中y是我們期望的輸出,a為神經元的實際輸出【 a=σ(z), where z=wx+b 】。 在訓練神經網路過程中,我

tensorflow batch函式實現

def get_batch(image, label, image_W, image_H, batch_size, capacity): image = tf.cast(image, tf.string) label = tf.cast(label, tf.int32)

深度學習基礎--loss與啟用函式--sigmiod與softmax;對數損失函式與交叉熵代價函式

sigmiod與softmax sigmiod就是邏輯迴歸(解決二分類問題);softmax是多分類問題的邏輯迴歸 雖然邏輯迴歸能夠用於分類,不過其本質還是線性迴歸。它僅線上性迴歸的基礎上,在特徵到結果的對映中加入了一層sigmoid函式(非線性)對映,即先把特徵線性求和,然後使

吳恩達深度學習筆記(7)--邏輯迴歸的代價函式(Cost Function)

邏輯迴歸的代價函式(Logistic Regression Cost Function) 在上一篇文章中,我們講了邏輯迴歸模型,這裡,我們講邏輯迴歸的代價函式(也翻譯作成本函式)。 吳恩達讓我轉達大家:這一篇有很多公式,做好準備,睜大眼睛!代價函式很重要! 為什麼需要代價函式: 為

C語言第4課——從函式返回陣列

C 語言不允許返回一個完整的陣列作為函式的引數。但是,可以通過指定不帶索引的陣列名來返回一個指向陣列的指標。 如果想要從函式返回一個一維陣列,必須宣告一個返回指標的函式,如下: int * myFunction() { . . . } 另外,C 不支援在函式外返回區域性變數的地址,除