GloVe: Global Vectors for Word Representation

學習詞的向量空間表示可以很好捕獲語法和語義規則資訊,但是這些規則的起源並不透明。我們分析和闡明模型需要的這些規則。這是logbilinear regression模型,集合了全域性矩陣分解和本地視窗大小的方法。模型訓練在詞和詞的共現矩陣中,而不是整個語料庫的稀疏矩陣。

1 Introduction

語言的語義向量空間模型把每個詞表示為一個數值向量,這些向量是特徵,可以使用在資訊檢索,文件分類,問答,命名實體識別和語法分析。

大部分詞向量依賴於詞向量對的距離和角度來估計這些向量的質量。最近的估計方法是詞的相似度,而且還有不同維度的不同。比如king-queen=man-woman。

學習詞向量有兩大方法:1)全域性矩陣分解方法,比如LSA,2)本地文字視窗,比如skip-gram模型。這些方法都有缺點,LSA可以很好獲得統計資訊,但對於詞的相似度任務比較差,skip-gram對於相似度任務很好,但對於使用語料的統計資訊比較差,這是因為他們訓練在區域性上下文視窗而不是全域性共現對。

2 Related Work

Matrix Factorization Methods.

矩陣分解的方法可以追溯到LSA,這些方法使用低秩的矩陣分解大的矩陣,在LSA,矩陣是‘term-document’,比如行是詞,列是不同的文件。

Shallow Window-Based Methods.

另一個方法是在區域性上下文視窗內進行預測,比如CBOW和skip-gram模型。

不像矩陣分解方法,基於視窗的模型無法使用語料的共現資訊。

3 The GloVe Model

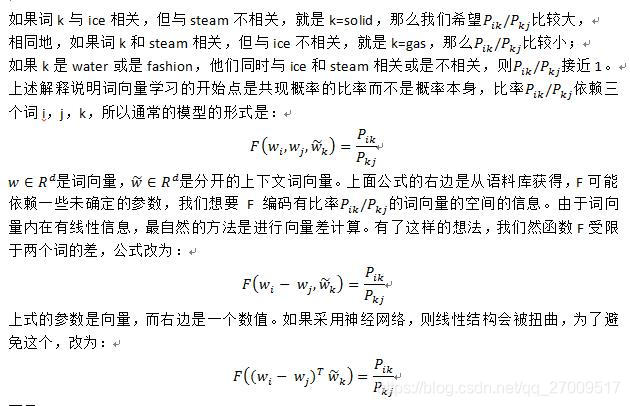

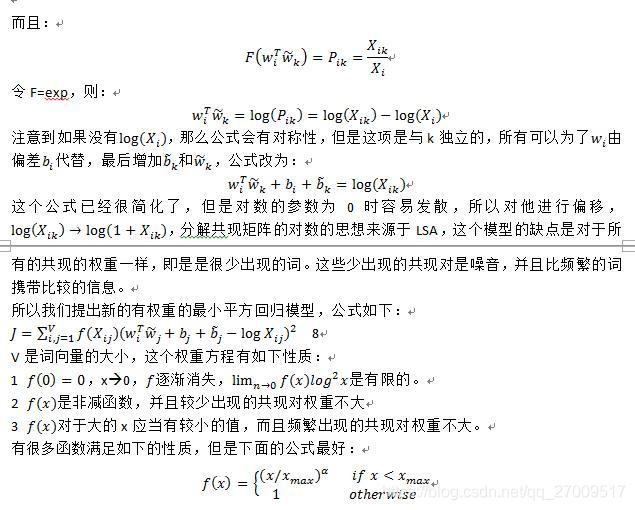

語料庫中共現詞的資訊可以由非監督學習方法獲得,但現在已有這些方法了,但是語義如何從這些統計資訊獲得還是問題。我們的模型叫GloVe(global vector),因為整個語料的統計資訊由模型直接獲得。

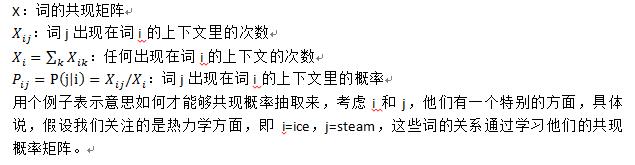

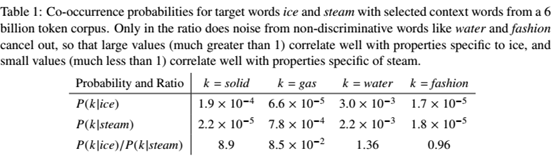

首先定義一些概念。

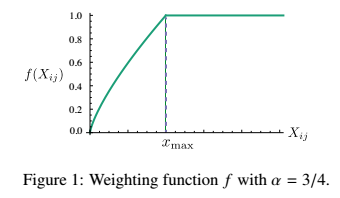

模型的效能對於臨界值的依賴很少,所以把xmax=100 ,並且α=3/4 比α=1 好

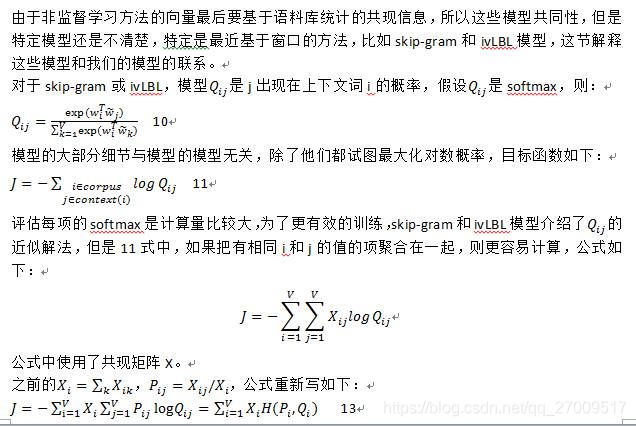

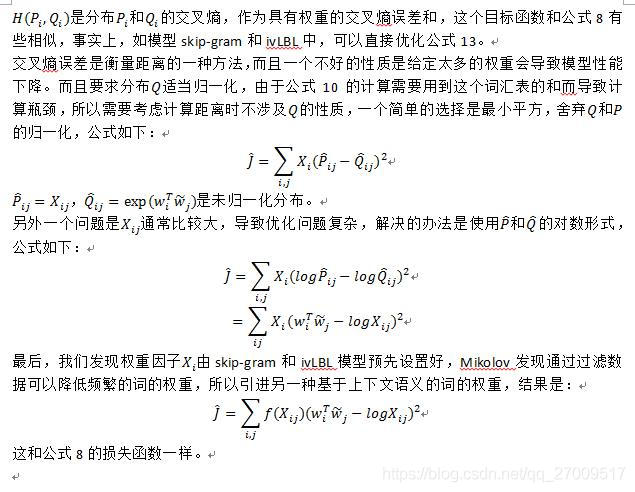

3.1 Relationship to Other Models

3.2 Complexity of the model

4 Experiments

4.1 Evaluation methods

Word analogies

Word similarity

Named entity recognition

4.2 Corpora and training details

4.3 Results

4.4 Model Analysis: Vector Length and Context Size

4.5 Model Analysis: Corpus Size

4.6 Model Analysis: Run-time

4.7 Model Analysis: Comparison with word2vec

5 Conclusion