RNN、GRU、LSTM

版權宣告:本文為博主原創文章,未經博主允許不得轉載。 https://blog.csdn.net/weixin_42432468

學習心得:

1、每週的視訊課程看一到兩遍

2、做筆記

3、做每週的作業練習,這個裡面的含金量非常高。掌握後一定要自己敲一遍,這樣以後用起來才能得心應手。

對RNN 、Simplified GRU、Full GRU、LSTM單元的理解:

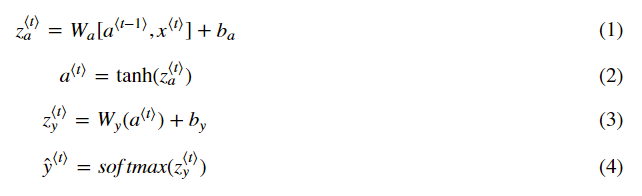

1、RNN Unit

2、Simplified GRU

3、Full GRU

4、LSTM

相關推薦

RNN、GRU、LSTM

版權宣告:本文為博主原創文章,未經博主允許不得轉載。 https://blog.csdn.net/weixin_42432468 學習心得: 1、每週的視訊課程看一到兩遍 2、做筆記 3、做每週的作業練習,這個裡面的含金量非常高。掌握後一定要自己敲一遍,這樣以後用起來才能得心應手。

DL課程:RNN、LSTM、GRU及相關應用案例程式碼

以下是我的學習筆記,以及總結,如有錯誤之處請不吝賜教。 前面學習了CNN卷積神經網路,本文主要介紹RNN迴圈神經網路及相關升級版。 RNN迴圈神經網路: RNN(Recurrent Neural Network)是一類用於處理序列資料的神經網路。簡單來看,把序列按時間展開結構如下:

深度學習:迴圈神經網路(RNN)的變體LSTM、GRU

訪問請移步至,這裡有能“擊穿”平行宇宙的亂序並行位元組流… 假設我們試著去預測“I grew up in France… I speak fluent French”最後的詞French。當前的資訊建議下一個詞可能是一種語言的名字,但是如果我們需要弄清楚是什麼

RNN、LSTM、Seq2Seq、Attention、Teacher forcing、Skip thought模型總結

RNN RNN的發源: 單層的神經網路(只有一個細胞,f(wx+b),只有輸入,沒有輸出和hidden state) 多個神經細胞(增加細胞個數和hidden state,hidden是f(wx+b),但是依然沒有輸出) 這裡RNN同時和當前的輸入有關係,並且是上一層的輸出有關係。 初步

推薦系統與LSTM、GRU

最近在看深度學習與神經系統方面的文章,發現深度學習對推薦系統有很大的影響,特此進行下總結,為自己接下來的閱讀總結做參考。如今,深度學習技術應用到推薦系統的主要分為以下5類:1、自編碼器AE:通過一個編碼和一個解碼過程來重構輸入資料,學習資料的隱層表示。多用於:評分預測、文字推

機器學習(ML)九之GRU、LSTM、深度神經網路、雙向迴圈神經網路

門控迴圈單元(GRU) 迴圈神經網路中的梯度計算方法。當時間步數較大或者時間步較小時,迴圈神經網路的梯度較容易出現衰減或爆炸。雖然裁剪梯度可以應對梯度爆炸,但無法解決梯度衰減的問題。通常由於這個原因,迴圈神經網路在實際中較難捕捉時間序列中時間步距離較大的依賴關係。 門控迴圈神經網路(gated recurre

學習筆記CB012: LSTM 簡單實現、完整實現、torch、小說訓練word2vec lstm機器人

AS csdn 梯度下降 values 定義 方便 cto course sed 真正掌握一種算法,最實際的方法,完全手寫出來。 LSTM(Long Short Tem Memory)特殊遞歸神經網絡,神經元保存歷史記憶,解決自然語言處理統計方法只能考慮最近n個詞語而忽略更

Tensorflow: MNIST資料集實現DNN、CNN、LSTM神經網路

最近學了一下tensorflow的基本用法,這裡做一下總結 全連線深度神經網路(FC-DNN) 全連線深度神經網路,每一層的神經元直接都是全連線,並且不共享權值。在普通的分類的問題中表現的不錯,但是對於圖片處理等具有網格形式的資料,最好採用CNN(卷積神經網路),對於序列化資料如NL

長短期記憶(LSTM)系列_3.1~3.3、第一個LSTM小例子:Keras中長短期記憶模型的5個核心步驟(python)

本文是演示了一個最簡單的LSTM模型的構建,以0.1~0.9序列為例,做了一個預測的小例項,文章最後我新增了一個測試集,重新使用訓練的模型進行一次預測,詳細程式碼以及註釋見文末。 後續的3.2和3.3課程是一組課程的學習目錄,以及作者自己新書的推薦,3.2章節會在後續學習中更新

完全圖解RNN、RNN變體、Seq2Seq、Attention機制

完全圖解RNN、RNN變體、Seq2Seq、Attention 機制 本文首發於知乎專欄“ai insight”! 本文主要是利用圖片的形式,詳細地介紹了經典的RNN、RNN幾個重要變體,以及Seq2Seq模型、Attention機制。 希望這篇文章能夠提供一個全

Tensorflow Ubuntu16.04上安裝及CPU執行Tensorboard、CNN、RNN圖文教程

Tensorflow Ubuntu16.04上安裝及CPU執行tensorboard、CNN、RNN圖文教程 Ubuntu16.04系統安裝 Win7 U盤安裝Ubuntu16.04 雙系統詳細教程參看部落格:http://blog.csdn.net/coderjyf/article/det

一文讀懂 CNN、DNN、RNN 內部網路結構區別

從廣義上來說,NN(或是更美的DNN)確實可以認為包含了CNN、RNN這些具體的變種形式。在實際應用中,所謂的深度神經網路DNN,往往融合了多種已知的結構,包括卷積層或是LSTM單元。但是就題主的意思來看,這裡的DNN應該特指全連線的神經元結構,並不包含卷積單元或是時間上的關聯。 因此,題主一定要將D

RNN隱藏層的兩種計算方法GRU和LSTM

本篇文章主要介紹兩種RNN的隱藏層資訊計算方法GRU(Gated Recurrent Units)和LSTM(Long-Short-Term-Memories),這兩種隱藏層的計算方法通過引入門(Gate) 的機制來解決RNN的梯度消失問題,從而學習到長距離依賴。這裡說的隱藏

RNN啟用函式、Encoder-Decoder、Seq2Seq、Attention

RNN中為什麼使用使用tanh啟用,不用sigmoid、Relu Sigmoid函式的導數範圍是(0,0.25], Tanh函式的導數是(0,1]。 由於RNN中會執行很多累乘,小於1的小數累乘會導致梯度越來越接近於0,出現梯度消失現象。 Tanh與Sigmoi

自己動手實現深度學習框架-7 RNN層--GRU, LSTM

# 目標 這個階段會給cute-dl新增迴圈層,使之能夠支援RNN--迴圈神經網路. 具體目標包括: 1. 新增啟用函式sigmoid, tanh. 2. 新增GRU(Gate Recurrent Unit)實現. 3. 新增LSTM(Long Shor

HMM、CTC、RNN-T訓練是所有alignment的尋找方法

## 1.1 LAS產生label的計算

(最短路徑算法整理)dijkstra、floyd、bellman-ford、spfa算法模板的整理與介紹

void empty borde fast 默認 grand else 理解 scan 這一篇博客以一些OJ上的題目為載體。整理一下最短路徑算法。會陸續的更新。。。 一、多源最短路算法——floyd算法 floyd算法主要用於求隨意兩點間的最短路徑。也成

sql 實現用戶名、郵箱、手機號登錄

append nes class select logs lec email mobile () StringBuilder strSql = new StringBuilder(); strSql.Append("se

8.1 加減日、月、年

加減 val nth ear edate tno minus date bsp select hiredate - interval 5 day as hd_minus_5D, hiredate + interval 5 day as hd_

[HTML]表單控件、iframe、datails、meter、time、fieldset、mark

單選 spa 多行 普通 -html tag sel legend doctype 一、表單元素 1.input:空標記 屬性: type:文本框、密碼框、單選按鈕、復選框 value:當前表單元素的值,可以是提交給服務器的值,也可以是默認顯示的初始值 name:名稱,要提