斯坦福《機器學習》Lesson6感想———1、函式間隔和幾何間隔

這一課主要是從如何判斷一個機器學習分類演算法裡擬合的引數是最佳引數引出函式間隔和幾何間隔的定義。

1、函式間隔

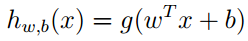

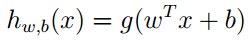

假設假想函式

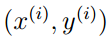

給定某一個數據案例

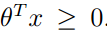

因此可知,如果要得到一個值儘可能大的函式間隔,在

當函式間隔大的時候,演算法選擇的引數能更好的模擬資料的現實能對測試資料集做出更好的推測。

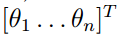

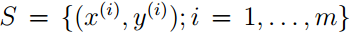

在給定的整個訓練資料集

2、幾何間隔

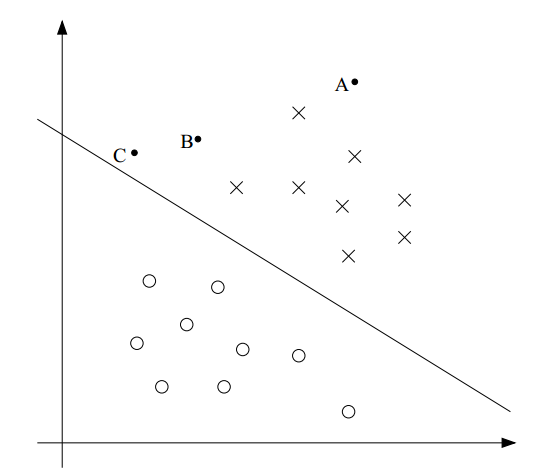

圖1

假設假想函式

可知資料點裡決策邊界越遠,其最後的預測結果就越可信。圖1中的A點離決策邊界最遠,說明可以非常確定的認為它屬於y=1;而c點最靠近決策邊界,只要稍微改變下決策邊界就可以判斷其屬於y=0。因此,可知分隔超平面(決策邊界)的選擇取決於離分隔超平面最近的點與分隔超平面之間的間隔,這間隔就是幾何間隔,支援向量就是離分隔超平面最近的點。幾何間隔越大,說明分類器越可信。

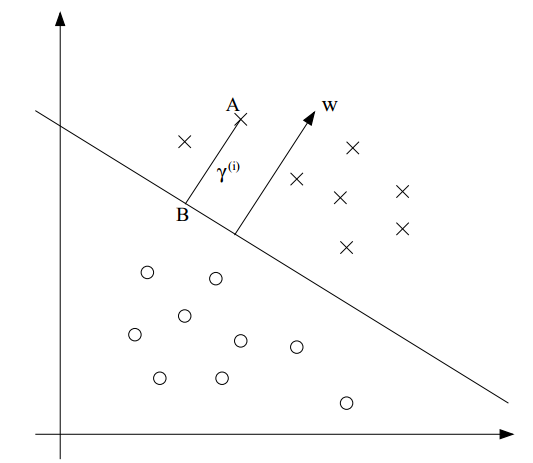

圖2

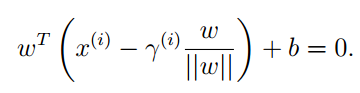

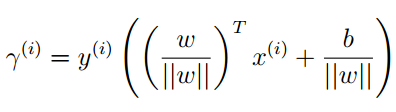

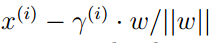

按圖2可定義幾何間隔,已知A為

所以求解可得:

這個求解的只是y=1的情況,所以綜合y=-1的情況可定義A點的幾何間隔為:

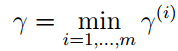

在給定的整個訓練資料集

3、函式間隔和幾何間隔的關係

函式間隔/||w|| =幾何間隔

函式間隔會隨著w和b的縮放而縮放,但是對於演算法的引數選取沒有意義。幾何間隔不會隨著w和b的縮放而縮放。