神經網路1.3-感知器收斂定理

1.為了誤差修正學習演算法,我們對感知器的模型略作修改:偏置b(n)被當作一個等於1的固定輸入量所驅動的突觸權值。因此我們得到(m+1)×1的輸入向量

這裡n表示使用演算法時的迭代步數。

相應的定義(m+1)×1的權值向量:

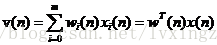

因此,線性組合器的輸出(誘導區域性域)可以寫成緊湊的形式:

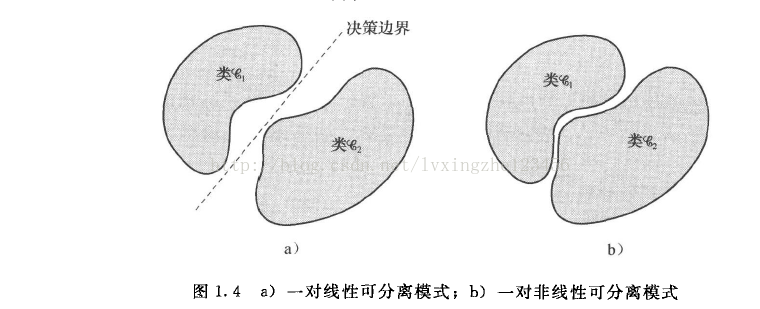

兩個輸入類之間的決策平面為

2.感知器工作條件。

為了使感知器能夠正確工作,

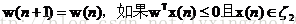

2.感知器權值自適應演算法。

1)設訓練集合的第n個成員

相關推薦

神經網路1.3-感知器收斂定理

1.為了誤差修正學習演算法,我們對感知器的模型略作修改:偏置b(n)被當作一個等於1的固定輸入量所驅動的突觸權值。因此我們得到(m+1)×1的輸入向量 , 這裡n表示使用演算法時的迭代步數。 相應的定義(m+1)×1的權值向量: 。 因此,線性組合器的輸出(誘導區域性域)可

神經網路學習(一)——感知器分類演算法

最近,學習了一下神經網路的相關知識。寫一篇部落格,做思路整理。 神經網路包含input layer、hidden layer、output layer三層。(考慮真實神經原傳輸訊號的過程) 感知器分類演算法只適用於可以線性分割的資料!!!!! 相關概念: 訓練樣本X

神經網路之:感知器

在神經網路中,我們主要使用的是一種稱為S型神經元的神經元模型。感知器就是我們所謂的“人工神經元”。那麼感知器怎麼工作的呢,接下來我們來談談。 1.感知器工作機制: 上圖中有x1,x2和x3輸入,一般情況下我們可以引入權重w1,w2和w3來表示輸入對輸出的重要性,這時可以計算

神經網路基礎和感知器

神經元的變換函式 從淨輸入到輸出的變換函式稱為神經元的變換函式,即 閾值型變換函式比如符號函式 非線性變換函式比如單極性Sigmoid函式 又比如雙極性S型(又曲正切)函式 分段性變換函式比如 概率

神經網路/多層感知器(MLP)架構:選擇隱藏層數量和大小的標準

隱藏層個數: 一個零隱藏層的模型可以解決線性可分資料。所以除非你早知道你的資料線性不可分,證明它也沒什麼壞處—為什麼使用比任務需求更困難的模型?如果它是線性可分的那麼一個更簡單的技術可以工作,感知器也可以。 假設您的資料確實需要通過非線性技術進行分離,則始終

【Python-ML】神經網路-多層感知器增加梯度檢驗

# -*- coding: utf-8 -*- ''' Created on 2018年1月26日 @author: Jason.F @summary: 多層感知器實現,加梯度檢驗 訓練集:http://yann.lecun.com/exdb/mnist/ train-im

神經網路學習筆記(六):感知機收斂定理

先對與操作進行討論,與(AND)操作需要將(0,0)(0,1)(1,0,)(1,1)進行二分類,結果輸出0或者1,顯然前三個點對應輸出為0的類,最後一個點對應輸出為1的類,這四個點在二維平面上一畫很容易看出,有無數條線可以將其分類。故是線性可分的類,同理可證或,非邏輯操作。

# [cs231n (七)神經網路 part 3 : 學習和評估 ][1]

標籤(空格分隔): 神經網路 0.回顧 cs231n (一)影象分類識別講了KNN cs231n (二)講了線性分類器:SVM和SoftMax cs231n (三)優化問題及方法 cs231n (四)反向傳播 cs231n (五)神經網路 part 1:

【程式碼閱讀記錄】Spiking-Neural-Network---Genre-Recognizer(脈衝神經網路的風格識別器)(1)

前言: { 之前從工作中瞭解到了脈衝神經網路(Spiking Neural Network,SNN)。SNN在1952年被首次提出,被譽為第三代神經網路[1]。不過這次不打算再讀論文了,我想直接找段程式碼[2]讀讀看。 此篇記錄中的程式碼和圖全都來自[2

[DeeplearningAI筆記]改善深層神經網路1.1_1.3深度學習實用層面_偏差/方差/欠擬合/過擬合/訓練集/驗證集/測試集

覺得有用的話,歡迎一起討論相互學習~Follow Me 1.1 訓練/開發/測試集 對於一個數據集而言,可以將一個數據集分為三個部分,一部分作為訓練集,一部分作為簡單交叉驗證集(dev)有時候也成為驗證集,最後一部分作為測試集(test).接下來我們開始

WebLogicServer12.2.1.3服務器無法啟動配置解決方法

splay font urn cat program 修改路徑 del 重新 exist WebLogicServer12.2.1.3安裝最後,將下圖的鉤打上,點擊完成,會打開cmd窗口,執行cmd文件開啟配置的圖形界面。

(轉載)深度學習基礎(1)——感知器

原文地址:https://zybuluo.com/hanbingtao/note/581764 轉載在此的目的是自己做個筆記,日後好複習,如侵權請聯絡我!! 深度學習是什麼? 在人工智慧領域,有一個方法叫機器學習。在機器學習這個方法裡,有一類演算法叫神經網路。神經網路如下圖所示: 上圖的每

【深度學習】Tensorflow——CNN 卷積神經網路 1

轉自https://morvanzhou.github.io/tutorials/machine-learning/tensorflow/5-04-CNN2/ 這一次我們會說道 CNN 程式碼中怎麼定義 Convolutional 的層和怎樣進行 pooling. 基於上一次卷積神經網路的介

機器學習與深度學習系列連載: 第二部分 深度學習(十三)迴圈神經網路 1(Recurre Neural Network 基本概念 )

迴圈神經網路 1(Recurre Neural Network 基本概念 ) 迴圈神經網路的特點: • RNNs 在每個時間點連線引數值,引數只有一份 • 神經網路出了輸入以外,還會建立在以前的“記憶”的基礎上 • 記憶體的要求與輸入的規模有關 當然,他的深度不只有一層:

機器學習與深度學習系列連載: 第二部分 深度學習(十)卷積神經網路 1 Convolutional Neural Networks

卷積神經網路 Convolutional Neural Networks 卷積神經網路其實早在80年代,就被神經網路泰斗Lecun 提出[LeNet-5, LeCun 1980],但是由於當時的資料量、計算力等問題,沒有得到廣泛使用。 卷積神經網路的靈感來自50年代的諾貝爾生物學獎

使用python實現深度神經網路 1

深度學習基本概念 一、實驗介紹 1.1 實驗內容 深度學習並沒有你想象的那麼難,本課程將會一邊講解深度學習中的基本理論,一邊通過動手使用python實現一個簡單的深度神經網路去驗證這些理論,讓你從原理上真正入門深度學習。 本次實驗將會帶大家學習深度學習中的一些最基本的概念,本次實驗很重要,理解這

【讀書1】【2017】MATLAB與深度學習——神經網路(1)

本章講解了單層神經網路的學習規則。 This chapter explains the learning rulesfor a single-layer neural network. 第3章討論了多層神經網路的學習規則。 The learning rules

《深度學習》摘記之前饋神經網路(1)

前饋神經網路也叫作深度前饋網路或者多層感知機,是典型的深度學習模型。前饋神經網路的目標是近似某個函式f*。例如,對於分類器,y=f*(x)對映到一個類別標籤y。通過定義一個x到y的對映y=f(x;θ),並學習引數θ的值,使對映能夠得到最佳的函式近似。 之所以被稱為前饋網路,

# [cs231n (九)卷積神經網路 ][1]

標籤(空格分隔): 神經網路 0.回顧 cs231n (一)影象分類識別講了KNN cs231n (二)講了線性分類器:SVM和SoftMax cs231n (三)優化問題及方法 cs231n (四)反向傳播 cs231n (五)神經網路 part 1:

【機器學習筆記19】神經網路(單層感知機)

【參考資料】 【1】《人工神經網路教程》 【2】《matlab 2015b 神經網路技術》 基本概念 單層感知器可以看成一個線性累加器和一個二值化閾值元器件,通常會在累加一個偏移量。由公式表達為:oj=sgn(∑i=1nwijxi+b)o_j= sgn(\s