用 sklearn 線性迴歸 擬合房價與房屋尺寸關係

線性迴歸:

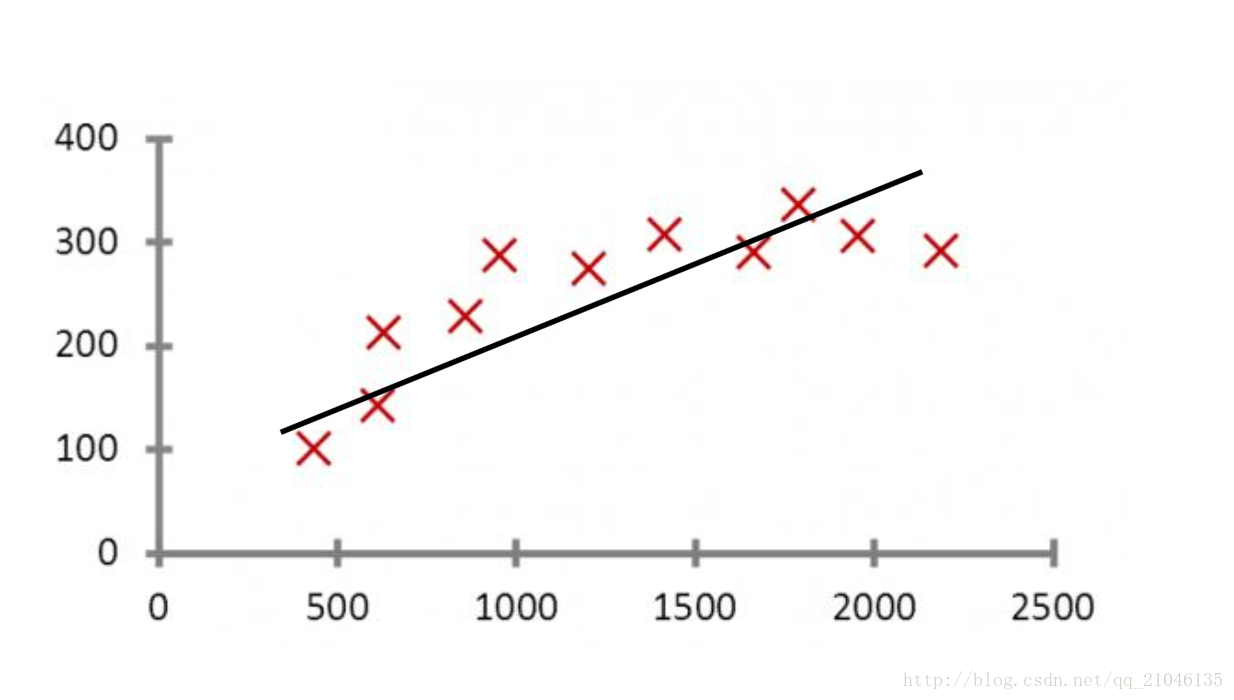

線性迴歸(Linear Regression)是利用數理統計中迴歸分析, 來確定兩種或兩種以上變數間相互依賴的定量關係的一種統計分 析方法。

線性迴歸利用稱為線性迴歸方程的最小平方函式對一個或多個自 變數和因變數之間關係進行建模。這種函式是一個或多個稱為回 歸係數的模型引數的線性組合。只有一個自變數的情況稱為簡單 迴歸,大於一個自變數情況的叫做多元迴歸。

線性迴歸:使用形如y=wTx+b 的線性模型擬合數據輸入和輸出之 間的對映關係的。

線性迴歸的實際用途

線性迴歸有很多實際的用途,分為以下兩類:

1.如果目標是預測或者對映,線性迴歸可以用來對觀測資料集的y和X 的值擬合出一個預測模型。當完成這樣一個模型以後,對於一個新增的X值, 在沒有給定與它相配對的y的情況下,可以用這個擬合過的模型預測出一個 y值。

2.給定一個變數y和一些變數X , ⋯ , Xj ,這些變數有可能與y相關,線

性迴歸分析可以用來量化y與X j 之間相關性的強度,評估出與y不相關的Xj,

並識別出哪些Xj 的子集包含了關於y的冗餘資訊。

線性迴歸的應用

背景:

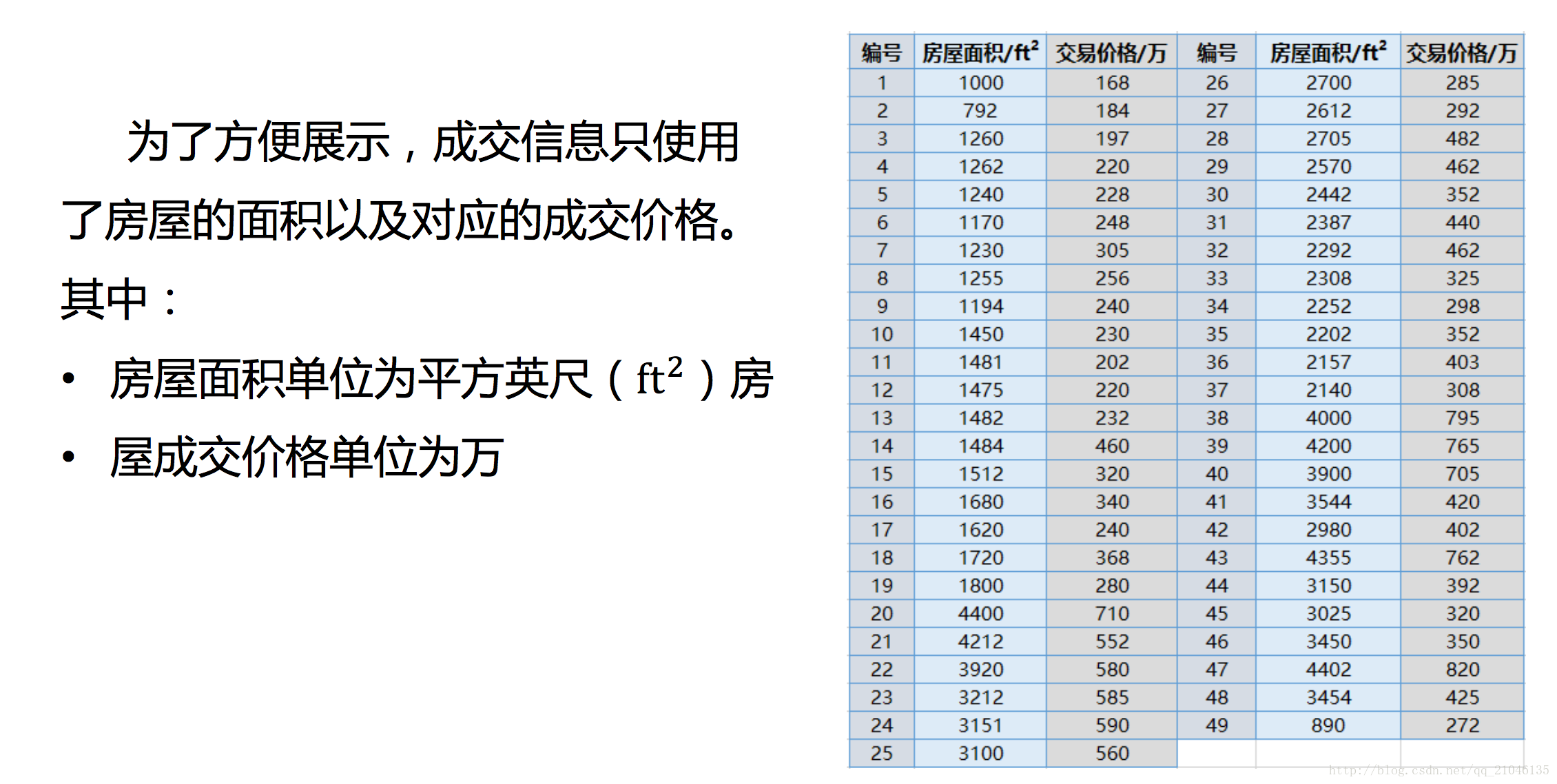

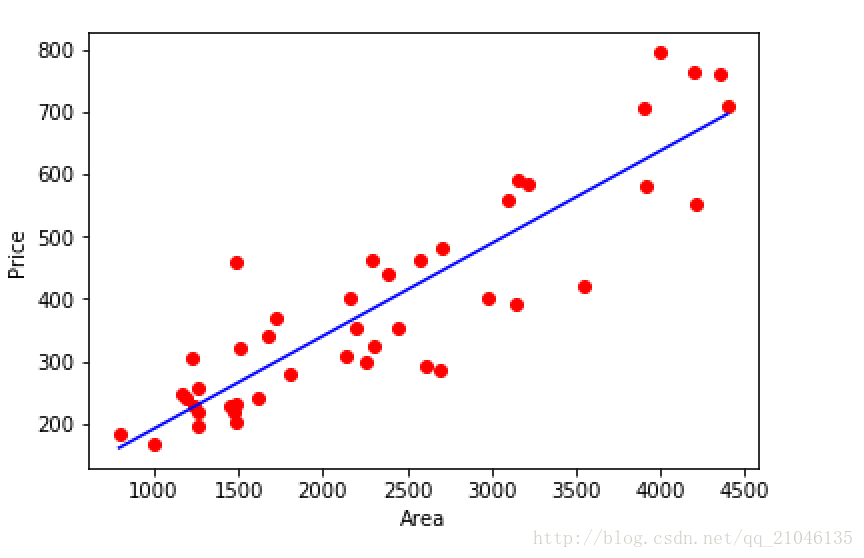

與房價密切相關的除了單位的房價,還有房屋的尺寸。我們可以根 據已知的房屋成交價和房屋的尺寸進行線性迴歸,繼而可以對已知房屋尺 寸,而未知房屋成交價格的例項進行成交價格的預測。

例項資料:

可行性分析:

• 簡單而直觀的方式是通過資料的視覺化直接觀察房屋成交價格與房 屋尺寸間是否存線上性關係。

• 對於本實驗的資料來說,散點圖就可以很好的將其在二維平面中進 行視覺化表示。

程式碼:

#!/usr/bin/env python3

# -*- coding: utf-8 -*-

"""

Created on Sun May 28 08:36:55 2017

@author: xiaolian

"""

import matplotlib.pylab as plt

import numpy as np

from sklearn import linear_model

datasets_x = []

datasets_y = []

fr = open('prices.txt', 'r')

lines = fr.readlines()

for line in lines:

items = line.strip().split(',' 結果:

相關推薦

用 sklearn 線性迴歸 擬合房價與房屋尺寸關係

線性迴歸: 線性迴歸(Linear Regression)是利用數理統計中迴歸分析, 來確定兩種或兩種以上變數間相互依賴的定量關係的一種統計分 析方法。 線性迴歸利用稱為線性迴歸方程的最小平方函式對一個或多個自 變數和因變數之間關係進行建模。這種函式

7.機器學習sklearn-------線性迴歸(房價與房屋尺寸關係的線性擬合)

1.基本概念線性迴歸(Linear Regression)是利用數理統計中迴歸分析, 來確定兩種或兩種以上變數間相互依賴的定量關係的一種統計分 析方法。 線性迴歸利用稱為線性迴歸方程的最小平方函式對一個或多個自變數和因變數之間關係進行建模。這種函式是一個或多個稱為回 歸係數的

8.機器學習sklearn---多項式迴歸(房價與房屋尺寸關係的非線性擬合)

1.基本概念多項式迴歸(Polynomial Regression)是研究一個因變數與一個或多個自變數間多項式的迴歸分析方法。如果自變數只有一個 時,稱為一元多項式迴歸;如果自變數有多個時,稱為多元多項式迴歸。 1.在一元迴歸分析中,如果依變數y與自變數x的關

scikit-learn 線性迴歸擬合正弦函式,預測房價

隨書程式碼,閱讀筆記。 線性迴歸擬合正弦函式 %matplotlib inline import matplotlib.pyplot as plt import numpy as np n_dots = 200 X = np.linspace(-2 * np.pi

keras線性迴歸擬合直線

# -*- coding: utf-8 -*- """ Created on Sat Aug 26 18:25:28 2017 線性迴歸擬合直線 @author: Han """ from keras.

迴歸:最佳擬合直線與區域性線性迴歸

迴歸是用來做什麼的? 迴歸可以做任何事,例如銷售量預測或者製造缺陷預測。什麼是迴歸? 迴歸有線性迴歸和非線性迴歸,本篇文章主要討論線性迴歸。迴歸的目的是預測數值型的目標值。最直接的辦法是依據輸入寫出一個目標值的計算公式,即所謂的迴歸方程,可表示為:

機器學習之路: python線性回歸 過擬合 L1與L2正則化

擬合 python sco bsp orm AS score 未知數 spa git:https://github.com/linyi0604/MachineLearning 正則化: 提高模型在未知數據上的泛化能力 避免參數過擬合正則化常用的方法: 在目

用線性迴歸模型預測房價

本文使用sklearn 中自帶的波士頓房價資料集來訓練模型,然後利用模型來預測房價。這份收據中共收集了13個特徵。 1.輸入特徵 import matplotlib.pyplot as plt import numpy as np from sklearn.da

sklearn實戰:使用knn進行迴歸擬合

%matplotlib inline import matplotlib.pyplot as plt import numpy as np # 生成訓練樣本 n_dots = 40 X = 5 * np.random.rand(n_dots, 1) y

用sklearn和tensorflow做boston房價的迴歸計算的比較(3)--RNN之遞迴神經網路LSTM

在tensorflow裡RNN才是做迴歸計算的正規軍,其中LSTM更是讓人工智慧有了記憶,如果cnn最適合做的是影象識別,那麼LSTM就是視訊識別。網上的教程多是用正餘弦資料在做預測,輸入輸出都是一維,我這用波士頓房價,輸入是13個特徵! 注意與前面兩個模型不同的是,沒有用

最小二乘法多項式曲線擬合原理與實現 zz

博客 del p s 並且 多項式 聯網 python mar 程序 概念 最小二乘法多項式曲線擬合,根據給定的m個點,並不要求這條曲線精確地經過這些點,而是曲線y=f(x)的近似曲線y= φ(x)。 原理 [原理部分由個人根據互聯網上的資料進行總結,希望對大

線性迴歸之波士頓房價預測

from sklearn.datasets import load_boston import numpy as np import matplotlib.pyplot as plt def feature_scalling(X): mean = X.mean(axis=0) s

機器學習--線性迴歸演算法預測房價

裡面非常詳細地介紹了微積分基本運演算法則、線性迴歸演算法、梯度下降演算法及改進。 a. 用線性迴歸方法擬合正弦函式 %matplotlib inline import matplotlib.pyplot as plt import numpy as np # 生成2

sklearn 線性迴歸簡單應用

樣本準備 import numpy as np import matplotlib.pyplot as plt # 樣本準備 train_X = np.linspace(-1, 1, 100) train_Y = 2 * train_X + np.random

【SciKit-Learn學習筆記】3:線性迴歸測算波士頓房價,Logistic迴歸預測乳腺癌

學習《scikit-learn機器學習》時的一些實踐。 線性迴歸 這部分和第一篇筆記"繪製隨機波動樣本的學習曲線 "部分基本類似。線性迴歸裡可以加入多項式特徵,以對模型做增強。 線性迴歸增加多項式特徵,擬合sin函式 import numpy as np impor

正則化線性迴歸的方差與偏差!

利用正則化線性迴歸模型來了解偏差和方差的特徵 例項: 首先根據資料建立線性迴歸模型,模型能夠根據水庫液位的變化來預測大壩的排水量,然後通過調整引數等方法來學習偏差和方差的一些特性。 1.概念 偏差:度量了學習演算法的期望預測與真實結果的偏離程度,即刻畫了學習演算法本身的擬合能力;

機器學習(二)分類器及迴歸擬合

在機器學習中,分類器作用是在標記好類別的訓練資料基礎上判斷一個新的觀察樣本所屬的類別。分類器依據學習的方式可以分為非監督學習和監督學習。非監督學習顧名思義指的是給予分類器學習的樣本但沒有相對應類別標籤,主要是尋找未標記資料中的隱藏結構。,監督學習通過標記的訓練資

手寫:邏輯迴歸擬合二維資料(tensorflow)

tensorflow開發的基本步驟 1、定義tensorflow輸入節點【3種方法】 2、定義學習引數的變數【2種方法】 3、定義運算 4、選擇優化函式,優化目標 5、初始化所有變數 6、迭代更新引數到最優解 7、測試模型 8、使用模型 下面就挑前幾個比較重要

最小二乘法多項式曲線擬合原理與實現(錯誤地方已經修改底層補充自己寫的java實現)

也可使用Apache開源庫commons math,提供的功能更強大, http://commons.apache.org/proper/commons-math/userguide/fitting.html package com.fjsh.algorithm.leastSquareMethod.d

最小二乘法曲線擬合原理與實現

最小二乘學習法是對模型的輸出和訓練集輸出的平方誤差為最小時的引數進行學習,式中之所以加上係數1/2,是為了約去對進行微分時得到的2。 “LS”是Least Squares的首字母。平方誤差是殘差的範數,因此最小二乘學習法有時也稱為損失最小化學習法。