吳恩達機器學習課程作業tips(更新中)

ex4,

一開始做的時候,卡在了代價函式這裡,建議大家用for迴圈來練習這道題目,真正理解神經網路演算法和one-vs-all演算法的不同。

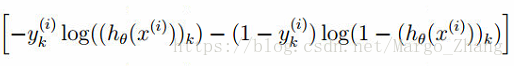

這個式子的重點在於計算

one-vs-all,十個分類器,分別做十次logistic迴歸。每一個的結果都要和y求誤差。也就是10次計算。再有5000個樣本,所以是10*5000次計算。

而對於神經網路演算法,output layer有十個units,每一個unit和對應y的unit求誤差,也就是10次計算。再有5000個樣本,所以是10*5000次計算。也就是式子中顯示的兩層求和,K*m。

而不是每一個outputlayer的unit和每一個y都求誤差,那就是10*10*5000(K*m*m)次計算。

ex5

Regularized Linear Regression a nd Bias v.s.Variance

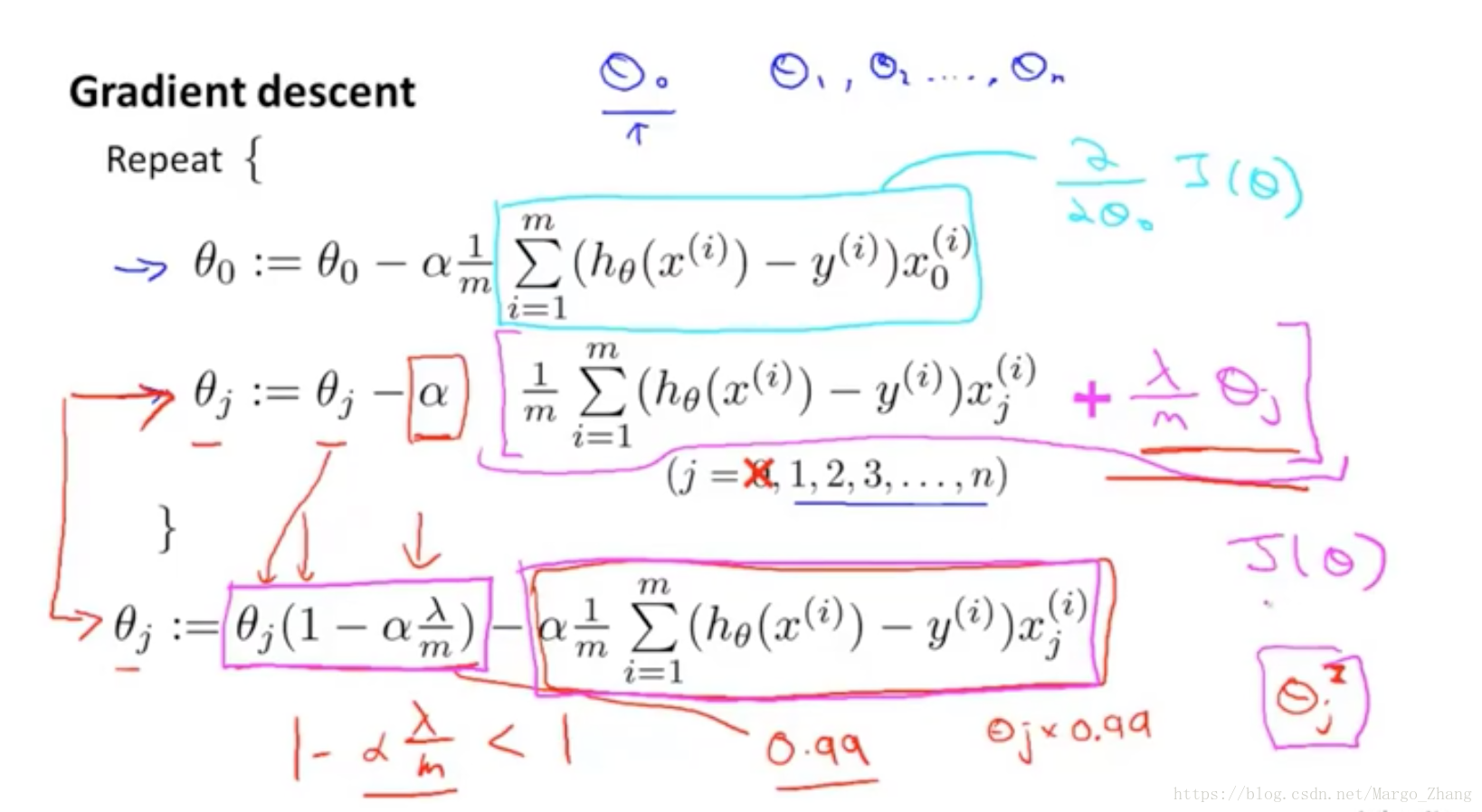

這邊的問題不大,主要是在求regularized linear regression cost function,線性迴歸正則代價函式。發現總是會給懲罰項從1開始積分,但是實數項的theta是不用積分的。

相關推薦

吳恩達機器學習課程作業tips(更新中)

ex4, 一開始做的時候,卡在了代價函式這裡,建議大家用for迴圈來練習這道題目,真正理解神經網路演算法和one-vs-all演算法的不同。 這個式子的重點在於計算 one-vs-all,十個分類器,分別做十次logistic迴歸。每一個的結果都要和y求誤差。也就是

Coursera吳恩達機器學習課程 總結筆記及作業程式碼——第5周神經網路續

Neural Networks:Learning 上週的課程學習了神經網路正向傳播演算法,這周的課程主要在於神經網路的反向更新過程。 1.1 Cost function 我們先回憶一下邏輯迴歸的價值函式 J(θ)=1m[∑mi=1y(i)log(hθ

Coursera吳恩達機器學習課程 總結筆記及作業程式碼——第1,2周

Linear’regression 發現這個教程是最入門的一個教程了,老師講的很好,也很通俗,每堂課後面還有程式設計作業,全程用matlab程式設計,只需要填寫核心程式碼,很適合自學。 1.1 Model representation 起始給出了

Coursera吳恩達機器學習課程 總結筆記及作業程式碼——第6周有關機器學習的小建議

1.1 Deciding what to try next 當你除錯你的學習演算法時,當面對測試集你的演算法效果不佳時,你會怎麼做呢? 獲得更多的訓練樣本? 嘗試更少的特徵? 嘗試獲取附加的特徵? 嘗試增加多項式的特徵? 嘗試增加λ? 嘗試減小λ?

吳恩達機器學習課程筆記02——處理房價預測問題(梯度下降演算法詳解)

建議記住的實用符號 符號 含義 m 樣本數目 x 輸入變數 y 輸出變數/目標變數

吳恩達機器學習課程筆記章節二單變數線性迴歸

1、模型描述 Univariate(One variable)Linear Regression m=訓練樣本的數目,x's=輸入的變數/特徵,y's=輸出變數/目標變數 2、代價函式 基本定義: 3、代價函式(一) 回顧一下,前面一些定義: 簡化的假設函式,theta0=0,得到假

吳恩達機器學習課程筆記——第二週

1. 多變數線性迴歸(Linear Regression with Multiple Variables) 也稱為多元線性迴歸,一元就是一個變數,多元就是多個變數,在這裡也可以叫做多個特徵 1.1 多維特徵(Multiple Features) 之前,

吳恩達機器學習課程第一週

關於線性迴歸的記錄: 使用的損失函式是平方誤差損失函式J(θ),也就是最簡單的假設函式和真實值差的平方和(對於所有樣本求和),然後最小化J(θ),也就是使用梯度下降演算法;平方誤差代價函式是解決迴歸問題最常見的手段; 對於單變數線性迴歸問題: 如果是對

吳恩達機器學習課程:完全用Python完成,可以的!(附程式碼)

新智元報道 來源:Reddit、GitHub編輯:肖琴【導讀】完全用Python完成吳恩達的

機器學習筆記--吳恩達機器學習課程2

梯度下降法 對於梯度下降法而言,當偏導數 的學習效率過大或過小時,收斂的速率會變得很緩慢,α過大時甚至會無法收斂。學習效率α是一個正數。 同樣梯度下降法初始點在區域性最低點時同樣不會再更新,此時偏導數的值為0.

學習筆記——吳恩達-機器學習課程-1.3 用神經網路進行監督學習

神經網路有時媒體炒作的很厲害,考慮到它們的使用效果,有些說法還是靠譜的,事實上到目前為止,幾乎所有的神經網路創造的經濟價值都基於其中一種機器學習,我們稱之為“監督學習”,那是什麼意思呢? 我們來看一些例子, 在監督學習中輸入x,習得一個函式

吳恩達機器學習 課程筆記第五週

Costfunction代價函式:在前面的課程總我們瞭解了邏輯迴歸的代價函式:在神經網路中,我們增加了對k個輸出的誤差進行了求和。得到代價函式如下:K為輸出的個數,在正則項中L表示神經網路的層數Backpropagation algorithm反向傳播演算法:當我們進行梯度下

Coursera吳恩達機器學習課程第一週測驗2(單變數線性迴歸)

Machine Learning Week 1 Quiz 2 (Linear Regression with One Variable) Stanford Coursera Question 1 Consider the problem of predi

吳恩達機器學習課程(一)之梯度下降原理

梯度下降法 對於線性迴歸分析,我們將假設函式定義為h(x)=θ0+θ1x1+⋯+θnxn 令x0=1,記x=(x0x1⋯xn),θ=⎛⎝⎜⎜⎜⎜θ0θ1⋮θn⎞⎠⎟⎟⎟⎟ 因為假設函式與引數θ有關,記hθ(x)=h(x)=xθ 對於每一

吳恩達機器學習課程筆記——第一週

1. 單變數線性迴歸(Linear Regression with One Variable) 1.1 模型表示 像上述公式,因為只含有一個特徵/輸入變數,因此這樣的問題叫作單變數線性迴歸問題。 例子如下: 單變數線性方程,就是我們初中就學的

Coursera吳恩達機器學習課程-第五章

五、Octave教程(Octave Tutorial) 5.1 基本操作 參考視訊: 5 - 1 - Basic Operations (14 min).mkv 在這段視訊中,我將教你一種程式語言:Octave語言。你能夠用它來非常迅速地實現這門課中我們已經學過的,或者

Coursera 斯坦福吳恩達機器學習課程筆記 (1)

看了課程一週後發現忘光了,決定做一個筆記用作複習。如果涉及到侵權問題請聯絡我,我會立馬刪除並道歉。同時,禁止任何形式的轉載,包括全文轉載和部分轉載。如需使用請聯絡本人 [email protected]。如若發現侵權行為,我學過智慧財產權法的,嘿嘿第一週:基礎概念和

學習筆記——吳恩達-機器學習課程 1.2 什麼是神經網路

1.2 什麼是神經網路 “深度學習”指的是訓練神經網路,有的時候 規模很大,那麼神經網路是什麼呢?我們從一個房價預測的例子開始,假設有一個六間房屋的資料集已知房屋的面積,單位是平房英尺或者平方米,已知房屋價格,想要找到一個函式,根據房屋面積,預測房價的函式,

吳恩達機器學習--矩形算法(三)

相關 機器 微信 alt image 簽到 理解 得到 inf 什麽是矩陣? 在數學中,矩陣(Matrix)是一個按照長方陣列排列的復數或實數集合,最早來自於方程組的系數及常數所構成的方陣。 是高等代數學中的常見工具,也常見於統計分析等應用數學學科中。 矩陣:由數字組

吳恩達 DeepLearning.ai 課程提煉筆記(4-2)卷積神經網絡 --- 深度卷積模型

mes and shift abd actual 應用 比賽 特征 通道 1. 經典的卷積網絡 介紹幾種經典的卷積神經網絡結構,分別是LeNet、AlexNet、VGGNet。 LeNet-5: LeNet-5主要是針對灰度設計的,所以其輸入較小,為 ,其結構如下: