嶺迴歸和Lasso迴歸

嶺迴歸(RR)

嶺迴歸不會拋棄任何一個係數,隨著lamda的增大,係數逐漸減小趨於零至穩定

求解方法有最小二乘(直接求係數矩陣),梯度下降。

當自變數間存在 復共線性( multimulti -collinearity)時,迴歸係數估計的方差就很大, 估計值就很不穩定。很好想象,就相當於兩列相同的特徵,你說係數一正一負可以相差很大。

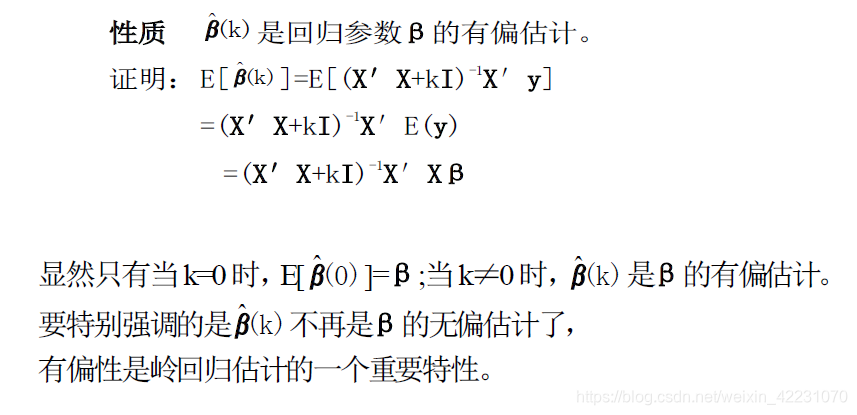

引入嶺係數,會使殘差平方和RSS變大,但對估計向量,存在一個係數,使它的均方誤差MSE小於最小二乘法的。

https://www.jianshu.com/p/1677d27e08a7

Lasso迴歸

附加項為L1範數,是不連續可導的,因此無法使用梯度下降法。

座標軸下降法(coordinate descent)和最小角迴歸法( Least Angle Regression, LARS)

相關推薦

嶺迴歸和Lasso迴歸

嶺迴歸(RR) 嶺迴歸不會拋棄任何一個係數,隨著lamda的增大,係數逐漸減小趨於零至穩定 求解方法有最小二乘(直接求係數矩陣),梯度下降。 當自變數間存在 復共線性( multimulti -collinearity)時,迴歸係數估計的方差就很大, 估計值就很不穩定。很好想象,就相

機器學習 of python(嶺迴歸和Lasso迴歸)

注:正則化是用來防止過擬合的方法。在最開始學習機器學習的課程時,只是覺得這個方法就像某種魔法一樣非常神奇的改變了模型的引數。但是一直也無法對其基本原理有一個透徹、直觀的理解。直到最近再次接觸到這個概念,經過一番苦思冥想後終於有了我自己的理解。 0. 正則化(Regu

嶺迴歸和lasso迴歸的r語言程式碼

setwd("C:/Users/IBM/Desktop/研一課程/2.2迴歸分析/迴歸作業") #設定當前的工作目錄 shuju=read.table("shuju.txt",header=T) shuju #讀取資料 #使用lm.ridge來進行嶺迴歸,其好處是可通

scikit-learn機器學習(二)--嶺迴歸,Lasso迴歸和ElasticNet迴歸

多元線性迴歸模型中,為了是均方差誤差最小化,常見的做法是引入正則化,正則化就是給對模型的引數或者說是係數新增一些先驗假設,控制模型的空間,使模型的複雜度較小。 正則化目的:防止過擬合 正則化本質:約束要優化的引數 正則化會保留樣本的所有特徵向量,但是會

最小二乘迴歸,嶺迴歸,Lasso迴歸,彈性網路

普通最小二乘法 理論: 損失函式: 權重計算: 1、對於普通最小二乘的係數估計問題,其依賴於模型各項的相互獨立性。 2、當各項是相關的,且設計矩陣 X的各列近似線性相關,那麼,設計矩陣會趨向於奇異矩陣,這會導致最小二乘估計對於隨機誤差非常敏感

機器學習:線性迴歸、嶺迴歸、Lasso迴歸

轉載自:https://blog.csdn.net/hzw19920329/article/details/77200475 線性迴歸作為一種迴歸分析技術,其分析的因變數屬於連續型變數,如果因變數轉變為離散型變數,將轉換為分類問題。迴歸分析屬於有監督學習問題,本部落格將重點回

Bobo老師機器學習筆記第八課-方差、偏差、嶺迴歸、LASSO迴歸?

對誤差分類 問題一、什麼是偏差和方差? 先看下面這幅圖圖: 方差: 都是圍著資料中心的,方差越大則表示距離資料中心分佈的越分散,越小說明越近越集中 偏差: 偏離資料中心, 偏差越大,說明整個資料距離中心越遠,偏差越小,說明距離資料中心越近。 這兩者的關係通常是矛盾的,降低偏

嶺迴歸與lasso迴歸

a. 什麼是嶺迴歸和lasso迴歸?為什麼要用嶺迴歸和lasso迴歸?嶺迴歸選參的一般原則是什麼。 對OLS進行範數1正則化叫Lasso迴歸。 對OLS進行範數2正則化叫嶺迴歸。 進行嶺迴歸和Lasso迴歸的主要目的: 1.解決病態矩陣的過擬合和欠擬合問題。 2

【機器學習】正則化的線性迴歸 —— 嶺迴歸與Lasso迴歸

注:正則化是用來防止過擬合的方法。在最開始學習機器學習的課程時,只是覺得這個方法就像某種魔法一樣非常神奇的改變了模型的引數。但是一直也無法對其基本原理有一個透徹、直觀的理解。直到最近再次接觸到這個概念,經過一番苦思冥想後終於有了我自己的理解。 0. 正則化(

線性迴歸、嶺迴歸、Lasso迴歸、邏輯迴歸的總結

對於所有的模型和演算法,都有一個目標方程,比較理想的目標方程應該有兩部分構成:損失函式和正則項,一個用來衡量模型的擬合效果,一個用來儘可能保證模型的簡單和穩定: Obj(Θ)=L(Θ)+Ω(Θ)(2)(2)Obj(Θ)=L(Θ)+Ω(Θ) 損失函式: 平方

分別使用普通線性迴歸、嶺迴歸、lasso迴歸預測鮑魚年齡

1.匯入相關模組 import numpy as np import pandas as pd from pandas import Series,DataFrame #機器學習的普通線性模型、嶺迴歸模型、lasso模型 from sklearn.linea

Ridge和lasso迴歸實現的一個小案例

來自於鄒博機器學習第七期第九課中的內容:簡單介紹就是一個產品的銷量sales與TV、radio、newspaper三個投入量之間的關係。 直接上程式碼: import numpy as np imp

資料學習(1)·線性迴歸和Logistic迴歸

本系列是作者上課時記錄的筆記整理,同時有對應的作業習題,自學的同學參考部落格同步即可。郵箱聯絡[email protected] Preview: 監督學習(第一部分) 線性迴歸 Logistic迴歸 Softmax迴歸

Ridge迴歸、Lasso迴歸

最小二乘法: 目標函式=∑(觀測值-理論值)² J(θ)=1/2(Xθ−Y)T (Xθ−Y) 迭代的表示式是: θ=(XT X+αE)−1 XT Y 其中E為單位矩陣。 Ridge迴歸: 通過對係數的大小施加懲罰來解決普通最小二乘法的一些問題。它和一般線性迴歸的 區別是在損失

【番外】線性迴歸和邏輯迴歸的 MLE 視角

線性迴歸 令 z = w

tensorflow實現線性迴歸和邏輯迴歸

關於線性迴歸和邏輯迴歸的原理和python實現,請左轉:邏輯迴歸、線性迴歸。 這裡就直接貼程式碼了。 線性迴歸: # -*- coding: utf-8 -*- """ Created on Thu Aug 30 09:40:50 2018 @author: 96jie """ im

線性迴歸和邏輯迴歸區別

線性迴歸和邏輯迴歸 線性:y=a*x 是一次方的變化 迴歸:迴歸到平均值 線性迴歸用作迴歸預測 邏輯迴歸用作二分類,也可以做多分類 從資料上來講,線性迴歸的樣本的輸出,都是連續值 邏輯迴歸中y只能取0或者1。 從擬合函式講,線性迴歸: 邏輯迴歸: 邏輯迴歸實際上就是在多元線性迴歸

線性迴歸和邏輯迴歸的區別

迴歸問題的條件/前提: 1) 收集的資料 2) 假設的模型,即一個函式,這個函式裡含有未知的引數,通過學習,可以估計出引數。然後利用這個模型去預測/分類新的資料。 1. 線性迴歸 假設 特徵 和 結果 都滿足線性。即不大於一次方。這個是針對 收集的資料而言。 收集的資料中,每一個分量,就

線性迴歸和邏輯迴歸介紹

概述 線性迴歸和邏輯迴歸是機器學習中最基本的兩個模型,線性迴歸一般用來解決預測問題,邏輯迴歸一般解決分類問題,線性迴歸模型和邏輯迴歸模型之間既有區別又有關聯。 線性迴歸模型 假定訓練資料集為

Machine Learning--week3 邏輯迴歸函式(分類)、決策邊界、邏輯迴歸代價函式、多分類與(邏輯迴歸和線性迴歸的)正則化

Classification It's not a good idea to use linear regression for classification problem. We can use logistic regression algorism, which is a classificati