ROS 使用RGB-D攝像頭

更多SLAM文章請參閱:https://zhuanlan.zhihu.com/slamTech

參考網址:http://wiki.ros.org/openni_camera

** 安裝驅動包**

$ sudo apt-get install ros-indigo-openni-camera

$ sudo apt-get install ros-indigo-openni-launch

** 初步測試**

執行

$ roslaunch openni_launch openni.launch

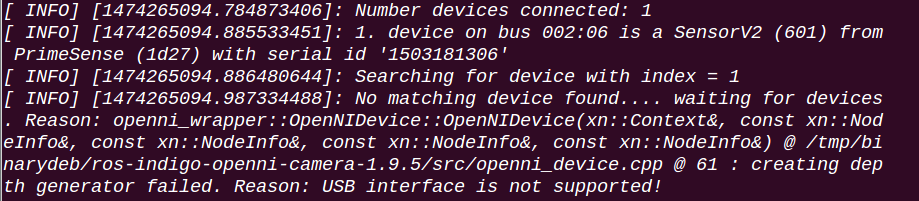

出現以下錯誤:

解決方案:

修改GlobalDefaults.ini配置檔案

$ sudo gedit /etc/openni/GlobalDefaults.ini

將第60行前面的分號去掉(即取消註釋)

UsbInterface=2

再次執行

$ roslaunch openni_launch openni.launch

正常

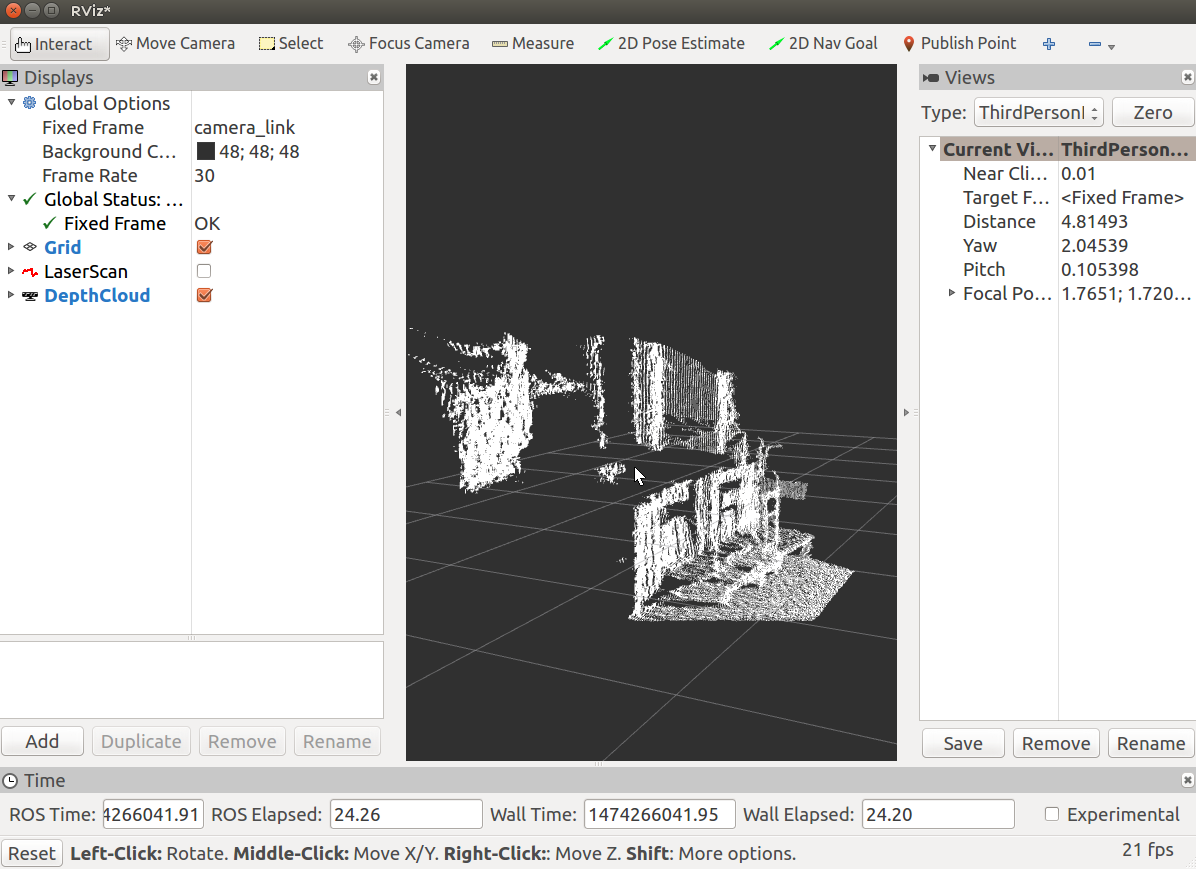

** 開啟rviz檢視影象**

相關推薦

ROS 使用RGB-D攝像頭

更多SLAM文章請參閱:https://zhuanlan.zhihu.com/slamTech 參考網址:http://wiki.ros.org/openni_camera ** 安裝驅動包** $ sudo apt-get install ros-indigo-openni-c

在ROS下,攝像頭kinect V1的RGB圖和深度圖的獲取

驅動安裝好後,首先在終端輸入“roscore”,啟動節點,然後在新的終端輸入“roslaunch freenect_launch freenect-registered-xyzrgb.launch”或者“roslaunch freenect_launch freenect

Kinect2通過ROS跑ORB_SLAM2 下RGB-D介面

寫在前面 上一篇文章,記錄了Ubuntu下安裝Kinect2的驅動,以及在ROS下執行bridge.現在已經迫不及待的要跑下ORB-SLAM2下的RGB-D介面。 修改ORB-SLAM2 安裝好Kinect2的驅動後,執行: roslaunch kinect_br

論文筆記 Locality-Sensitive Deconvolution Networks with Gated Fusion for RGB-D Indoor Semantic Segmentation

extract pear rain bsp ble rgb oge nbsp png 用於RGB-D室內語義分割的具有門控融合的局部敏感反卷積網絡 abstract problem: indoor semantic segmentation using RGB

在ROS中開啟攝像頭_詳細步驟

系統要求 ROS版本:kinetic 安裝步驟 安裝驅動包 usb_cam $ cd catkin_ws/src $ git clone https://github.com/bosch-ros-pkg/usb_cam.git $ cd .

ROS下使用攝像頭

轉載自:https://blog.csdn.net/wilylcyu/article/details/51732710 1 . 前言 在ROS下常用的主要有兩種驅動包:usb_cam和uvc_cam。 2 .usb_cam安裝 在工作空間中採用原始碼安裝: $ cd ca

《Frustum PointNets for 3D Object Detection from RGB-D Data》論文及程式碼學習(二)程式碼部分

《Frustum PointNets for 3D Object Detection from RGB-D Data》論文及程式碼學習(二)程式碼部分 文章目錄 《Frustum PointNets for 3D Object Detection from RG

《Frustum PointNets for 3D Object Detection from RGB-D Data》論文及程式碼學習

《Frustum PointNets for 3D Object Detection from RGB-D Data》論文及程式碼學習 《Frustum PointNets for 3D Object Detection from RGB-D Data》一文是Charles R.Qi

史上最詳盡的RGB-D感測器選型調研報告

最近專案要用到深度相機來進行位姿估計,故詳細調研了一下市場上在售的深度相機,寫了一份調研報告。 一、目前市場上深度相機主要有以下系列: 排除Leap Motion,最大工作範圍0.6米;排除Structure Sensor,要搭配ipad/iphone使用;華碩xtion Pro較

用ROS驅動USB攝像頭的三種方法

參考: ROS機器人程式設計(原書第2版)-恩裡克.費爾南德斯:第5章 計算機視覺 方法1: 使用usb_cam這個ROS包直接驅動 方法2: 使用gscam這個ROS包直接驅動 方法3: 自制OpenCV,cv_bridge,image_transport驅動ROS包

[SLAM](番外篇):一起做RGB-D SLAM(5)

本文轉自高翔老師的部落格,建議在學完教程的第二講後,插入學習,做到工程快速入門。 原文連結:https://www.cnblogs.com/gaoxiang12/p/4719156.html Visual Odometr

[SLAM](番外篇):一起做RGB-D SLAM(4)

本文轉自高翔老師的部落格,建議在學完教程的第二講後,插入學習,做到工程快速入門。 原文連結:https://www.cnblogs.com/gaoxiang12/p/4669490.html 上講回顧 上一講中,我們理解了如

[SLAM](番外篇):一起做RGB-D SLAM(3)

本文轉自高翔老師的部落格,建議在學完教程的第二講後,插入學習,做到工程快速入門。 原文連結:https://www.cnblogs.com/gaoxiang12/p/4659805.html

[SLAM](番外篇):一起做RGB-D SLAM(7)

本文轉自高翔老師的部落格,建議在學完教程的第二講後,插入學習,做到工程快速入門。 原文連結:https://www.cnblogs.com/gaoxiang12/p/4754948.html 添加回環檢測 簡單迴環檢測的流程

[SLAM](番外篇):一起做RGB-D SLAM(6)

本文轉自高翔老師的部落格,建議在學完教程的第二講後,插入學習,做到工程快速入門。 原文連結:https://www.cnblogs.com/gaoxiang12/p/4739934.html 圖優化工具g2o的入門 在上一講

RGB-D 稠密slam相關論文整理

綜合方向梳理 瞭解一下RGB-D SLAM中各開原始碼的效能對比以及所使用方法的異同。 Davison實驗室套餐 Elastic Fusion: DynamicFusion Dynamic

一起做RGB-D SLAM 第二季 (一)

小蘿蔔:師兄!過年啦!是不是很無聊啊!普通人的生活就是賺錢花錢,實在是很沒意思啊! 師兄:是啊…… 小蘿蔔:他們都不懂搞科研和碼程式碼的樂趣呀! 師兄:可不是嘛…… 小蘿蔔:所以今年過年,我們再做一個SLAM吧!之前寫的那個太爛了啦,我都不好意

一起做RGB-D SLAM(7) (完結篇)

1 /************************************************************************* 2 > File Name: rgbd-slam-tutorial-gx/part V/src/visualOdometry.cpp

RGB-D SLAM學習總結(3)

第三講 特徵提取和匹配 本講主要實現影象的特徵提取,影象間的匹配,以及相機轉換矩陣的求解。 高博的部落格中提供了兩幀影象做測試,就是這兩幀影象。。。千萬不要另存為。。。 由於具體程式碼已經有詳細介紹,這裡只往slamBase裡新增方法。 另外在使用的slambase標

RGB-D SLAM學習總結(5)

第五講 VO實現 本講基於前面的工作,實現一個簡單的視覺里程計。 首先在parameters.txt中新增相應的引數: # part 5 # 資料相關 # 起始與終止索引 start_index=1 end_index=780 # 資料所在目錄 rgb_dir=../